在人工智能领域,基准测试长期被视为衡量进步和推动竞争的关键工具。从早期的图像分类数据集到自然语言处理的问答基准,排行榜、领导者榜单和论文对比促成了快速迭代与大量工程投入。然而,当模型在既定基准上持续取得接近或超过人类水平的成绩时,另一个问题悄然出现:基准测试饱和。基准测试饱和不是简单的分数瓶颈,而是一系列系统性失灵的集合,它会导致研究方向的偏移、指标异化以及对现实能力的高估。要解决这一问题,仅靠更多数据或更大模型并不足够,需要把评估置于更广阔的系统视角来重构设计与治理。 基准测试饱和的核心在于衡量工具与目标之间关系的失配。

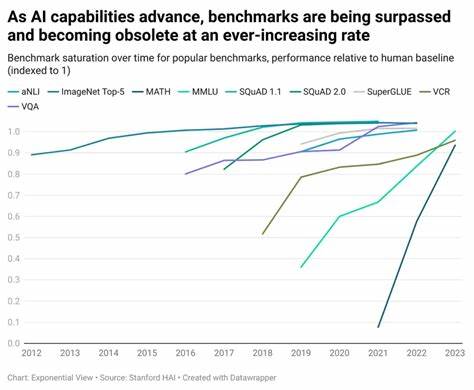

当某个基准成为主流时,参与者会围绕该基准优化模型、数据处理、提示工程甚至训练过程的每一个细节。基于好哈特定律,任何被当作目标的度量都将失去作为良好指标的价值。模型在某一数据集中表现优异,不代表其在更广泛的现实情境中同样可靠。历史上多个著名案例都证明了这一点。图像识别领域在 ImageNet 上的突破曾被视为通向通用视觉理解的里程碑,但随后的研究揭示了对背景模式、标签偏差以及数据泄露的敏感性。自然语言处理领域中 GLUE、SuperGLUE、SQuAD 等基准推动了模型能力的显著提升,但研究者也发现许多模型通过简单的统计捷径或表面模式就能取得高分,而非真正理解语义或推理。

基准测试饱和引发的第一个风险是过拟合研究议程。研究者和工程团队在资源有限的情境下,会优先优化那些被期刊、基金和客户认可的指标。这种资源分配导致对边缘问题、长尾场景和系统级风险的忽视。短期内,排行榜上的排名提升似乎带来竞争优势,但长期看,整个生态的风险承受能力下降。第二个风险是指标的失真与误导。单一维度的领先并不能反映模型的鲁棒性、公平性、可解释性或安全性。

企业在决策时若仅看基准分数,可能在部署后面对性能崩溃、歧视性输出或难以监控的行为。第三个风险来自反馈回路:模型在生产环境中表现如何,会反过来影响未来训练数据和评估基准,形成自我强化的偏差。例如,由于某些系统广泛采用特定模型,用户交互数据就会倾向于这些模型的风格,进一步强化同类模型的优势,弱化多样性。 这些风险表明,解决基准测试饱和不能仅靠设计更多复杂基准或扩大测试集规模。相反,需要从系统层面重新构想评估的目标、结构和治理机制。系统思维要求我们把评估视为一个嵌入在科研、工程、市场和社会中的动态过程,而不是静态的分数竞赛。

首先,评估体系应当更强调多尺度、多元化的考量。单一的精度或准确率需要与鲁棒性测试、域泛化评估、对抗样本实验、伦理与公平性检验、资源消耗估计以及可解释性指标并列。把这些维度整合进常态化评测能够减少对单一排行榜的依赖,鼓励跨学科的改进。其次,基准设计应当体现动态生命周期管理。一个好的基准需要明确其采集时间、覆盖范围与假设边界,并在可预见的时间窗口内进行更新或退役。静态基准在面对数据分布漂移和社会变迁时会逐渐失去代表性,定期引入新的任务、样本与评价方法可以缓解饱和问题。

第三,评估管道需要透明与可复现的基础设施支持。公开数据源、可验证的隐藏测试集、可审计的评测脚本以及标准化的基线实现是防止数据泄露和指标操纵的基本措施。更进一步,采用盲测和第三方复审可以减少"针对已知基准调参"的投机式改进。 在实践层面,可以通过多个互补策略来实施系统化评估。动态基准是其中一项重要措施:通过周期性更新测试集、引入合成对抗样本以及随机化评测条件,使得简单的过拟合手段难以奏效。多任务与跨领域评测则能衡量模型的迁移能力和泛化潜力,避免对单一任务的过度优化。

结合模拟和现实世界数据可以在保证可控性的同时检验模型在复杂环境中的表现。与此同时,引入人为红队与开源社群的参与能发现未被传统基准覆盖的失败模式,提供多元视角。 治理与激励设计也是系统思维不可或缺的一环。学术和产业激励若过度强调排行榜,会促成短视优化。相应地,需要改造激励机制以奖励对安全性、解释性、可复现性和长期可持续性的研究。期刊、会议和资助机构可以通过要求更全面的评估报告、更严格的基准更新日志和更多负结果的公开来推动变革。

企业在采购和部署 AI 产品时,应当把基准分数作为参考而非唯一决策依据,建立部署前的现场试验、部署后的持续监控与可回退机制。监管机构也可以通过标准制定、审计要求和透明度指南,督促关键领域采用更加系统化的评估流程。 技术层面的改进同样重要。度量体系需要融入不确定性估计和置信区间而非仅报告点估计分数,这有助于在面对数据漂移时做出更谨慎的决策。对模型进行分层测试,既包括常见情形也包括极端边界条件与长尾场景,可以揭示潜在脆弱点。对抗训练、鲁棒性正则化与域自适应方法能提升模型的泛化能力,但这些方法本身也需要在多样化评估中验证其副作用。

解释性工具与行为检测机制可以作为额外的守门员,帮助发现模型在特定输入上的异常决策路径。 教育与社区文化的转变也是长效之策。培养研究者把评估视为与模型设计同等重要的工程活动,提升数据伦理、测量误差和系统动力学的基础知识,是减少基准饱和负面影响的教育路径。开放科学与协作评测平台可以促成更多跨机构的基准维护与监督,避免由少数机构主导单一评测议程。行业与学术界共同制定基准治理的最佳实践,公开分享失败案例和负结果,能够逐步建立更成熟的评估生态。 总之,基准测试饱和问题提醒我们:评估不是中立的实验工具,而是会塑造研究路线与市场行为的社会技术系统。

对抗饱和现象需要超越"再造一个更难的基准"的短期思维,转向系统思维,重构评估的目标、流程和治理。通过多维度考量、动态基准管理、透明与可复现的评测基础设施、合理的激励机制、技术上的鲁棒性增强以及教育与社区协作,我们可以把评估从单一分数的竞赛演化为支持稳健、安全与负责创新的长期机制。只有这样,人工智能的进步才能真正惠及广泛的实际场景,而不是被局限在一系列已知测试的表面分数之上。 。