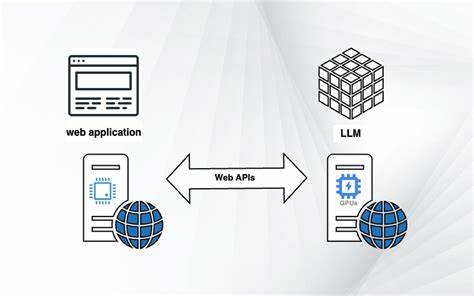

在人工智能领域,大型语言模型(LLM)如ChatGPT的出现无疑改变了我们的工作与生活方式。当前,大部分LLM的调用依赖于云端服务,这种模式虽保证了强大的计算能力和数据处理能力,但也带来了高成本、高延迟及数据隐私等问题。随着本地AI推理硬件的逐渐成熟,尤其是像苹果等厂商在本地推理领域的硬件优化和NVDA股票的持续增长,业内纷纷关注的焦点转向了何时浏览器将原生支持本地大型语言模型的JavaScript API,诸如window.ai接口的出现。一个标准化的Web接口,允许网页应用直接调用运行在本地的模型,无疑将引发人工智能与网页交互领域的新革命。 目前,尽管我们已经拥有诸如WebGL、IndexedDB、WebUSB等多种标准API,用于图形渲染、存储以及设备通信,这些接口极大地丰富了网页应用的能力。但对于大型语言模型的本地部署与调用,我们仍缺乏一个统一、标准化的解决方案。

这不仅限制了开发者的创新空间,也使得用户通常不得不依赖第三方云服务,如OpenAI提供的API,既面临数据隐私风险,也承载着不可忽视的成本压力。 如果浏览器未来能集成window.ai这样的本地LLM调用接口,将极大地拓展本地推理的应用范围。用户将能在无需持续联网的情况下调用复杂的语言模型,提升交互效率与响应速度。此外,本地运行可以更好地保障数据安全,因为数据无需频繁传输至云端存储和处理,从而降低了数据泄露的风险。这对注重隐私保护的用户和企业来说,是一个重大的利好。 除了隐私和成本因素外,本地LLM API的普及也将推动AI应用生态的进一步多样化。

开发者可以自由设计结合本地和云端模型的混合推理架构,既享受本地快速响应,也能调用云端更大模型来弥补本地计算资源的不足。这样的平衡一旦达成,将使AI-powered网页应用变得更加智能高效,并广泛普及到教育、医疗、游戏等多个领域。 我们已见证了一些浏览器厂商的初步尝试。例如,Opera浏览器在其原生AI助手Aria中集成了大型语言模型的支持,尽管目前尚未开放相关JavaScript接口,但这显然是一个积极信号。随着行业标准的推动和技术壁垒的逐步突破,window.ai或类似的本地LLM标准接口即将成为现实,带动整个Web生态系统进入新纪元。 当然,在实现这一愿景的道路上,仍有一系列技术、标准和安全问题需要解决。

如何确保不同模型的兼容性与互操作性,如何有效管理模型的存储和加载,以及如何防止潜在的安全威胁和滥用,都是关键课题。此外,开发者社区和标准组织的积极参与将加速这一进程,推动制定开放且规范的接口标准。 短期内,基于WebAssembly等技术的本地推理解决方案已经成为探索的热点。多款轻量级开源模型可以通过WebAssembly在浏览器端运行,为window.ai标准的推广奠定了坚实基础。同时,芯片厂商如英伟达、苹果的硬件优化也为本地推理提供了条件支持。未来,或许我们能够在浏览器中实现无缝调用本地AI模型,彻底改变我们与互联网交互的方式。

总而言之,随着技术的发展和市场需求的推动,本地大型语言模型网页API的出现已箭在弦上。它不仅会提升个人隐私保护,降低用户和企业的AI使用成本,还将激发创新应用,推动Web智能化进程进入新高度。window.ai标准的建立,将成为连接本地智能与云端资源的桥梁,带领AI应用迈向更加民主化和普及化的新时代。对于开发者、用户乃至整个互联网生态,这都将是一个值得期待的变革。 。