近年来,机器学习在各个领域取得了显著进展,尤其得益于梯度下降类算法的成功应用。然而,传统上这些算法常常被看作简单的数值优化工具,缺乏更深层次的数学理解。事实上,梯度下降过程本质上是微分几何中流形(manifold)上的一种运动。通过微分几何的视角,我们能够更系统地理解优化过程中的结构特性和动力学行为,从而促进更高效和精准的算法设计。微分几何以流形作为连续空间的抽象模型,形象地描述了数据和参数空间的局部性质。流形是一个空间,其任一点邻域局部看起来类似于欧几里得空间,这种局部近似性允许我们将微积分和线性代数的工具运用到更广泛的非线性空间中。

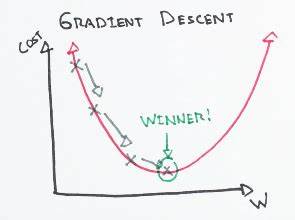

在机器学习中,模型参数通常构成一个流形,而梯度下降便是在这个参数流形上沿着损失函数梯度的反方向进行的迭代更新。理解这一过程,首先需掌握流形及其维度的含义。流形的维度对应于其分解为局部欧几里得空间的自由度数。举例而言,二维球面是一个二维流形,尽管它嵌入三维空间,我们仍能在球面上每一点局部通过两个独立方向的扰动来描述附近的点。更一般地,通过光滑函数的正则值集合理论,我们可以将许多复杂空间表述为流形,实现对其性质的形式化刻画。为了捕捉流形上点的微小变化,微分几何引入了切向量和切空间的概念。

切向量不再仅仅是被附着于点的箭头,更被视作定义于该点处的微分算子,它能够对流形上的函数进行线性微分操作。切空间则是所有切向量构成的向量空间,代表在该点所有可能的微小运动方向。对应地,协切空间由所有切空间的线性函数构成。协切向量可以视为对切向量的线性测量,因而函数的全微分自然地被看成协切向量。将这些局部结构收集起来,分别形成切丛和协切丛,构成了流形上的基本矢量丛结构,允许我们研究沿着流形的方向场和微分形式。在刻画流形的度量性质时,度量张量发挥了核心作用。

度量是一种双线性的、对称且正定的张量场,它赋予流形上的切空间一个内积结构,从而定义了距离和角度,进而得到了曲线长度、流形体积等概念。对机器学习而言,度量决定了参数空间中的梯度如何被定义和测量,影响着梯度下降的轨迹和收敛速度。特别地,有了度量,才能将函数的微分(协切向量)转换为梯度(切向量),实现梯度下降的移动方向。这一转换称作度量诱导的“升尖”映射(sharp map),在欧氏空间中即为最自然的坐标对应关系。在深度学习参数空间中,我们通常默认其为欧式度量空间,这是标准梯度下降的基础。然而,如果给予参数空间其他度量,就会得到如谱范数等特殊度量,这些度量对应的优化算法则具有不同的收敛特性,例如Muon和Shampoo优化器。

这一观点揭示了优化算法的设计本质上是对参数流形度量结构的选择和调整。进一步地,通过参数空间上的度量,我们得以将参数变化“推送”至函数空间,形成所谓的神经切线核(Neural Tangent Kernel,NTK)。NTK作为一种核方法,捕捉了模型参数微小扰动对函数输出的影响,成为理解宽神经网络训练与泛化能力的重要工具。NTK的定义基于对参数空间度量张量的推前映射,将参数空间的度量传递至函数空间。这样,梯度流在参数空间中对应的变化,可以被转译成函数空间中对应的函数变化,使得对神经网络训练过程的分析从参数空间转向更具抽象意义的函数空间。通过NTK,我们能更好地理解神经网络训练中的收敛机制,以及为何宽层网络的训练表现出近似线性模型的性质。

此外,NTK框架促进了许多基于内积核的分析方法,增进了机器学习理论的发展。为了构建这些微分几何框架,我们必须熟悉切空间与协切空间,向量丛的整体结构,以及流形上映射对各类切向量和协切向量的推前和拉回操作。这些操作保证了在不同流形之间的几何对象能以自然且一致的方式对应,确保梯度、度量、核函数等定义的数学严谨性。总之,微分几何为我们提供了一种将机器学习中复杂优化过程几何化的语言,帮助我们揭示梯度下降的本质。流形和度量赋予参数空间结构,切向量和协切向量描述了局部变化方向,推前与拉回操作刻画了映射作用,而神经切线核则将这些抽象结构与训练动态和泛化联系起来。随着深度学习模型规模的扩大及复杂性的增加,未来基于微分几何的理论可能会成为设计更高效、更稳定优化算法的关键。

通过深入理解和应用微分几何工具,研究者能够探索参数空间更为复杂的结构特性,突破传统优化方法的瓶颈,推动机器学习向更广泛和更深层的应用迈进。