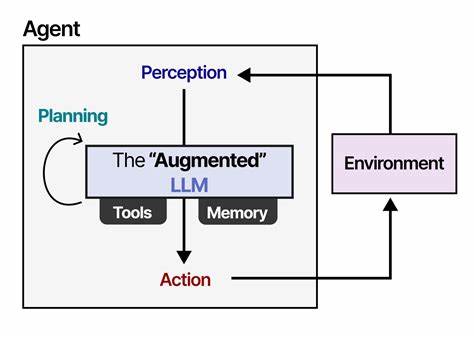

随着人工智能技术的快速发展,大型语言模型(LLMs)在自然语言理解和生成领域取得了惊人的进展。然而,这些模型仍然面临着因上下文长度限制带来的瓶颈,尤其是在需要长时序推理和复杂多步骤任务的场景中,表现受到显著影响。传统方法通常受限于GPU内存和位置嵌入的限制,导致推理精度和效率难以兼顾。针对这一难题,香港科技大学团队提出了Thread Inference Model(TIM)及其推理运行时系统TIMRUN,开创了单一语言模型内实现超长时间跨度推理的新途径。TIM的核心思想是将自然语言生成视作推理树的过程,而非简单的线性序列。推理树不仅包含了任务本身,还细化为递归的子任务、独立的思考节点及最终结论。

通过这种分层结构,模型能够系统化地拆解复杂问题,逐步递归解决,极大提高了推理的深度和宽度。此外,TIM借助一种基于规则的子任务剪枝机制动态管理模型的工作记忆。该机制根据当前推理节点的重要性筛选保留关键的键值对状态,有效复用位置嵌入和GPU内存页,避免了GPU资源的无效占用。如此一来,TIMRUN运行时能够维持高强度的推理吞吐,甚至在操作高达90%键值缓存时依旧保持流畅运行。这项技术突破了传统上下文窗口的限制,使LLM在单次推理中支持近乎无限的工作记忆容量,并能灵活调用多跳工具辅助,广泛适用于数学推理、信息检索及复杂决策场景。TIMRUN的推理方式并非事先确定的深度优先或广度优先搜索,而是动态自回归展开推理树的结构。

在执行过程中,工具调用与子任务剪枝同步进行,确保了任务规划的动态展开与调整,具备强大的自我校正能力和依赖管理能力。此特性使得模型能够在面对多变且依赖性强的任务时,灵活适应并实时调整行动方案。从应用层面看,TIM与TIMRUN为AI助手带来了革命性的提升。过去用户体验层面常见的断点或重启对话的需求大幅减少,使得AI能持续追踪复杂任务的多个阶段,提供更连贯和深度的辅助。同时,随着模型推理能力的增强,学术研究、产品设计和信息检索等多领域均可受益于这一长时序推理框架。社区与业界针对TIM及其开源实现表现出极大兴趣。

许多开发者和创业者看到其解决方案有助于克服多任务处理和记忆限制,期待未来TIMRUN的持续开放和升级。团队承诺将逐步公开数据集和系统示例,推动学术和工业界的合作共赢。总的来说,Thread Inference Model和TIMRUN代表了人工智能领域克服上下文局限、实现高效长时序推理的重要里程碑。它不仅为LLM的能力扩展提供了理论与实践基础,也为未来智能助手的发展描绘了新的蓝图。随着相关技术的不断优化,长时序、大规模推理将成为AI应用的标配,使人工智能更贴近复杂人类思维和实际需求。