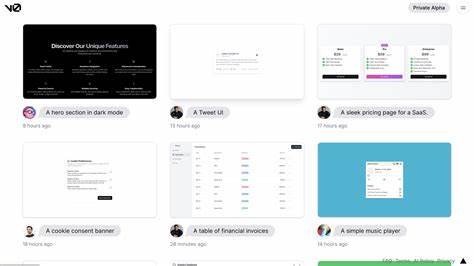

随着人工智能技术的快速发展,越来越多简便高效的工具涌现出来,极大便利了网站开发和内容创建。Vercel v0便是其中一款基于生成式人工智能的前端开发工具,允许用户通过简单的文本提示快速生成基础的登录页面或完整的应用程序界面。然而,正如科技进步带来便利的同时也催生新挑战,近期安全研究机构Okta揭露,Vercel v0已被网络攻击者利用,成为创建欺诈网站的新利器。 Vercel v0的设计初衷是降低网站和应用开发的门槛,通过自然语言指令自动生成对应的前端代码和页面,使得即使非专业开发者也能快速搭建功能页面。这种自动化大大加快了网页生产流程,但不幸的是,犯罪分子正利用这一特性在可信赖的平台基础上制造高度逼真的钓鱼页面。他们通过输入模拟知名品牌登录界面的描述,迅速生成视觉几乎无法区分真伪的钓鱼页面,用以获取用户的账号密码等敏感信息。

传统钓鱼攻击往往需要攻击者具备一定编程知识,需要手动设计网页和植入攻击代码,这不仅耗时耗力,也限制了攻击活动的规模。与之相比,Vercel v0这类开源工具免费且易用,即便是技术低水平的犯罪分子也能仅凭几个文字指令快速生成假冒网站,大幅提升了钓鱼攻击的速度和范围。更为严重的是,这些钓鱼页面往往被托管在Vercel的官方基础设施上,表面上依托一个可信赖的云服务,使得传统的反钓鱼监测和拦截机制难以生效。 研究人员还发现,攻击者不仅仅是生成假登录页,还将伪造的品牌Logo及相关资源上传至Vercel平台,进一步加强了欺骗效果。利用云平台的信誉,钓鱼链接可以绕过许多基于URL信誉度的过滤系统,给普通用户带来极大安全风险。发现相关问题后,Vercel迅速采取措施,封堵了所有涉嫌钓鱼的页面,防止了更大规模的攻击扩散。

除了Vercel v0,其他类似的开源生成式AI工具也被证实在网络犯罪中频繁出现。专家警告,这类工具极大刺激了钓鱼攻击的自动化和智能化,使犯罪分子能够不断优化诱骗手段,提高攻击成功率。大型安全厂商Cisco指出,攻击者正借助超大语言模型(LLM)如WhiteRabbitNeo来编写更具针对性的钓鱼邮件和攻击脚本。这些未受任何限制或过滤的LLM版本,正被黑市广泛交易,为各种网络攻击提供动力。 网络犯罪分子自研或商用的多款非法LLM工具如WormGPT、FraudGPT、GhostGPT等,号称能够帮助黑客编写恶意代码、生成隐形恶意软件、设计复杂的钓鱼邮件及网页。这类工具的普及极大提升了黑客的攻击能力和攻击场景复杂度,成为网络安全领域的新挑战。

针对此类威胁,用户首先应增强防范意识。访问任何登录页面时,都需确认域名和SSL证书的真实性,不随意通过邮件或未知渠道点击链接。企业则应提升安全防护能力,部署多因素认证(MFA)、行为异常检测以及可信执行环境,减少单一密码泄露带来的风险。 技术层面,安全社区需要加快研发针对AI生成内容的检测技术,例如结合机器学习的网页相似度分析、页面内容一致性验证以及托管平台的异常行为监控。同时,云服务提供商应加强对用户生成内容的审核,防止恶意资源上传和滥用其基础设施。 法律与政策方面,监管部门需关注人工智能工具在网络犯罪中的新用途,出台相应法规规范生成型AI软件的使用,并强化国际执法协作,阻止这类工具成为跨境网络犯罪的帮凶。

总的来说,Vercel v0事件揭示了生成式人工智能技术在现代网络攻击中的双面性。一方面,它使网页开发更加便捷高效,推动了数字经济发展;另一方面,其易用性和强大功能也为不法分子提供了新的攻击渠道。面对这样的新挑战,用户、企业与监管者必须协同努力,提升技术防御和法律规范水平,构筑更加安全可靠的网络环境。未来随着生成式AI技术的不断演进,如何把握其利弊平衡,将成为信息安全领域亟需解决的核心课题。