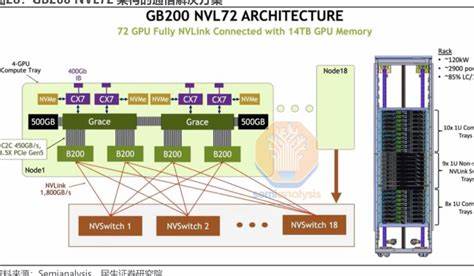

随着人工智能技术的高速发展,复杂模型的训练和推理性能成为衡量硬件平台竞争力的重要指标。GB200 NVL72作为目前最先进的AI训练与推理设备,其卓越的计算能力和内存带宽引起了业界的高度关注。本文聚焦于DeepSeek 671B模型在该平台上采用预填充-解码(PD)分离设计和大规模专家并行(EP)策略,展现了2.7倍的解码吞吐量提升,解析了背后的核心技术与优化思路,展望了未来人工智能系统的发展方向。深度学习模型在大规模部署时,常常面对计算瓶颈与通信开销的双重挑战。GB200 NVL72凭借其卓越的FP8精度优化矩阵乘法库Blackwell DeepGEMM,突破了传统计算限制。该库专为Blackwell架构设计,利用全新的矩阵乘法单元(UMMA)特性,实现了计算效率的显著提升。

更重要的是,GB200 NVL72配备的大容量内存使得KV缓存得以扩展,支持更大的批处理规模,进而促进模型推理过程中的矩阵运算效率,形成了硬件优势与算法优化的强强联合。在通信子系统方面,GB200 NVL72创新地采用了纯NVLink架构替代传统的远程直接内存访问(RDMA),最低限度地减少了跨节点通信延迟。Blackwell DeepEP通信库借助映射远程GPU内存到本地虚拟地址空间的设计,实现了令牌在Mixture of Experts(MoE)架构中专家间高效传递。相比H100平台,NVLink环境下通信与计算的协调更加紧密,极大地缩短了整体推理时间。这种高效的通信机制使得深度学习模型尤其是在涉及大规模专家并行策略时,能够充分发挥硬件性能潜力。大规模专家并行是深度模型扩展的关键技术之一。

传统模型拓展中,专家路由机制容易带来内存访问压力和通信开销。GB200 NVL72结合SGLang框架中的PD分离设计,灵活拆分预填充和解码阶段,提升资源利用效率。在此基础上,大规模EP技术优化了MoE专家之间的协同计算,缓解了内存带宽瓶颈,进而保证了任务负载的均匀分布和计算效率的最优化。这不仅提升了模型推理速度,还为未来更大规模专家网络的部署奠定了基础。深度学习核心运算之多头注意力机制(Multi-Head Attention, MHA)在模型预填充阶段占据了重要位置。GB200 NVL72针对FlashInfer框架,重写并优化了Fused Multi-Head Attention(FMHA)内核,从而适应Blackwell架构和FP8计算生态。

与此同时,Blackwell CUTLASS MLA内核的应用,使得针对键-值缓存的访问更为高效,减少了L2缓存访问次数,降低了延迟。这些底层内核优化协同作用,为DeepSeek模型解码和预填充阶段提供了强劲计算支撑。实验结果验证了上述设计优势。在使用14节点GB200 NVL72集群的设置中,分配12节点用于解码,2节点专门进行预填充,模拟了现实应用场景。测试显示,GB200 NVL72在2000-token输入长度下实现每GPU解码速率高达7583 tokens/秒,较H100平台提升了2.7倍以上。性能提升范围在2.5至3.4倍之间,取决于序列长度及批处理大小。

不同规模的批处理实验进一步证明,较大的批处理规模能够有效提升计算吞吐,同时即使在相同批大小下,GB200 NVL72的表现远超H100,突显平台在算力和内存带宽上的综合优势。批处理大小的影响在深度学习模型部署中尤为关键。GB200 NVL72因其大容量内存,支持更大的批量输入,促使模型解码内核饱和进而实现更高效率。尽管当前为初步版本,尚未针对小批量情况进行优化,但硬件本身在多场景适应性方面展现出巨大潜力。未来通过进一步的算法改进和调优,预计将覆盖更多应用场景,实现更灵活的部署策略。展望未来,研究团队计划在多个方向进行深入探索。

首先是对预填充阶段性能的提升,将通过优化内核融合和数据传输路径,降低整体延迟。其次,通信机制方面,将尝试更高级的计算与通信重叠技术,以最大限度挖掘并行潜力,进一步缩短推理总时长。另外,多标记预测(MTP)技术在小批量场景中将成为重点研究对象,提升模型在低延迟需求下的表现。硬件层面,GB200 NVL72丰富的指令级优化空间尚未完全开放,未来内核进一步饱和内存带宽和计算资源,将推动AI整体性能的持续飞跃。此次成果得益于NVIDIA硬件团队、SGLang核心开发组以及Mooncake团队的紧密协作。他们在Blackwell架构上展开全方位的内核优化,包括FP8矩阵乘法、专家通信调度、注意力机制融合等核心模块,为DeepSeek模型能够充分发挥GB200 NVL72的硬件优势提供了强有力的技术保障。

与此同时,持续的社区贡献和跨部门协作,确保了技术方案在实际环境中的稳定性与高效性。GB200 NVL72的出现不仅推动了当前深度学习模型的加速,也为下一代大规模AI系统构建提供了坚实基础。结合PD和大规模专家并行技术,DeepSeek的成功部署彰显了软硬件协同优化的巨大价值。这不仅提升了模型推理的效率,更为AI应用创新注入了强大动力。未来,随着硬件架构不断迭代升级、算法调优持续深入,AI推理性能有望实现新一轮质的飞跃,推动智慧计算更广泛的落地应用。整体而言,GB200 NVL72与DeepSeek结合的成功案例,表现出了显著的性能提升和优化空间。

通过优化矩阵乘法库Blackwell DeepGEMM、改进通信库Blackwell DeepEP、重写注意力机制内核FlashInfer Blackwell FMHA和CUTLASS MLA内核,再加上GPU间高效传输引擎Blackwell Mooncake,有效释放了硬件潜能,显著提升了解码吞吐量。未来进一步的工作将围绕减少延迟、拓展硬件适用范围及提高多样化任务支持能力展开,助力打造更强大、更高效的AI推理平台。