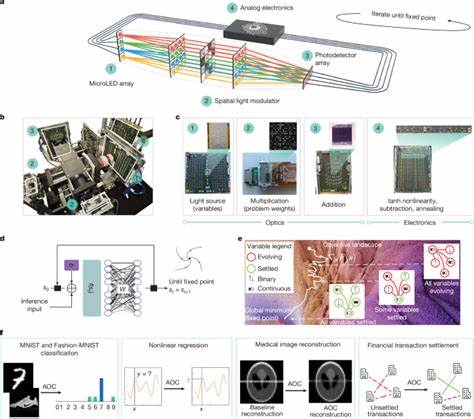

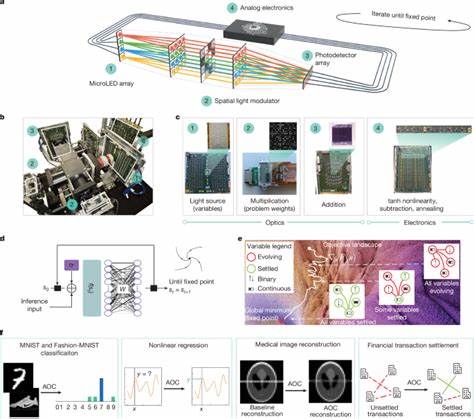

随着人工智能和复杂优化问题在各行各业的广泛应用,传统数字计算系统面临着日益增长的能耗瓶颈和性能限制。模拟光学计算机(Analog Optical Computer,简称AOC)作为一种非传统的计算平台,将模拟电子技术与三维光学相融合,在加速人工智能推理和组合优化方面展现出巨大潜力。它不仅打破了数字转换的频繁瓶颈,还提供了更好的噪声容忍能力,为未来绿色高效计算提供了令人期待的新方向。 模拟光学计算机的核心优势在于其基于固定点搜索的迭代计算方式,完全消除了数字到模拟及模拟到数字之间的转换开销。迭代过程中,计算状态以光强形式在微型LED阵列和空间光调制器间传递,完成矩阵向量乘法;再通过模拟电子器件完成非线性函数、加减运算和退火过程。每次迭代时间仅约20纳秒,兼顾了计算速度和能效表现。

相比现有的专用数字芯片,AOC预计可在8位精度下实现高达500万亿次每秒的运算速度及超过100倍的能效提升。 此外,AOC构建的固定点迭代框架不仅适用于神经网络推理,也能有效求解复杂的组合优化问题。对于人工智能推理任务,AOC优先支持基于深度平衡(deep equilibrium)模型的神经网络,这类网络能够自我递归,动态调整推理深度,提升推理质量与泛化能力。相比传统前馈神经网络,平衡模型更适合模拟硬件实现,且因其吸引态性质,天然具备对模拟噪声的强鲁棒性,为硬件部署带来实用优势。 在优化领域,AOC可高效处理混合二值与连续变量的二次无约束混合优化(QUMO)问题,这比传统的QUBO(二次无约束二进制优化)模型更具表达力,能涵盖现实中带有线性不等式约束的多样问题。通过引入松弛变量,复杂约束被整合进目标函数,AOC在无须数字化后端干预的情况下完成全模拟求解。

实际案例展示了AOC在医学图像重建和金融交易结算中的应用,取得了出色的结果。例如,采用AOC解决压缩感知图像重建,重建精度远超只优化数据保真项的传统方法,证明了该模型的有效性。同时,在金融证券交易批处理的结算优化中,AOC能够在数十步坐标下降算法迭代中迅速找到全局最优解。 硬件设计方面,AOC利用消费级光电子元件及成熟制造流程,结合三维光学系统实现光信号的高效扇入扇出。空间光调制器对应存储权重矩阵,而微型LED阵列承载当前状态光强,光子经过调制后被光电探测器转换为电信号,再由模拟电路执行非线性与退火操作。当前实验装置包含16×16状态变量,可通过时间复用扩大至4096个权重。

未来发展规划指向模块化架构,采用多模块并行处理,更高像素的空间光调制器以及集成模拟电子,以实现亿级乃至十亿级权重规模,满足实际AI和优化应用需求。 为了保证性能与实际效果,研究团队构建了精确的数字孪生模型(AOC-DT),该模型复刻硬件的非理想行为,校准结果显示数字模型与实体设备对应率超过99%。基于数字孪生,训练等耗时阶段仍在数字环境完成,获得的权重经量化映射到硬件,实现高保真硬件部署,降低设计难度及迭代周期。 经过系统性实验验证,AOC在MNIST和Fashion-MNIST数据集上的分类准确率优于相同参数规模的传统前馈模型。同时,AOC还可执行非线性回归任务,如高斯曲线和正弦函数拟合,展现出处理连续值问题的能力。值得注意的是,模拟设备存在一定噪声,为保证回归任务的精度,采用多次采样平均机制进一步降低误差。

在优化测试中,AOC硬件涵盖16个变量的综合测试,针对衍生自真实场景的多个问题取得95%以上的近似最优解,有效代替业界领先的数学规划解算器。更大规模的QUMO问题则通过数字孪生配合分块坐标下降方法分解求解,成功处理百千量级变量,显示良好的扩展潜力。 与目前流行的量子退火机、模拟电子交叉条阵列等非传统平台相比,AOC优势明显,一体式的全模拟架构与固定点搜索显著减少数字转换带来的性能与能耗负担,且在实际工业案例中取得更高的解质量及解算速度。其采用的微型LED非相干光源不要求极端光路相干性容忍度,极大增强了系统制造工艺的可行性和成本优势。 未来,模拟光学计算机有望成为人工智能与优化领域的硬件创新风向标。随着三维光学集成和模拟电子技术的持续进步,整体模块尺寸将不断缩小,系统可靠性和性能进一步提升。

模拟计算结合专门设计的推理和优化算法,共同推动多领域应用实现超越数字计算的深远影响。 与此同时,AOC的架构设计理念强调硬件与算法的协同进化,类似数字深度学习加速器与神经网络模型相互促进,形成算力与算法的良性循环。借助这一理念,未来研究能够开发更多通用化的模拟计算模型和更高效的固定点迭代算法,深化AOC的应用广度和深度。特别是对于需要迭代推理、大规模组合优化及实时决策的场景,AOC将发挥独特价值。 总之,模拟光学计算机突破传统数字计算架构限制,通过紧密结合光学和模拟电子技术,实现迭代推理与优化求解的高效融合。它代表了降低人工智能与优化算法电力消耗、缩短推理时间的创新路径,推动绿色智能计算的广阔前景。

随着相关技术逐步成熟,模拟光学计算机有望在医疗成像、金融科技、交通物流等领域实现实际部署,成为未来智能计算生态的重要组成部分。 。