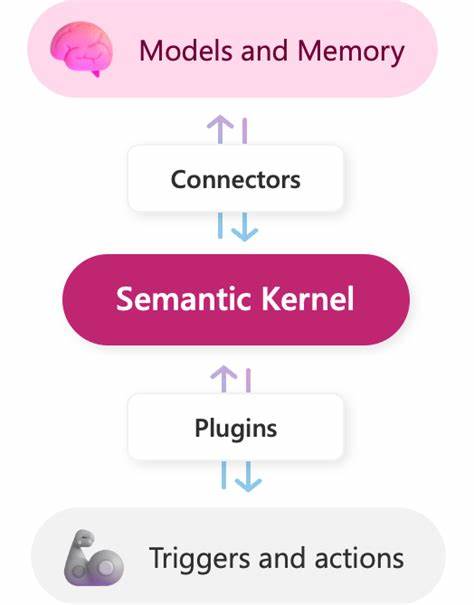

人工智能的飞速发展正在深刻改变软件开发的格局,尤其是在.NET生态系统中,AI技术正逐渐成为推动应用智能化的关键力量。Semantic Kernel作为微软开源的一款AI编排框架,为.NET开发者提供了连接大型语言模型(LLMs)和企业级服务的桥梁,使得开发者能够以熟悉的C#语言和设计模式,打造灵活且功能丰富的智能代理系统。近年来,传统软件的确定性规则已无法应对复杂多变的业务需求和用户体验挑战,利用如GPT-4等大型语言模型的自然语言处理和推理能力正成为主流趋势。Semantic Kernel通过提供一致而强大的编程接口,实现了LLMs与业务逻辑、API、记忆存储和自定义插件的无缝结合,从而突破了单纯调用LLM接口的局限,大幅提升了应用的智能交互能力和生产环境的稳定性。 Semantic Kernel的核心在于它的内核组件,这个内核作为整个AI应用的调度中心,管理并协调所有语义函数、原生代码插件以及连接器的生命周期。借助KernelBuilder,开发者可以轻松配置各种服务,例如接入OpenAI或Azure OpenAI模型、集成Azure认知搜索作为语义记忆、注册自定义功能插件。

此外,插件机制强调将原生C#代码和基于提示词的语义函数统一管理,使得开发者既能利用AI的自然语言理解优势,也能维护传统代码的确定性和高性能,实现混合编程模型。 提示词工程作为Semantic Kernel不可或缺的一环,它涉及设计高效且准确的提示模板,引导大型语言模型生成所需的输出。通过PromptTemplateFactory,开发者能够定义参数化模板,进而构建灵活且可重用的语义函数。这些提示可应用于文本翻译、摘要生成、问题回答等多种场景,且支持高级技巧如少样本学习和思维链推理,显著提升模型推理的精准度和连贯性。 记忆功能是赋予AI代理“上下文感知”的关键。Semantic Kernel支持多种记忆存储方式,从快速的临时内存到持久化的向量数据库(如Azure AI Search、Pinecone、Chroma等),实现对对话历史、用户偏好及知识库的状态管理。

记忆的引入不仅让模型能够保持会话连贯,还能支持检索增强生成(RAG)技术,通过动态检索相关文档为生成内容提供事实依据,提高答案的可靠性和实用性。 在构建实际AI代理时,利用规划器(Planners)将多功能插件以有序或智能的方式串联调用成为关键。Semantic Kernel内置多种规划器,支持线性顺序执行以及动态目标驱动的复杂流程,配合自动函数调用,能够实现自主推演和多步骤任务处理。借助这些高级特性,开发者可以设计出应对开放式问题、流程复杂多变的智能助手,显著提升企业支持、自动化客服及知识管理等系统的智能水平。 从架构设计角度看,Semantic Kernel倡导模块化和接口驱动开发,有效支持依赖注入和单元测试。开发者可以通过定义插件接口和模拟不同实现,实现高覆盖率的测试体系,确保AI逻辑的稳健性和可维护性。

同时,缓存策略和异步处理被推荐用于优化性能和降低调用成本,结合日志和度量体系,提升整体应用的运营可观测性。 集成层面,Semantic Kernel通过连接器机制支持与多种外部资源交互,包括LLM服务、语义记忆存储及企业内部数据库或API。Azure OpenAI的企业级安全和合规特性令构建生产环境应用更为安心,而对开源及本地模型的支持保障了架构的灵活性和未来演进能力。开发者甚至可以自定义连接器,满足特定业务系统的需求,极大提升了整体系统的扩展性和集成度。 以支持票务系统为例,Semantic Kernel能够自动分析工单的严重程度,分类归属部门,并联动历史数据检索相似案例,输出统一、结构化的处理方案。通过语义函数解读自然语言工单内容,结合原生插件执行业务逻辑,再由规划器协调整个流程,使得人工客服的工作效率和准确性大幅提升。

此外,与后端系统如票务API的无缝集成还保证了业务闭环的完整性。 未来,Semantic Kernel有望在多模态模型支持和自主代理实施方面持续进化。随着文本、图像、音频乃至代码的融合能力增强,AI代理将具备跨领域理解和操作的能力。微软社区和开源开发者的积极参与也推动项目快速迭代,丰富示例和文档资源,为开发者提供坚实保障。 总之,Semantic Kernel不仅为.NET开发者打开了通向智能化应用的大门,更通过其与现代软件工程模式深度融合,打造出一条从原型到生产的高效路径。掌握这一框架,意味着开发者能够站在人工智能技术的前沿,以熟悉且强大的工具链构建符合企业需求的可靠AI代理,助力数字化转型的成功落地。

。