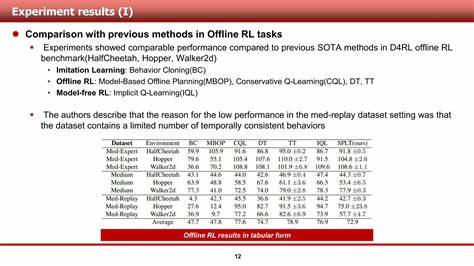

强化学习作为人工智能领域的核心技术之一,近年来在众多复杂环境中取得了卓越的进展。然而,即使是最先进的算法,有时也会因为代码中的一些意外漏洞而展现出意想不到的性能提升。本文讲述了一个有趣且富有启发性的故事:研究者在调试强化学习算法时意外发现的一个bug,反而催生了一种全新的优势估计方法,最终在Gymnax MinAtar Breakout环境中达到了当时的最优性能。 在强化学习中,PPO(Proximal Policy Optimization)是广泛应用且性能稳定的策略优化算法。研究者在对PPO进行实验,特别是在MinAtar Breakout环境中进行基线构建时,引入了批量归一化的优势计算,试图提升训练稳定性。然而,意外的一个bug导致了优势计算中的偏差,却反而让训练结果出现了显著提升。

起初这被视作代码问题,随后成为了一次机遇。 对该bug引发的性能跃升进行深入剖析,研究者聚焦于优势函数的计算逻辑,探究这种偏差的具体表现及其对训练策略的影响。通过系统化实验,发现该偏差事实上在优势估计中引入了一种协同的偏置,其本质上调节了价值函数对未来回报的预测,从而影响了智能体的探索行为。 强化学习中探索与利用的平衡至关重要。标准的entropy bonus(熵奖励)方法是鼓励智能体在不确定的状态下多尝试多样化动作,增加探索的力度。研究者最初假设bug引发的表现提升与熵增励机制类似,经过多次对比测试,发现引入的偏差确实让智能体在某些不确定状态下展示出更高的策略熵,增强了探索效果。

为了进一步验证这一假设,研究者采用了蒙特卡洛Dropout技术,对critic网络的预测方差进行估计,尝试衡量智能体在不同状态下的价值估计不确定性。意外的是,实验数据表明策略熵与critic不确定性之间并无显著相关性,这一发现迫使研究者重新审视原先的假设。探索更多可能的解释也成为了必然选择。 回到优势估计的本质,研究团队重新检视了底层的值函数估算机制。特点性地,批量归一化及其引入的偏差其实调整了优势估计的分布形态,使得当critic价值函数表现较悲观时,优势值被放大;当critic较乐观时,优势值被抑制。这种机制起到了某种类似于对critic预测偏差的正则化效果,帮助智能体更好地控制引导学习的价值估计。

基于此洞察,研究者设计了基于正则化思想的新型优势估计公式,该方法通过对时序差分误差中价值估计部分施加微小放大系数,引导训练过程自动调节critic的偏差。这一创新性的改动不依赖于传统的噪声注入或熵奖励而直接改善训练效果,经实验验证,该正则化优势估计在多种参数设置下均显著提升了智能体的平均回报水平。 为了进一步深化理解,研究团队还对熵奖励系数进行了细致的超参调优工作。发现尽管高熵奖励能够提升探索程度,但过高的熵系数往往引发训练稳定性问题,表现为回报极端波动。将熵奖金与新的优势正则化相结合,不仅稳定了训练过程,还将智能体的最终表现推向了一个新的高度,突破了原有的性能极限。 最终,团队综合了原先的bug机制、优势正则化以及熵奖励调优,确定了一个最优组合方案。

此方案在Gymnax MinAtar Breakout环境中实现了近百倍于原基线的回报提升,平均回报稳定在800分左右,而此前的公开基线仅在24分上下徘徊。如此巨大跨度的性能跃升,不但验证了新的优势估计技术的有效性,也强调了严谨实验和反复筛查的重要性。 从理论角度看,该研究揭示了强化学习中隐藏在表象之下的机制 - - 优势估计中的微妙偏差或正则化可以显著影响策略行为,进而塑造探索策略。通过系统地反思与测量,破解了一个"神秘黑盒",推动了强化学习方法向更稳定、更高效的方向演进。 此次成果启示我们,强化学习的优化不仅依靠设计全新算法架构,更在于细节处的精修与分析。代码中的偶然错误虽不宜被鼓励,但在科学试验背景下能促成创新的发现。

面对复杂模型,应保持开放的心态,勇于从异常数据和结果中挖掘潜在规律,而非盲目否定。 面向未来,研究者计划将这一优势正则化技术推广到其他强化学习环境,通过跨任务的实验来验证其普适性和鲁棒性。此外,如何结合更先进的模型不确定性估计方法,优化优势估计过程中的噪声调控,也是值得进一步考察的方向。希望这项技术能激发更多科研工作者重新审视现有算法,从而在强化学习领域为智能体训练带来更多突破。 总之,逆向工程一个Bug不仅成就了性能突破,更蕴含科学探索的精神。通过严谨的实验设计,丰富的假设检验和充满激情的技术探索,研究者成功诠释了从错误到创新的转变。

强化学习的旅途正因如此精彩,未来无限可能。 。