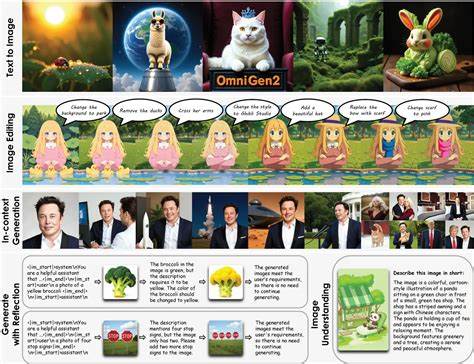

多模态生成技术作为人工智能领域的前沿方向,正在以惊人的速度推动图像与文本的融合创新。作为这一领域的重要突破,OmniGen2凭借其统一且高度灵活的架构,将视觉理解、文本生成、图像编辑与主题驱动生成巧妙融合,开启了多模态生成技术的新纪元。 OmniGen2的诞生标志着多模态大模型迈向更高效且精细的综合应用阶段。它巧妙地采用双路径架构,分别利用自回归Transformer处理文本生成,和基于扩散模型的图像生成解码器,确保了语言建模和视觉生成能力的高度独立又相互协作。通过这种设计,OmniGen2不仅能够实现高质量的文本描述驱动图像生成,还能支持复杂的视觉指令编辑,精确调整图像细节并保持整体视觉一致性。 在视觉理解方面,OmniGen2融合了视觉Transformer(ViT)编码器与多模态大型语言模型(MLLM),通过将视觉信息转化为语义表达,实现了对多样图像内容的深层解析。

不仅能够识别图像中的对象及场景,更具备跨模态的推理能力,强化了模型对自然语言与视觉内容的协调理解,显著提高了多模态交互的智能水平。 文本到图像的生成能力是OmniGen2的又一亮点。通过将语言模型隐藏状态与基于变分自编码器(VAE)提取的细腻视觉特征相结合,模型能够生成与复杂自然语言描述高度契合的图像。其在长文本提示的理解与组合性推理上有着优异表现,能够准确无误地将用户意图转化为丰富细腻的视觉效果,无论是幻想题材中的魔法黑巫师,还是细节逼真的森林狼,都展现出极具感染力和真实感的画面。 独特的指令式图像编辑功能为用户提供了以自然语言为指令,精准修改图像内容的强大工具。相比传统的图像编辑软件,OmniGen2能够理解复杂的文字指令,实现局部内容的微调和风格变化,确保未修改区域的完整性与视觉自然度。

无论是调整对象姿态,还是改变整体渲染效果,都能轻松达成,显示出模型在细节操控与视觉一致性之间的出色平衡。 此外,OmniGen2在主题驱动的镜像生成领域表现突出。利用专门设计的训练管线结合视频数据,模型能够从参考图像中提取主体信息,灵活地将该主题置入全新背景场景之中。这种能力不仅满足了个性化定制的需求,也为肆意创作与跨场景融合提供了坚实基础。其在保持主体一致性和语境融合方面均优于现有开源方案。 技术创新中尤为瞩目的是OmniGen2引入的多模态反思机制。

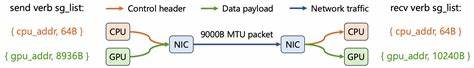

该机制使模型具备对自身输出进行评估和批判的能力,结合图文分析和自我纠正训练,通过多轮迭代不断优化生成质量。这样的反思能力赋予模型更强的可控性和可靠性,确保了最终输出不仅符合预期,更在表现力和细节上达到了新的高度,推动多模态生成向智能化、自适应方向迈进。 OmniGen2还特别创新设计了多模态旋转位置编码(Omni-RoPE),对图像中的位置和语义关系进行精细解构。通过分解位置编码为序列标识、二维空间高度与宽度三个部分,模型得以精准区分不同图像及其内部结构,极大提升了复杂任务如图像编辑与上下文生成的表现一致性和准确性。这一机制不仅提升了模型的空间感知能力,也拓展了多模态学习的边界。 多模态生成技术的飞速发展与OmniGen2的卓越表现,标志着人工智能在艺术创作、内容生产与跨媒体交互等领域迎来了全新的机遇。

随着模型不断优化及训练资源的丰富,未来OmniGen2及其后续发展有望广泛应用于游戏设计、影视特效、虚拟现实甚至教育等多元化场景,助力打造更加沉浸且个性化的数字体验。 不可忽视的是,OmniGen2作为开源项目,凭借其轻量级设计和高性能表现,为研究者和开发者提供了极具价值的平台资源。结合丰富的演示案例和公开权重,极大促进了多模态生成技术的传播和应用落地,有助于推动行业整体技术进步,实现智能生成技术的普惠与创新。 展望未来,随着技术的演变与应用需求的深化,OmniGen2的统一多模态生成框架将继续引领人工智能生成领域的发展潮流。其在理解与生成的双重能力,以及自主反思与迭代优化的内核设计,均为打造更智能、更可信、更多样化的生成模型提供了坚实基础。通过跨模态深度交互与创新训练架构,OmniGen2无疑成为推动智能内容创作走向新纪元的关键力量。

总之,OmniGen2不仅在多模态生成领域实现了技术突破,更展现出强大且灵活的应用潜力。它通过一体化设计兼顾了语言与视觉的生成与理解,强化了模型的推理与自我改进能力,为多模态人工智能的发展树立了新标杆。随着这一技术的不断完善与普及,未来数字内容的创造与交互方式必将被彻底革新,开启更加智能和创意丰富的新时代。