SQLite数据库因其轻量、易用及零配置的特点,广泛应用于各类项目和产品中,尤其是在需要嵌入式数据库的场景。随着项目的发展,SQLite数据库文件体积往往逐渐增大,尤其包含大量索引后,数据库文件大小呈现显著增长。在多台计算机间复制SQLite数据库时,如何保证数据的快速传输且避免数据损坏,成为许多开发者和数据分析师常遇到的挑战。传统直接复制数据库文件的方式,随着数据库文件体积增大,所花费的时间和资源开销呈指数增长,网络带宽和传输稳定性也逐渐成为瓶颈。针对这一现状,本文分享一种更高效、更稳定的复制SQLite数据库方法,重点在于利用SQLite自带的数据库转储功能,将数据库内容转换为SQL文本文件,再进行压缩、传输和重建数据库的过程。这个思路不仅能大幅缩减传输文件的体积,也能避免因文件复制过程中数据库更新导致的数据不一致问题,从根本上提升复制速度和完整性保障。

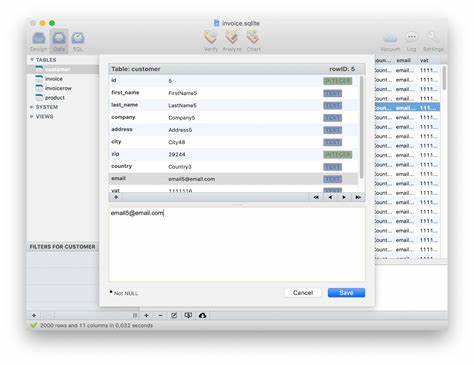

SQLite数据库复制的传统方法通常采用rsync或scp直接传输数据库文件,优点是简单快速,但面对大型数据库尤其带有复杂索引的情况,文件体积更大,复制过程更耗时。更为关键的是,若数据库文件在传输时被写入或更新,就容易产生部分数据在老状态、部分数据在新状态的混合,导致数据库文件损坏,出现“database disk image is malformed”之类错误,严重影响使用体验。为此,选择一个数据库操作过程中稳定且不可改变的复制节点显得尤为重要。 利用SQLite的.dump命令可以将整个数据库导出为一系列SQL语句文本,这个文本文件包括创建表结构、插入数据、创建索引等完整指令。数据库备份时,索引并不存储冗余数据,而是通过创建索引的SQL语句来进行描述,相较于实际索引数据文件,文本格式大小往往更小,尤其在压缩后,体积优势突出。用户可在远程服务器上执行 SQLite 数据库转储命令,生成一份纯文本的数据库内容文件,再对该文件进行gzip压缩,在本地计算机下载该压缩文件后解压并导入SQLite重新创建数据库,整个流程避免了原始数据库的直接传输风险和瓶颈。

这一方法具体执行步骤相对简单且逻辑清晰。首先,登录远程服务器,通过ssh执行sqlite3命令,调用.dump功能将数据库内容转储为SQL文本,并即时通过gzip完成压缩,将结果保存为.gz文件。随后利用rsync复制该.gz文件到本地电脑。完成传输后,删除远程服务器上生成的临时压缩文件,保证服务器环境干净无冗余。回到本地,解压该.gz文件,随后使用sqlite3命令读取SQL文本,再创建一个新的SQLite数据库文件,准确还原全部数据和索引结构。最后,将临时文本文件清理,完成整个数据库复制流程。

在传输过程来自数据稳定性方面,不同于直接复制文件,转储的方式保证传输的整个数据快照在转储生成时是静止且一致的,因此不会遇到文件更新带来的破损问题。同时,文本文件的重复性和规则性使得其非常适合压缩处理,通常压缩后的体积可达到原始数据库文件的十分之一甚至更小,有效缩短下载时间和带宽占用,尤其适合网络条件受限的场景。大量索引带来的额外数据冗余也被剔除,只保留创建索引的SQL指令,避免了无效数据的重复传输。 这一方法还具备高度可扩展性,无论SQLite数据库大小是几百兆还是几个GB,思路一致且可靠。对于需要频繁备份、迁移或分析远程数据库的用户极具吸引力,既简化了操作流程,又极大提升传输效率。实践中,基于这一方法,多位使用者报告单个3.4GB数据库压缩转储后仅需数百兆空间,更重要的是传输过程稳定无错,成功率远高于传统直接传输数据库文件方式。

此外,针对实际使用过程中,用户可以结合自动化脚本,将上述操作编排成批处理流程,实现定时备份和自动传输,进一步提升工作效率。例如利用bash脚本自动ssh登录远程服务器执行转储压缩、自动rsync同步文件、解压导入本地数据库,最后清理无用文件,整个过程无需人工干预,适合生产环境下大规模数据库管理需求。 总而言之,在处理大型SQLite数据库跨计算机复制及备份时,依托SQLite dump导出为文本文件加gzip压缩的创新思路,不仅能大幅提升数据传输速度和稳定性,还能避免因数据更新带来的错误风险。结合简便的ssh和rsync工具链实现,操作高效且实用,尤其适合网络带宽有限或数据库体量庞大的应用场景。随着SQLite数据库在各类新兴应用中的广泛使用,这种方法为数据库管理人员和开发者提供了切实可行的高效解决方案。期待未来更多工具和方案基于此思路进一步优化数据传输体验,助力数据工作的便捷与安全。

。