随着云计算和分布式数据库技术的迅猛发展,gRPC逐渐成为构建高效微服务通信的主流解决方案。它基于HTTP/2协议,支持多路复用和流控,理论上能够有效提升网络利用率和请求并发处理能力。特别是在低延迟、高带宽的网络环境中,gRPC被普遍认为是构建实时交互系统的理想选择。然而,近期来自YDB团队的研究和基准测试揭示,在实际应用过程中,gRPC客户端可能成为系统性能瓶颈,导致吞吐量无法线性提升,且延迟随并发数增加而显著上升。这一发现为业界敲响警钟,促使架构师和开发者重新审视gRPC客户端的设计和调优策略。本文将结合YDB在真实环境中的调研结果,深入解析低延迟网络下gRPC客户端瓶颈的本质、定位过程以及行之有效的解决方案。

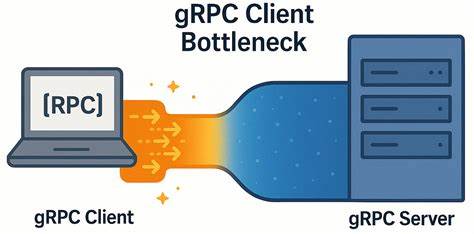

首先,理解gRPC的核心通信模型有助于洞悉瓶颈产生的根源。gRPC客户端通常通过多个频道(Channels)与服务器建立连接,每个频道内部复用HTTP/2的多路复用特性,允许大量并发RPC请求共享单一TCP连接。然而,HTTP/2协议对并发流的数量存在默认限制,通常为100个并发流。这意味着当客户端超过该并发流数时,后续RPC请求将被排队等待,形成请求拥塞。此外,在同一TCP连接上,多路复用机制带来的内部调度开销以及同步线程竞争也可能导致客户端处理延迟增加。YDB团队通过构建简洁的gRPC Ping基准测试应用,模拟高并发RPC调用,深入剖析了客户端行为。

在保证网络质量极佳、丢包率接近零且延迟极低的物理环境中,对比不同通道配置和并发请求数量下的性能表现,结果令人惊讶。即使并发请求数远低于默认流数量限制,客户端依旧显示出线性增长的延迟和低于理想线性扩展的吞吐率。这表明,瓶颈并非网络或服务器端性能限制,而是集中出现在客户端gRPC库内部的调度和连接管理机制。通过抓包分析和tcpdump定位,发现所有RPC请求均通过单一TCP连接发送,多线程客户端因共享连接产生锁竞争和请求排队,导致请求发送和响应处理之间存在约150至200微秒的空闲延迟。此现象在低延迟网络环境下尤为明显,因为网络层面未出现任何拥堵和丢包,瓶颈完全源自客户端自身管理策略。为缓解这一问题,YDB团队尝试了多种渠道策略。

传统推荐的做法是为应用中高负载区域创建独立的gRPC频道,或者维护频道池以分散请求压力。但最初的尝试发现,多个共享参数的频道依然共享同一TCP连接,瓶颈未能彻底解决。通过修改频道构造参数以确保每个频道独立维护TCP连接,或者设置GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,最终实现为每个RPC工作线程分配独立频道,彻底减少多线程间的锁竞争和请求排队。实际测试显示,在这种优化后,吞吐量提升近6倍,延迟增长速度显著放缓,客户端整体负载处理能力大幅提升。这种方法充分利用了底层TCP连接的并行能力,将多路复用限制的影响降到最低,极大提升了gRPC在极低延迟网络环境下的表现。值得注意的是,在高延迟网络(如5毫秒RTT)中,单连接瓶颈效应不明显,理论线性扩展与实际表现差距较小。

这说明该客户端瓶颈现象主要针对专用数据中心或超高速局域网环境,普通公网环境下的影响相对有限。结合YDB团队的研究经验,开发者在设计分布式系统时应更加关注gRPC客户端连接管理策略,避免单连接多线程竞争带来的隐藏性能损失。首先,应避免让多个高并发请求共享单一gRPC频道实现,尤其是在低延迟、高带宽的局域网络环境中。建议构造独立频道,每个频道绑定唯一参数,确保其拥有专属TCP连接,从而提升并行处理能力。同时,灵活配置GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,根据实际负载状况启用或关闭局部子频道池,进一步优化连接复用和负载均衡机制。此外,在客户端部署时,结合CPU亲和性绑定和NUMA架构优化,提升线程调度效率,降低不必要的上下文切换和缓存抖动,也能对延迟表现产生积极影响。

虽然当前优化已显著提升性能,但随着更复杂的场景和更高的负载涌现,可能还存在其他潜在瓶颈,有待社区进一步探索和完善。例如,细粒度的RPC调度、请求批处理策略、内存分配优化及事件驱动架构改进,均是未来研究方向。总之,gRPC作为现代分布式系统通信中不可或缺的工具,其性能表现直接影响整体系统响应速度与吞吐能力。在低延迟网络中,客户端瓶颈往往容易被忽视,却是性能提升的关键切入点。通过合理构建多通道体系和优化参数配置,不仅能显著缓解单连接并发限制,还能实现客户端资源的最大化利用,最终带来系统整体稳定性和效率的提升。希望本文的深入分析和实证数据能够帮助更多开发者理解gRPC性能细节,提升系统架构的设计水准和运行效率。

未来,随着gRPC框架的不断演进和社区的积极参与,相信相关瓶颈问题会逐步得到完善的解决方案,为分布式应用带来更加卓越的性能保障。