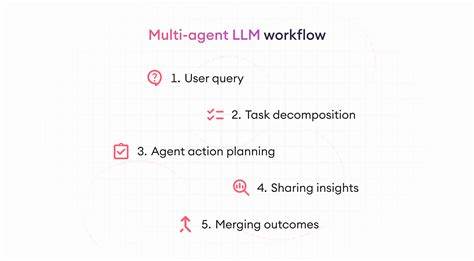

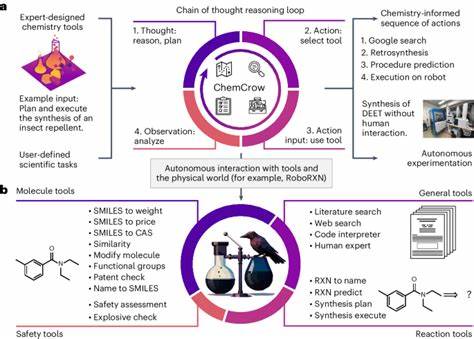

随着人工智能技术的迅猛发展,大型语言模型(LLM)已经成为模拟人类语言交流和社会行为的重要工具。这些模型不仅广泛应用于自动回复、内容生成和语言翻译等领域,还被用来模拟复杂的社会互动场景。然而,在人工智能系统日益深入人们日常生活和公共决策的背景下,探讨这些模型可能存在的政治偏见及其在辩论中的表现,显得尤为重要。 近期的一项研究通过结构化多智能体辩论框架,揭示了不同类型的大型语言模型和代理人物属性如何影响政治偏见和态度的变化。这项研究聚焦于美国的政治语境,设计了中立、共和党和民主党三种不同政治立场的LLM代理,在多个政治敏感话题上展开辩论。研究者通过有系统地调整模型来源、代理性别以及辩论格式,深入考察了这些因素对政治倾向和交互模式的影响。

研究结果显示,即使在被设定为“中立”的代理中,表现出的政治倾向也倾向于与民主党立场保持一致。共和党代理则似乎更容易向中立方靠拢,显示了政治立场之间的互动复杂性和不对称性。这一发现提示我们,大型语言模型的“中立”标签可能隐含着潜在的政治偏向,尤其是在模型训练数据和设计方法中,这种偏见在无形中得以放大。 性别因素同样在模型的政治态度和交流风格中发挥着重要作用。研究揭示,代理在知晓其他辩论者性别信息时,会根据性别调整自己的意见和表达方式。这暗示了人类社会中性别互动的细微差异和偏见同样被模型捕捉和再现。

换言之,LLM不仅反映了政治观点差异,还映射了社会性别角色和期待的复杂交织。 与此前研究中认为政治观点相同的智能体不会产生回声室效应不同,本项研究发现具有相同政治倾向的代理在辩论过程中确实形成了回声室现象,态度随着辩论持续而不断强化。这不仅符合人类社交中的群体极化效应,也提醒我们在设计AI辅助的辩论和决策工具时,要警惕类似信息闭塞和认知偏见的风险,避免加剧社会分裂和极端化趋势。 结构化多智能体辩论框架为深入理解大型语言模型中的政治偏见提供了新的视角和方法论。通过让不同政治立场和性别的代理在严格设计的辩论环境中互动,研究者能够更系统地捕捉和量化模型偏差。这种方法不仅有助于揭示现有模型的弱点,也为未来设计更公平、透明和可控的人工智能系统奠定了基础。

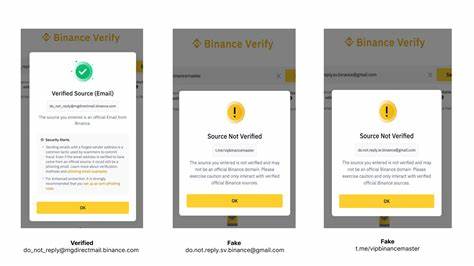

值得注意的是,模型的“溯源”或开发背景在政治偏见形成中起着关键作用。具体来说,不同来源的语言模型表现出不同程度的政治倾向,反映了它们训练数据集的结构及价值导向。未来,构建多元化且代表性强的训练语料库,结合后续的偏见检测和校正机制,依然是缓解模型政治偏见的根本途径。 从社会层面来看,随着大型语言模型成为公众讨论、新闻报道和政策制定的重要辅助工具,其政治偏见问题影响深远。公众和开发者需要提高警惕,杜绝模型因偏见而加剧分歧、误导信息传播甚至操纵民意的可能。政策制定者也应考虑制定相应的监管标准,确保人工智能的公平性和透明度。

综上所述,通过结构化多智能体辩论的方式,研究初步揭示了大型语言模型在政治领域的多维偏见表现,包括中立标签的偏向性、性别因素的影响以及回声室效应的存在。这一研究不仅深化了我们对人工智能政治态度形成机制的理解,也指明了未来改进方向。随着技术进步和应用场景的不断拓展,推动对AI公平性和社会责任的持续关注,将有助于打造更具包容性与公正性的智能交互环境。