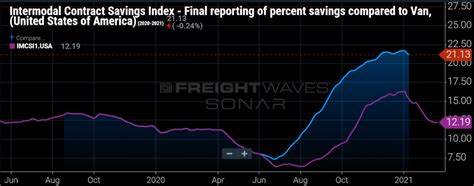

随着人工智能技术的不断发展,大语言模型(LLM)在个人助理领域的应用愈发广泛。然而,如何在有限的资源条件下实现高效、准确且隐私安全的智能交互,成为业界关注的重点。近日,研究团队针对两种主流增强策略——即检索增强生成(Retrieval-Augmented Generation,RAG)和假设文档嵌入(Hypothetical Document Embeddings,HyDE),结合1亿与4亿参数规模的Gemma LLM进行了深入评估,以期揭示不同规模模型与增强方法在个人助理中的实际表现。研究结果不仅对技术选型具有指导意义,也为边缘计算和隐私敏感场景下的智能助手开发提供了有益借鉴。RAG作为一种将外部知识检索集成进生成过程的技术,能够有效提升模型对特定领域或用户相关信息的访问能力。实验中,无论是1B还是4B参数的Gemma模型,RAG均表现出显著的延迟降低,最高可比传统方法快17%。

这一优势在用户交互中尤为宝贵,因为响应时间的缩短直接提升了用户体验。此外,RAG的事实准确性表现优异,有效避免了生成内容中的“幻觉”现象,特别是在涉及个人数据和专业领域知识时,能确保回答的可靠性和安全性。相比之下,HyDE通过构造假设文档并生成对应嵌入,增强了模型对语义相关性的理解和捕捉。该技术在处理复杂物理类问题时展现出较高的语义匹配度,用户可以获得更具深度和细致的回答。然而,这一方法伴随着复杂计算过程,导致响应时间增加25%到40%。这在对时效性要求较高的个人助理应用中,可能成为制约因素。

更值得注意的是,HyDE在涉及个人数据检索时,产生了一定比例的事实幻觉,提示该技术在隐私和安全方面尚需进一步优化。模型规模的扩展从1B涨至4B参数,对两种增强策略的影响各异。对基线模型和RAG管线而言,参数增加带来的是有限的吞吐量提升,进一步证明了轻量化模型在实际部署中的良好适应性和资源节约优势。但当信赖HyDE进行推理时,4B模型所需的计算资源和延迟负担显著加重,表现出较高的时间波动性,增加了系统整体的不确定性与维护难度。从实际场景出发,个人助理系统构建不仅追求智能对话的精准性,也极为重视响应速度和用户隐私保护。该研究基于MongoDB实现短期记忆存储,结合Qdrant作为长期语义存储,为模型提供动态且分层的信息支持,辅助其形成上下文持续感。

通过FastAPI与LangChain框架整合模型和检索机制,系统更易于跨平台部署和扩展。此外,开放的HTTP前端接口确保了良好的用户交互体验和便捷的访问路径。综合评估显示,RAG策略在当前硬件限制和隐私需求条件下,因其稳定的低延迟和事实准确率,成为1B和4B参数Gemma LLM驱动的个人助理的最佳选择,尤其适合边缘设备或资源受限场景。HyDE虽然在语义表现上具备潜在优势,但在响应时效与可靠性方面的不足,提示其更适合于不追求极致实时性的复杂学术或研究型应用。未来,针对HyDE的优化方向可能包括引入更先进的纠错机制和更高效的嵌入计算方法,以缓解延迟瓶颈和减少幻觉生成。此外,结合隐私增强技术如联邦学习和差分隐私,能够促使这两种方法在个人助理领域达到更高的安全性和性能平衡。

在实际部署角度,开发者和企业应根据自身产品的定位与用户需求,权衡模型规模与增强策略带来的利弊。小型LLM结合RAG不仅节省计算资源,且能保障用户数据安全,是当前市场中极具竞争力的解决方案。而对于需要处理专业复杂问题,且对时延容忍度较高的应用场景,选用更大规模模型配合HyDE或许能实现更优的用户价值。综上所述,评估RAG和HyDE在不同规模Gemma LLM上的表现,为推动个人助理智能化和普及化提供了宝贵的数据支持和实践经验。开发者通过合理设计系统架构和策略选择,能够构建出更加高效、可信赖且符合用户隐私期待的智能助理系统,开创智能交互新时代。随着技术的不断迭代升级,未来个人助理在多样化场景的表现值得期待,融合知识检索与语义理解的先进技术必将成为关键驱动力,助力人机交互迈向更高水平。

。