随着人工智能(AI)技术在各行业的广泛应用,企业内部对人工智能的利用已成为提升效率和创新力的重要驱动力。然而,许多企业发现,尽管他们投入资源采购了企业级大型语言模型(LLM)订阅服务,实际应用中的AI使用远远超出了官方授权工具。大量员工在日常工作中使用未经企业批准的AI工具,这种现象被称为"影子AI"。影子AI不仅影响企业信息的安全与合规,也给企业治理带来重大挑战,因此,影子AI的发现成为现代企业AI治理的关键环节。 根据麻省理工学院发布的《商业中的AI现状》报告,尽管只有约40%的企业订阅了企业级AI服务,但超过90%的员工在工作中主动使用各种AI工具。 调查显示,接近半数的敏感AI交互来自员工的个人邮箱,完全绕过了企业的安全管控。

这种现象形成了"影子AI经济",让安全和治理团队面临前所未有的风险和管理困境。 企业对AI的认知通常存在误区,普遍认为AI的使用应由企业高层推动和规范,但现实情况是,员工是AI使用的真正推动力,往往是自下而上采用工具以提升工作效率。 即使企业为员工配备了官方的AI工具,员工仍倾向于寻找更新、更高效的工具,这些工具往往不受企业监控。安全领导者若无法洞察和管控这些行为,企业就暴露在数据泄露、合规风险甚至业务中断的威胁之下。 对影子AI的应对,许多企业尝试了"阻断策略",通过限制访问主流AI平台来减缓其扩散。然而,AI功能早已深度嵌入各类生产力和协作软件中,仅靠阻断单一平台无法有效遏制AI的使用。

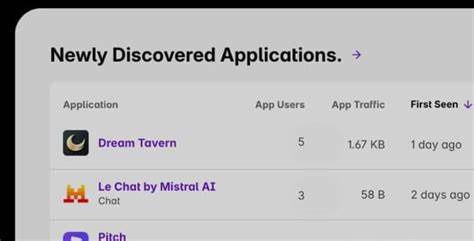

员工可能转而通过个人设备和个人账号使用其他AI工具,企业治理盲区因此越来越大。 面对影子AI的扩散,前瞻性的安全与AI治理团队采取积极发现和监控的策略。通过深入了解员工实际使用的AI工具及其具体应用场景,企业能够识别潜在风险,制定更加科学和灵活的治理政策。 影子AI的发现不仅是治理需求,更是一项监管义务。以欧盟《AI法案》为例,明确要求企业必须维护对所使用AI系统的透明度和可追踪性。没有发现,便无所谓清单;没有清单,则无从谈起有效治理。

不同的AI工具对应不同的风险,有些默默对专有数据进行模型训练,有些将敏感信息存储于监管环境不同的境外服务器,带来知识产权及合规风险。唯有全面揭示企业范围内包括个人账户在内的AI使用情况,才能科学划分风险等级。 企业获得全景视图后,能够明确哪些AI使用属于低风险场景,哪些涉及敏感数据或必须遵循特定法规的业务流程。这样的分类与分级使得治理措施既保障数据安全,也不妨碍员工高效利用AI工具提升生产力。 专门提供影子AI发现和治理方案的安全企业,正通过持续监控和风险评估机制,帮助企业实现这一目标。 他们提供的解决方案不仅仅是静态的黑名单过滤,而是基于工具风险等级、数据敏感度、员工角色等维度实施动态策略。

例如,市场营销部门可以在规定范围内自由使用AI工具进行内容创作,而人力资源或法务部门则被限制不得使用个人账户处理敏感员工信息。 这些策略的核心依托于智能模型对员工输入数据的实时分类和判断,确保企业AI政策得到精准执行,同时最大化员工的工作协同效能。 影子AI的存在是无法回避的现实。随着更多SaaS应用集成AI功能,未管理的AI使用只会越积越多。企业若今日不积极发现与治理,明日将难以控制风险,监管处罚和数据泄露事件频发将对企业造成不可估量的损失。 未来的企业AI治理,应从"阻断神话"转向"智能透明治理",通过影子AI发现实现对全企业AI资产的可视化掌控。

首席信息安全官(CISO)因此能够更好地保护企业核心数据,满足日益严格的法律法规,并给予员工安全放心地使用AI带来的生产力提升。 总体来看,影子AI发现是企业在AI治理道路上的基石。通过科学手段揭露隐藏的AI使用,企业不仅能够防范潜在风险,也能完成合规要求,最终实现人工智能与业务发展相辅相成的美好愿景。 借助领先企业提供的智能监测、风险评估和动态治理方案,企业正迈出关键一步,迎接智能时代的挑战和机遇。随着AI不断深入我们的工作生活,影子AI的管理将成为企业数字安全蓝图中不可或缺的一环。 。