近年来,人工智能领域尤其是大型语言模型(LLMs)的蓬勃发展,给科研和工业界带来了前所未有的计算挑战。训练数十亿甚至百亿参数规模的模型,需要极其庞大且复杂的计算资源支持。传统的同质硬件集群虽具有一定优势,但在面对海量数据处理和多样化计算需求时,显得效率有限和扩展性受限。混合芯片集群应运而生,通过汇聚来自不同厂商和架构的多样化硬件资源,极大提升了AI模型训练的灵活性与效率,成为大规模人工智能训练的新动力。混合芯片集群,顾名思义,是将多种类型的计算芯片融合部署于同一大型集群中,这些芯片在硬件架构、算力性能、内存和通信协议等方面存在差异。其核心优势在于实现资源的最优匹配,针对不同模型组件和计算任务灵活分配最合适的硬件平台,从而最大化算力利用率和能源效率。

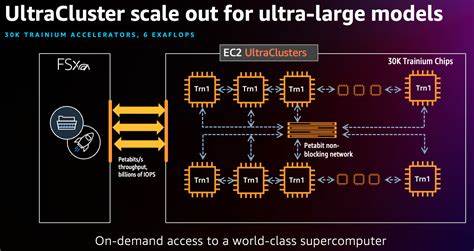

然而,此类集群的多样性也带来了巨大的系统集成和协调难题。不同芯片之间的底层软件栈、算子实现、通信库以至硬件能力存在天壤之别,传统单一设备优化的分布式训练架构难以满足跨设备的高效协同。最近由清华大学团队提出的“H2”框架提供了创新性解决思路。H2代表超异构(Hyper-Heterogeneous)系统,它致力于在拥有超过一千块异构芯片的超大规模集群上,高效完成大语言模型训练任务。H2框架的核心构件包括DiTorch和DiComm。DiTorch是一个兼容PyTorch的统一接口,极大简化了不同设备间的程序一致性问题。

无论是CPU、GPU,还是专业加速卡,通过DiTorch都能实现无缝编程体验。DiComm是针对异构设备优化的远程直接内存访问(RDMA)通信库,解决了不同硬件平台间高效数据传输的瓶颈,显著降低了网络通信延迟。为了进一步提升训练效率,H2引入了HeteroPP和HeteroAuto两项机制。HeteroPP是异构流水线并行策略,它依据不同芯片计算能力和内存容量动态调整模型切分与任务调度。HeteroAuto则自动平衡计算负载、内存限制及通信开销,保障整体训练过程的平稳与高效。实验证明,H2在一款拥有百亿参数规模的语言模型训练任务中,可实现超线性加速,训练效率较传统同质集群提升超过16%。

这不仅表明极大规模异构集群训练在技术上具备可行性,也展现出显著的性能和成本优势。混合芯片集群的兴起,反映了人工智能训练资源架构的深刻变革。随着硬件种类与性能持续多样化,单一硬件解决方案难以跟上AI模型不断增长的规模和复杂度。混合集群透过资源异构整合,优化计算、内存和通信效率,切实为超大规模模型提供强劲支撑。不仅如此,此类集群还为硬件生态带来裂变式创新,促进了各芯片厂商间的协同共赢,推动行业整体进步。当然,混合芯片集群的全面推广仍面临多重挑战。

底层异构架构的复杂性要求更加智能化的软件定义能力,包括跨设备调度、负载均衡及容错机制的突破。硬件厂商与开源社区需要深化合作,共同打造标准化接口和统一的调试工具链。此外,大规模异构集群的能耗管理和散热设计也是亟需攻克的关键问题。未来,随着人工智能场景的不断丰富,混合芯片集群将助推模型训练从弱规模并行向极致并行转型。基于智能调度算法与机器学习辅助的资源管理,将进一步释放异构环境下计算潜力。多模态模型、强化学习及自监督训练的兴起,也迫切需要具备更强适应性的混合硬件支持。

同时,云端与边缘端的计算协同日益紧密,异构集群的架构设计需兼顾多维度节点,满足更广泛的应用场景。总的来说,混合芯片集群既是实现高效大规模AI训练的当代必然选择,也为推动人工智能技术突破提供了坚实基础。基于诸如H2这样的创新框架,不断优化计算资源利用策略和通信方案,将在提升训练速度、降低成本及节能环保方面取得显著成效。未来,随着硬件生态和算法技术的深度融合,混合芯片集群必将在全球人工智能竞赛中占据重要战略地位,推动智能时代迈向更高峰。