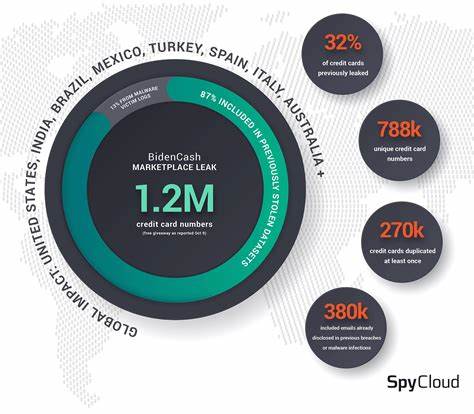

在数字化时代,网站流量的激增不仅来源于真实用户的访问,也来自各种自动化机器人程序。这些机器人流量虽然在某些场景下具有重要的功能价值,例如搜索引擎爬虫和数据采集工具,但大量恶意或无序的机器人请求往往成为网站性能瓶颈,严重影响用户体验和系统的稳定性。应对机器人引发的性能问题,已成为网站运营和技术团队必须重点关注的课题。要有效解决这一问题,首先需要深入理解机器人流量的特点和其对网站系统造成的具体影响。机器人请求一般表现为高频率的访问行为,往往短时间内产生海量请求,极易导致服务器资源紧张,响应速度下降,甚至引发服务崩溃。此外,恶意机器人还可能进行恶意攻击,如数据抓取、刷流量、恶意登录尝试等,进一步加剧系统负担和安全风险。

针对以上挑战,识别机器人流量是解决问题的第一步。目前常用的识别手段包括分析访问日志中的行为模式、访问频率、请求头信息等,结合机器学习算法提升识别准确性。一些高级系统使用CAPTCHA验证、JavaScript挑战或基于行为分析的检测机制来区分真人用户与机器人。识别之后,针对不同类型的机器人,可以采取多层次的应对策略。对合法且必要的机器人访问,需要合理制定访问频率限制,确保其不会对系统造成明显负载。而对恶意机器人,应采取更加严格的封禁和限制措施,如IP黑名单、请求限流、验证码验证等,防止其进一步侵害网站资源。

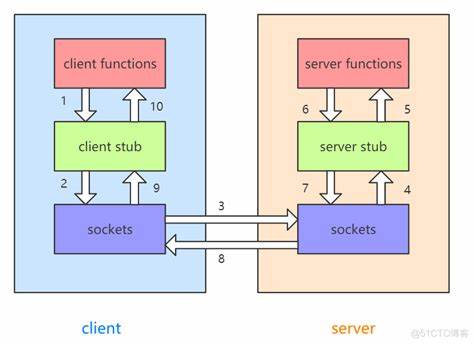

在技术架构层面,优化系统的负载均衡和资源分配也是关键。例如通过引入反向代理服务器、内容分发网络(CDN)等技术,分散和缓解服务器压力。同时,利用缓存机制减少重复请求对数据库的访问,降低系统响应时间。对API接口特别敏感的部分,可以设计专门的访问控制和鉴权策略,保证只有合法用户和机器人具备访问权限。此外,令牌桶算法、漏桶算法等限流策略被广泛应用于流量控制,能够有效地限制单位时间内的请求数量,避免突发流量冲击系统。运用分布式追踪和日志分析工具,实时监控机器人流量的变化趋势和系统性能指标,也是确保问题及时发现和快速响应的重要手段。

除了技术层面的应对,提升用户体验同样重要。当系统因机器人负载高企而不得不对请求进行暂时限制时,应通过友好的交互界面告知用户当前状态,如展示等待进度、说明原因等,缓解用户焦虑,维护品牌形象。结合用户行为数据进一步细分不同用户群体和访问需求,实施差异化的流量管理策略,也能更精准地保障关键用户的访问优先权。随着人工智能和自动化技术的进步,机器人行为也变得越来越复杂和智能,传统的静态规则和简单识别手段显得力不从心。未来网站安全和性能维护需要更多依赖动态自适应的防护机制,以及基于大数据和实时分析的智能决策系统,实现对异常行为的即时拦截和调整。总而言之,应对机器人流量带来的性能问题是一项系统工程,需要从识别、管理、技术架构优化和用户体验维护等多方面入手,建立完善的防御和调控机制。

只有这样,网站才能在面对日益复杂的网络环境时,保障自身的稳定运行和用户的优质访问体验,为业务的持续发展奠定坚实基础。