人工智能技术的飞速进步正在深刻改变计算环境,尤其是数据中心的基础设施建设。高性能机器学习模型的训练和推理,需要庞大的计算资源和电力支持,同时也带来了散热等方面的严峻挑战。传统的数据中心设计难以满足未来AI时代对高密度算力和能效的双重需求。为了应对这一趋势,业界正在积极探索并部署新型电力分配方案和先进的液冷技术,力图为AI硬件提供稳定、高效和可持续的运行环境。 电力分配是数据中心设计中的核心环节。随着AI硬件功耗的迅猛增长,单个机柜的功率需求持续攀升,预计在2030年,单机柜功率将超过50万瓦,甚至达到百万瓦量级。

传统的低压直流供电方案难以满足如此庞大的功率输送需求,还会带来严重的能源损失和设备散热压力。为了突破这一瓶颈,行业正推进从48伏直流供电向更高电压水平的转变。近期,谷歌联合Meta和微软在开放计算项目(OCP)框架下,推动采用±400伏直流电,支持单个IT机柜高达一百万瓦的电力供应。这一创新不仅提升了供电效率,减少输电过程的能耗损失,还利用了电动汽车领域成熟的供应链体系,带来了更高的制造效率和成本优势。 采用±400伏直流电的电力分配架构还引入了“交流转直流边车机架”设计,将电源转换设备从计算机机柜中拆分出来,实现电力组件与算力组件的解耦。这种方式提高了整体电力转换的效率,约提升3%,并释放了宝贵的机柜空间,使更多计算单元得以密集排列,提升了计算密度和资源利用率。

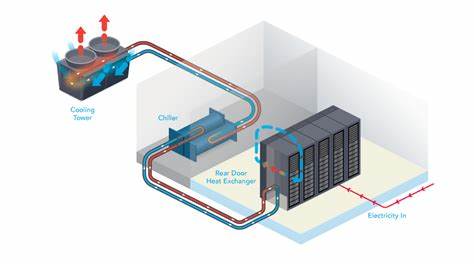

长远来看,业界还在探索更高电压直流电的直接分配方案,期望进一步提升电力传输效率,满足AI算力不断攀升的需求。 随着计算功耗的不断增加,热管理已成为数据中心设计中不可忽视的问题。AI芯片的单芯片功耗由最初的百瓦级迅速增长到千瓦级,散热难度成倍增加。传统的空气冷却方式受制于其传热效率和热容容量,难以应对新型高密度计算设备释放的热量。液冷技术因此成为行业公认的最佳解决方案。水冷相较空气冷却具备更高的热导率和热容,单位体积内传输的热量大约是空气的四千倍,能够有效降低芯片及设备温度,保障系统性能稳定运行。

谷歌在过去七年间,已在全球范围内部署了数千个液冷TPU集群,累计达到千兆瓦级别的液冷算力。自2018年TPU v3采用液冷技术开始,谷歌持续优化冷却设计,系统可靠性常年保持在99.999%的高可用水平。液冷系统通过替代笨重的散热片,以紧凑的冷板直接贴合芯片,有效节省了机柜内部空间,提升了计算密度。与上一代空冷方案相比,液冷服务器的空间利用率提升了一倍,计算性能则提升了四倍。 谷歌液冷解决方案的核心在于冷却分配单元(CDU),即每行机柜内的冷却配给装置。CDU采用冗余设计,并配备不间断电源,保证冷却系统的持续运作,降低因冷却故障引发的宕机风险。

CDU将机柜内部的液循环与机房给冷系统分离,以流量控制、热交换和压力管理为核心,实现冷却效率最大化。最新一代的Project Deschutes CDU正在研发中,计划贡献给OCP社区,以推进行业标准化,促进液冷技术的广泛应用。该项目积极整合了制造品质、系统可靠性、易维护性以及快速部署能力,为液冷技术的工业化发展奠定基础。 新型电力分配技术和液冷技术的完美结合,为数据中心迎接AI时代带来了新的机遇和挑战。功率密度的大幅提升要求电力系统具备更好的弹性和高效性,同时热管理技术也需要更具前瞻性的设计理念。与此同步,行业间的开放合作与标准化进程愈发重要,通过共享设计规范、最佳实践和技术经验,可以大幅缩短解决方案的市场推广时间,降低整体运营成本。

近年来,AI硬件技术发展迅速,从芯片设计到系统集成都在不断突破极限。这不仅要求数据中心在硬件层面提升供给能力,也意味着运维管理的复杂性大幅上升。数字化、智能化的运维工具因此应运而生,通过实时监控电力和液冷系统的运行状态,预测设备潜在风险,实现故障的预防和快速响应。智能化管理将成为未来高密度AI基础设施管理的关键驱动力。 展望未来,AI算力需求将继续攀升,数据中心面对的压力也将进一步加剧。多样化的算力需求和复杂的系统架构,呼唤更灵活、更模块化的基础设施设计。

高电压直流配电和液冷技术作为核心支撑方案,将围绕提升性能、节能减排和可靠性展开更多创新探索。同时,能源结构的持续绿色转型也对数据中心提出了新的要求,如何实现与可再生能源的深度融合,最大化整体能源利用效率,是下一步的重要方向。 总的来说,AI基础设施正处于技术变革的风口浪尖。通过采用先进的±400伏直流电力分配体系和高效液冷技术,数据中心能够显著提升算力密度、降低能耗并保障系统稳定运行。开放合作与标准化推进,加速了行业的协同创新步伐,助力全球人工智能发展迈入新纪元。在这一过程中,既有科技巨头的技术引领,也有产业生态链上下游的共同努力,未来AI基础设施将成为数字经济和智能社会的重要基石,推动人类社会迈向更加智慧、高效和可持续的发展未来。

。