在迅速发展的技术领域中,评估工具(evaluation tools,简称evals)的重要性日益凸显。它们能够帮助开发者和企业精准衡量产品和算法的性能,推动持续改进,但为何到目前为止,评估工具还未能广泛落地应用?这一问题引发了业内专家Julia Neagu的深入思考。在她的分析中,不仅指出了评估工具未能普及的多重阻碍,也分享了GitHub Copilot评估过程中获得的宝贵经验。理解这些内容,对于想要在技术创新道路上保持领先的组织和个人尤为重要。评估工具未普及的原因十分复杂,其中技术实现与实际应用环境之间存在较大差距是关键之一。虽然理论上,评估能够提供明确的性能指标和优化路径,但实际上,构建一个适用于各种场景的评估体系面临重重挑战。

首先,数据的多样化和复杂性使得评估设计变得极为复杂。不同任务和算法的性质差异巨大,单一的指标难以全面反映系统的真实表现。其次,用户需求和预期的多样化也为评估结果的解释与应用带来难度。评估分数虽能量化性能,但如何结合实际业务目标制定恰当的评估标准,仍然是一门艺术。技术上的挑战之外,组织内部对评估的认识和接受程度也是决定其落地与否的重要因素。许多团队在面对评估结果时,存在认知偏差或抗拒变革的情绪,影响了评估反馈转化为有效改进的进程。

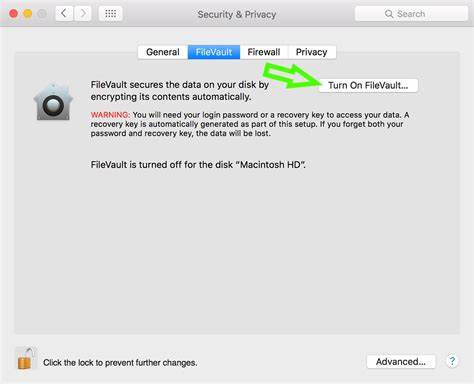

与此同时,评估工具往往缺乏易用性和集成性,导致开发者难以顺利融入工作流,进一步延缓了推广速度。GitHub Copilot作为目前最受关注的人工智能编程工具之一,在实施评估过程中积累了极具参考价值的经验。Copilot团队认识到,单靠标准化的指标难以全面理解模型的实际效用,因而采用多元化的评估方法,包括自动化测试、用户行为分析与质性反馈相结合。通过持续跟踪用户对代码生成质量的满意度和效率提升,团队能够动态调整评估策略,从而更好反映真实世界的需求和表现。此外,Copilot评估汲取了用户参与的重要教训。邀请真实开发者参与评估,不仅丰富了数据来源,也增加了评估结果的说服力和实用性。

用户实证反馈成为改进模型的关键驱动力,促进了产品与市场需求的深度契合。另一项关键启示是对评估工具本身的灵活性和适应性的重视。Copilot团队开发的评估框架能够适应不同产品阶段和版本的变化,帮助团队迅速识别优势与不足,保持了评估的持续有效性。这种敏捷的评估机制对于在高速迭代的技术环境中保持竞争力至关重要。未来,评估工具的进一步推广和优化仍需多方面协同努力。技术层面,需要突破传统指标体系的限制,构建更具场景适应性的多维度评价模型。

组织层面,提升对评估价值的认知,培养开放的文化,增强评估反馈的转化能力同样必不可少。用户参与的深度融合和评估工具的智能化发展将成为重要趋势。总结来看,评估工具尚未广泛落地的是一个多维度问题,既有技术难题,又涉及文化与流程。Julia Neagu对这一现象的深入解读为业界提供了宝贵视角。结合GitHub Copilot的实践,也让我们看到了评估如何从理论走向现实,通过不断调整与创新,推动技术产品迈向更高水平。只有正视挑战,吸取经验,持续优化,评估工具才能发挥应有的作用,为技术进步和价值创造注入强大动力。

对开发者和企业而言,理解并践行这些教训,无疑将提升自身的创新能力和市场竞争力,为未来构建更加智能、高效的技术生态铺设坚实基础。 。