近年来,生成式人工智能(Generative AI)和大型语言模型(LLM)的快速发展,推动了智能应用在各领域的深度融合与创新应用。从智能问答、知识图谱到多模态内容生成,LLM技术无处不在。然而,如何将这些庞大且复杂的模型高效落地,满足用户对响应速度、推理效率以及系统稳定性的要求,已经成为行业发展的一大瓶颈。传统推理架构因资源分配僵硬、硬件耦合度高以及缺乏对动态负载的灵活管理,往往难以满足现代大规模分布式推理的需求。正是在此背景下,NVIDIA Dynamo作为一款面向低延迟和高吞吐量的分布式推理框架,结合Amazon EKS的容器编排与自动扩展能力,为生成式AI的推理服务提供了强有力的技术支持。NVIDIA Dynamo是一个完全开源且具有模块化设计的推理框架,支持主流的推理引擎如TRT-LLM、vLLM和SGLang,能够根据不同的业务场景,灵活组合推理组件、前端API服务器及数据传输库,实现与现有AI技术栈的无缝对接。

Dynamo最显著的创新之一是将推理流程中的预填充(prefill)和解码(decode)两个阶段进行分离,在不同的GPU或计算节点上独立优化计算,从而大幅提升整体推理效率和系统的伸缩性。传统架构中,这两个阶段通常绑定在同一GPU内运行,导致资源争用和性能瓶颈。通过独立调度,预填充阶段可以采用较低的张量并行度快速处理长输入序列,而解码阶段则能以高张量并行度高效生成输出,确保推理延迟降低且吞吐量增强。Dynamo还内置智能调度器“Planner”,实时监测请求率、序列长度、GPU利用率及队列等待时间等动态指标,根据应用预定的服务水平目标(SLOs),智能地决定采用分离推理还是传统模式,并动态调整各阶段的计算资源。该自动化调度大幅减少系统宕机风险,应对峰值请求波动,确保推理服务稳定高效。为减少模型上下文缓存(KV cache)的重复计算,Dynamo引入了“Smart Router”,该路由模块通过计算新请求与集群内KV缓存的重叠度,智能将请求定向至已缓存相关上下文的节点,不仅降低重复计算,更显著提升了系统的响应速度和负载均衡能力。

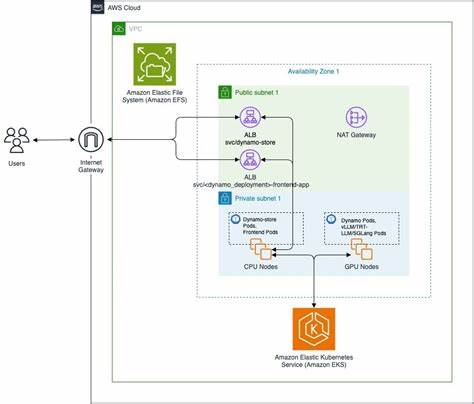

KV缓存作为推理加速的核心资产,其高昂的GPU显存消耗常成为系统瓶颈。Dynamo的KV Cache Block Manager采取分层存储策略,智能将历史数据从昂贵的GPU高速缓存层转移至更经济的CPU内存、本地SSD或对象存储,降低硬件成本同时保障高性能推理。数据传输方面,Dynamo配套了高性能通信库NIXL,支持GPUDirect Storage、UCX以及Amazon S3等多种后端,通过NVLink、Elastic Fabric Adapter(EFA)实现低延迟零拷贝数据交换,成为分布式推理架构中关键的性能保障。此外,Amazon Elastic Kubernetes Service(EKS)作为AWS提供的全托管Kubernetes平台,在管理复杂多节点分布式推理工作负载时展现出强大优势。EKS支持多种GPU实例类型,如最新的P6、G6系列GPU,配合EFA实现节点间高速网络通信,大幅降低分布式推理的通信延迟。通过Karpenter自动扩容组件,EKS能够基于实际推理请求动态调度计算资源,实现按需弹性伸缩,保障推理服务的高可用与成本效益。

EKS的存储集成丰富,支持Amazon EFS、Amazon FSx for Lustre等多种共享存储选项,使大模型权重能够高效分发至计算节点,满足模型加载与缓存需求。搭配Amazon CloudWatch和Prometheus监控体系,运维人员能实时洞察推理集群健康与性能状态,快速定位和解决潜在故障。实际部署方面,AWS Labs开源的AI on EKS GitHub仓库为用户提供了基于NVIDIA Dynamo的完整蓝图及自动化脚本,涵盖基础架构搭建、监控配置、Dynamo Operator安装等关键环节,极大简化了复杂分布式推理服务的搭建流程。无论是单节点还是跨多节点的大规模部署,用户均可以轻松实现高性能生成式AI模型的在线推理。综上所述,NVIDIA Dynamo与Amazon EKS的结合,创造出了一个灵活、可扩展且高效的生成式AI推理平台。其创新的推理阶段分离架构、智能动态资源调度、缓存机制优化与高速数据传输,以及AWS云原生服务的完美整合,彻底解决了传统推理系统在性能与成本上的困境。

随着AI模型规模的不断提升和应用场景的多样化,这一解决方案将助力企业快速部署低时延、高吞吐的智能应用,实现业务创新和用户体验的跃升。前瞻来看,随着NVIDIA Blackwell GPU的推出及更多云端算力的普及,基于Dynamo和EKS的分布式推理平台将继续增强计算能力和弹性扩展性,支持更复杂、更大规模的生成式AI任务。开发者和企业可通过加入开源社区,借助丰富的示例和文档,加速AI推理架构的定制化开发与优化,迎接生成式人工智能新时代的巨大机遇。总结来说,在生成式人工智能高速发展的当下,NVIDIA Dynamo联合Amazon EKS为行业提供了高效、灵活且经济的推理解决方案。通过巧妙设计的推理流程拆分、智能调度、缓存管理以及高性能网络传输,显著提升了大型语言模型推理的性能和资源利用率,助力企业构建高质量的智能产品与服务。随着技术的演进和应用的深化,这一协同平台将成为企业实现生成式AI规模部署与创新的坚实基石。

。