近年来,随着人工智能技术的日益成熟,尤其是在深度学习领域,模型的规模和复杂度不断增长。大型语言模型和基础图像模型层出不穷,为自然语言处理和计算机视觉等任务带来了显著突破。然而,模型庞大的参数量也让部署和应用变得愈发困难,尤其是在资源有限的移动设备和普通计算机上。存储需求巨大和高昂的计算资源消耗成为阻碍技术普及的关键瓶颈。在这样的背景下,二值化神经网络应运而生。它们通过将传统神经网络中的浮点参数极端简化为只有二进制值的形式,大幅度减少模型占用的内存和计算开销。

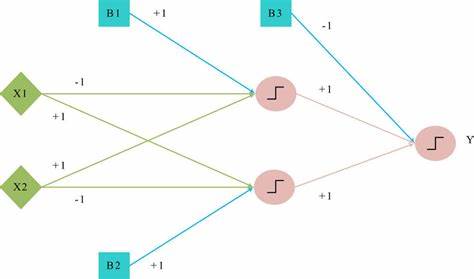

最新的研究聚焦于一种名为"二值归一化层"(Binary Normalized Layer)的创新型神经网络层,这一层设计巧妙地将所有的参数,包括卷积核权重和偏置,都限制为仅有0和1两种取值。与传统的32位浮点数进行比较,这种极简化的大幅压缩不仅节省了内存,而且极大地提升了模型推理速度。值得关注的是,二值归一化层并不限于某一种特定网络结构。无论是常见的全连接层、卷积层,还是最新的注意力机制层,都可进行相应的二值归一操作,从而构建出不同种类的神经网络模型。这种灵活性使得二值归一神经网络能够应用于广泛的任务场景,包括图像分类、语言模型预测和序列生成等。二值化虽简化了参数表示,但设计团队依靠细致的归一化策略和特殊的训练技巧,确保模型性能基本不受影响。

研究表明,在多类图像分类任务中,搭载了二值归一层的神经网络与传统使用32位浮点数参数的模型几乎不相上下,保持了高准确率和良好泛化能力。同样,在语言模型部分,经过适配的变换器模块也展现出了接近传统模型的强大预测能力。二值归一神经网络的最大优势或许在于其资源效率表现。通过将参数精度降低到一比特,模型内存需求可缩减至原来的32分之一,这对于实际部署意义重大。使用普通的CPU、低功耗移动设备甚至嵌入式系统均可运行复杂的深度学习任务,无需昂贵的专用硬件支撑,为人工智能普及铺平道路。此外,二值归一层的设计不依赖特殊的硬件指令集或加速器,直接兼容现有软硬件环境。

这意味着开发者无需重新设计底层架构或采购高端设备,便能轻松获得指令优化带来的性能提升。这种即插即用的特性,进一步降低了采用门槛,加速了技术的推广与应用。当前,二值化技术在学术界和工业界均引起广泛关注。除了二值归一神经网络之外,还有各种二值神经网络架构被提出,旨在探索极简参数表示的可能性。然而许多方案在稳定性和精度保持方面仍面临挑战。相比之下,二值归一层的提出,不仅提高了模型在实际应用场景的可用性,同时兼顾了性能和效率之间的平衡。

从未来展望来看,二值归一神经网络有望成为深度学习领域的突破口之一。基于单比特参数的模型可应用到物联网设备、智能家居、边缘计算等需要节省存储和计算资源的场景。面对人工智能在更多行业的落地需求,如何腾出计算能力,把更多能量投入到模型创新和算法优化,将是二值归一神经网络带来的深远影响。此外,随着计算硬件的发展,更多针对二值化运算的优化指令和专用芯片亦有望诞生,为相关技术的爆发式增长提供助力。与此同时,研发人员还将持续探索进一步提升二值化模型精度与适用性的算法,克服极端简化带来的信息损失,推动神经网络向轻量化、高效化方向迈进。综上所述,二值归一神经网络以其创新的单比特参数结构,实现了内存和计算效率的革命性跨越。

其不仅缓解了大型模型部署难题,也为广泛应用提供了强有力的技术支撑。随着更多实际案例的展示和优化技术的进步,二值归一神经网络无疑将在未来人工智能发展中扮演愈发重要的角色,开启深度学习新时代的全新篇章。 。