在人工智能和自然语言处理领域,检索增强生成(RAG)技术多年来被广泛应用于信息检索和生成任务中,凭借其高效从海量数据中抽取关键信息,并结合生成模型输出结果,满足用户多样化需求。然而,随着大型语言模型(LLM)上下文窗口的不断扩展,传统RAG系统的局限性日渐显现。一家名为VibeRank的创新公司率先将长上下文技术付诸实践,成功革新了其应用推荐系统,彰显了长上下文时代的新潜力。 VibeRank是一家致力于技术应用发现和排名的平台。类似于产品猎人(Product Hunt),但以AI驱动的个性化推荐为核心竞争力。用户通过VibeRank可以浏览各类热门技术应用,涵盖人工智能工具、开发者工具、生产力软件以及社交平台等多个领域。

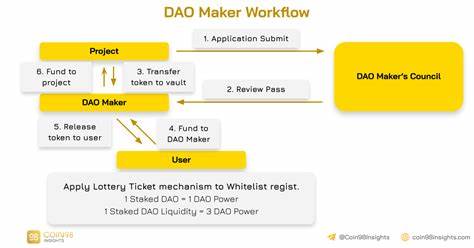

更重要的是,用户不需要通过繁琐的关键词搜索或者复杂的分类筛选,只需用自然语言描述需求,例如“我需要一款用于AI演示文稿创建的工具”,系统即可基于上下文进行智能推荐。 VibeRank团队大胆舍弃了目前业界主流的RAG体系,转而将整个应用数据库直接加载至谷歌最新发布的Gemini 2.5 Flash的上下文窗口。 这一举措无疑提升了推荐的精准度和关联性,同时显著降低了系统复杂性。传统RAG系统依赖于多步的数据库检索、向量嵌入计算和复杂的排序算法,不仅增加了系统维护成本,也容易错失完整生态中的潜在联系。相比之下,长上下文模式通过让AI模型一次性“读入”整个数据集,实现了对各应用之间内在关联、功能互补性的直观理解,推荐效果更加多样和深度。 在技术架构上,VibeRank的流程极其简洁。

首先,用户输入自然语言查询;接着系统从Supabase数据库中管理的应用信息中提取全部内容;随后将完整数据通过格式化整合进Gemini的上下文窗口中,最后由模型直接输出最相关的五款应用。通过这种方式,避免了对向量搜索算法的依赖,也无需进行繁杂的语义相似度计算。 此外,VibeRank指出,RAG技术的关键短板在于其检索机制基于局部语义匹配,容易陷入“关键词陷阱”,难以捕捉用户隐含的多维需求。例如,当用户询问与AI制作演示文稿相关的工具时,RAG大多只检索到直接匹配的应用,却忽视了与演示设计、协作或者内容生成相关的周边工具,而这些信息恰恰对用户价值极大。更何况,长期维护一个高效的嵌入模型及其检索体系,对资源有限的中小团队而言成本非常高昂。 Gemini 2.5 Flash所支持的百万级令牌上下文窗口,为VibeRank提供了处理整个数据库的能力。

当前,他们的数据集大小约为13万令牌,仅用了上下文容量的13%,这意味着还有巨大的升级空间。更为重要的是,技术趋势表明各大模型的上下文容量正在以惊人的速度增长,这进一步强化了采用长上下文而非RAG的战略可行性。 VibeRank的成功案例映射了AI应用领域信息处理方式的变革。借助超大上下文,系统不仅能更全面地理解复杂、交织的数据结构,还能实现快速响应和低延迟,减少了传统多步骤调用引发的性能瓶颈。此外,长上下文使得AI具备了更强的逻辑推理能力,能够识别应用之间的间接关联和潜在组合,极大丰富了推荐的维度和层次。 当然,长上下文技术也存在局限。

数据库规模过大时,依赖单一上下文窗口可能带来成本和效率的挑战。因此,如何合理格式化与精简信息输入,适应未来数据爆炸性增长,仍是值得深入研究的课题。同时,行业内不排除将长上下文与检索增强方法有机结合,发挥各自优势,形成更灵活高效的混合解决方案。 总体来看,VibeRank以长上下文技术驱动应用推荐,突破了传统RAG系统的瓶颈,为大语言模型的实际落地和优化开辟了新思路。随着LLM上下文容量的不断扩大和计算性能的增强,相信越来越多的产品与开发团队将拥抱长上下文带来的便利,推动智能搜索、推荐及生成服务迈入一个新的发展阶段。 对于希望优化用户体验及提升信息处理效率的创业团队和技术研发人员而言,密切关注长上下文模型的进展与实践案例尤为重要。

未来从数据结构设计、交互体验到后端算法架构,都可能因长上下文而发生根本变化。与此同时,也呼唤业界持续加大对该技术的投入与探索,打造更加智能、灵活和符合用户期待的AI解决方案。 无论是替代RAG模式的长上下文还是融合两者优势的混合架构,核心理念始终指向一个目标——让人工智能理解并满足人类复杂多变的需求。VibeRank以其实践表明,长上下文不仅是一种技术升级,更是AI平台走向更高水平的关键路径。未来,随着技术日新月异的发展,我们有理由期待更多基于长上下文的创新应用出现在各行各业,助力数字化转型和智能服务的深度融合。