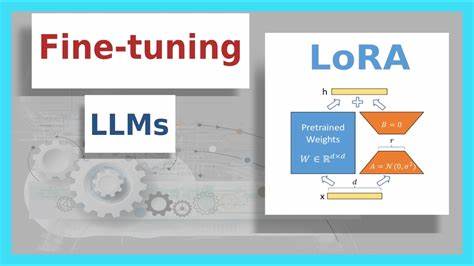

随着人工智能技术的迅猛发展,尤其是大规模预训练语言模型的广泛应用,如何高效地微调大型模型以适应特定下游任务,成为业界和学术界关注的焦点。传统的微调方法往往消耗大量计算资源,且存在过拟合或微调效率低下的问题。针对这一挑战,精准LoRA微调(Precise LoRA Placement,简称PLoP)作为一种崭新的技术手段,应运而生,不仅提升了微调的效率,也保证了模型对目标任务的精准适应。LoRA(Low-Rank Adaptation)是一种低秩适应技术,旨在通过添加少量参数,降低大模型微调时的计算复杂度和存储需求。它采用低秩矩阵分解的方式,只对模型中的部分权重进行调整,从而避免了昂贵的全模型微调。传统的LoRA方法已经在许多领域取得了显著成果,但仍存在对微调位置选择不够精确,导致性能提升有限的问题。

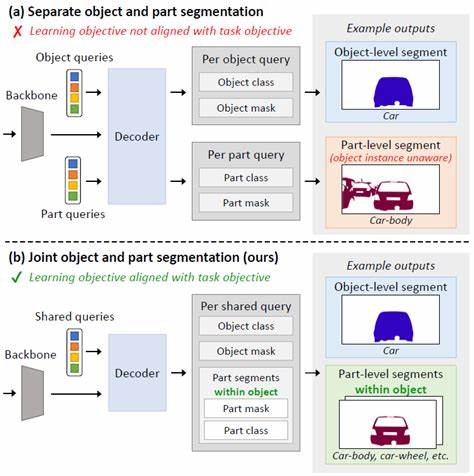

针对这一瓶颈,PLoP方法提出了针对性更强的LoRA参数部署策略,精确定位模型中关键层和模块,实施差异化的参数微调。PLoP通过计算模型中不同层及不同类型权重的敏感度,识别对特定任务最具影响力的网络组件。基于这一分析结果,PLoP在微调过程中将LoRA模块优先置于高影响力层,实现资源的最优分配。此举不仅提升了微调后模型的性能表现,还显著减少了计算资源的浪费。此方法的核心优势在于其数据驱动的策略,通过对微调对象的结构深入解析,避免了盲目或均匀微调带来的低效。同时,精准的位置选择使得模型在保持原有知识的基础上,更有效地吸收新任务的特征。

PLoP的应用场景十分广泛。特别是在数学推理、编程代码生成、历史事件解析及逻辑推理等多样化任务中,通过微调对应重点层,模型能够展现出更强的任务适应能力。研究者通过在不同数据集与模型上的实验验证,证明了该方法在准确率、推理速度及资源消耗方面均具有明显优势。此外,PLoP的实现相对简单,兼容主流预训练模型及微调框架,方便开发者和研究人员快速集成和使用。随着大规模语言模型的不断壮大,传统的微调方案面临的挑战日益严峻。PLoP的出现为行业树立了新标杆,推动了低秩适应技术的深度发展。

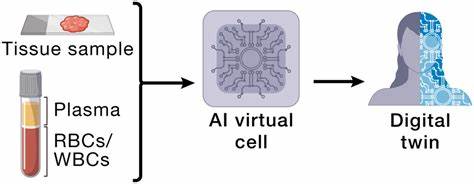

该技术不仅为学术研究提供了新的思路,也为工业应用,尤其是需要快速部署定制化AI解决方案的场景带来了强劲动力。未来,精准LoRA微调技术有望与更多模型压缩、知识蒸馏等方法结合,实现更加高效、灵活且智能的模型调优。将微调的精准控制与自动化策略相结合,能够大幅缩短模型更新周期,降低企业部署门槛。总之,PLoP作为一种创新性的LoRA微调方法,通过精准定位和高效参数调整,显著提升了大型语言模型在多任务环境中的表现,彰显了人工智能微调技术的未来趋势。随着该技术不断完善和推广,必将在推动AI赋能各行各业、实现智能化转型中发挥重要作用。