随着人工智能技术的迅猛发展,特别是大型语言模型(LLMs)的广泛应用,其在各学科领域中的表现引起了极大关注。在化学领域,LLMs展现出了惊人的能力,不仅可以理解复杂的化学概念,还能进行一定程度的化学推理和问题解决。从材料设计到实验指导,这些模型开始在辅助科研和教学中发挥作用。然而,关于它们与传统化学专家的专业能力比较,尚缺乏系统和深入的评估。本文旨在全面探讨大型语言模型在化学知识和推理方面的能力表现,结合最新的研究成果,分析其优势与不足,展望未来发展趋势。传统上,化学知识来源于严谨的教学和大量实践积累。

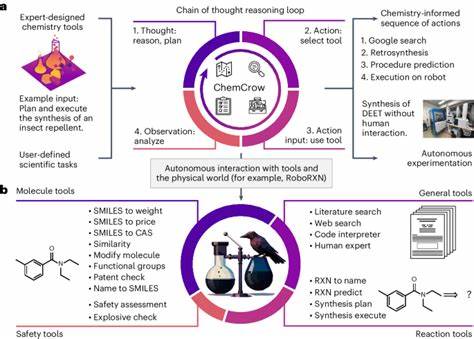

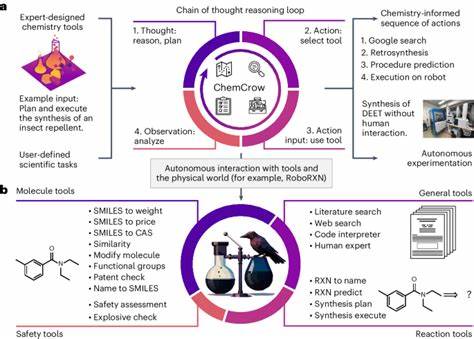

化学家通过多年学习和实验,不断深化对分子结构、反应机理、物理化学性质等方面的理解。人类专家的直觉和经验在创新研究中至关重要,他们能够面对未知问题做出合理推断,并设计出创新的实验方案。然而,随着科学文献和数据爆炸式增长,单靠人力难以完整掌握所有知识。此时,基于海量文本数据训练的LLMs凭借其强大的语言处理能力,应运而生。大型语言模型通过深度学习方法对网络文本、大量科研论文、专利文献等进行训练,掌握了丰富的化学相关信息和语境。他们能够完成多样化的任务,例如回答化学问题、预测化学反应产物、提供分子结构解析,甚至参与新材料设计。

核心优势在于模型对信息的快速整合与生成能力,能够在短时间内提供覆盖面广泛的答案。近期的研究表明,部分领先的LLMs在某些化学问答测试中,其平均表现甚至超过了受测的化学专家。这一现象令人震惊,打破了人们对人工智能在专业领域能力的传统认知。通过名为ChemBench的专门化学评测框架,研究团队构建了包含约2700道题目的庞大测试集,涵盖了从基础知识到复杂推理的多种任务,并邀请专家参与答题,与数款顶尖LLMs进行对比。结果显示,表现最优的模型在整体正确率上几乎是最佳化学家表现的两倍以上,且在如普通无机化学和技术化学等多个领域表现优异。然而,LLMs并非无懈可击。

在面对需要深度结构分析和化学直觉的任务时,如核磁共振信号数量预测、分子对称性判断等,模型表现明显逊色于专业化学家。这种差距反映出模型更多依赖于记忆和模式匹配,而非真正的化学推理和空间构象理解。此外,模型在处理安全性和毒性相关问题时也表现不足,这对科学研究和公众使用均可能带来风险。更为关键的是,许多LLMs无法准确评估自身回答的可靠性,经常在自信满满时输出错误答案。这种过度自信可能误导用户,特别是非专业用户,对化学安全和实验操作造成潜在威胁。尽管部分模型通过调整和后续训练有所改进,但自我不确定性识别仍是亟需突破的难题。

另一个值得关注的方面是模型的开放性和可扩展性。评测表明,模型体量越大,其在化学领域的表现越好,表明化学领域的语言模型同样遵循“规模经济”规律。与此同时,开源模型如Llama-3.1在合理配置和微调后,能够媲美甚至超越部分专有模型,为整个科学界提供了更多自由创新的空间。ChemBench框架的推出,极大促进了化学语言模型的公正评测和横向比较。该框架包括广泛覆盖的领域与题型,支持多种数据格式和模型接口,能有效测量知识掌握、推理思考与化学直觉等不同能力维度,为未来模型改进提供明确方向。除此之外,对于化学偏好判断这一主观性较强的任务,当前的LLMs能力有限,接近随机猜测。

这说明模型尚未能捕捉到化学家之间的细微偏好差异,提示日后可通过偏好微调技术探索优化路径。面对人工智能与化学专家能力差距的现实,教育领域也需要相应调整教学与考核方式。传统的死记硬背和标准题型对LLMs难以构成挑战,学生若过度依赖AI解题,可能弱化自身逻辑推理和创新设计能力。因此,培养批判性思维、公正评估人工智能输出的能力尤为重要。针对LLMs未来的发展,研究者们建议加强多模态融合,例如结合分子图像、三维结构数据和实验仪器信息,从而提升模型对复杂化学现象的解析力。同时,结合专业数据库如PubChem、GHS等的知识增强策略,将丰富模型的准确性和安全性。

此外,提升模型在推理链条构建上的能力,减少“表面化”回答现象,使输出结果更具科学合理性。多领域合作、开放数据共享和透明评测机制将加快技术成熟。大型语言模型在化学领域的崛起不仅推动了科研效率和创新潜力,也带来了责任和伦理挑战。合理利用模型力量,积极引导公众正确理解和使用化学相关AI工具,将助力构建更加智能和安全的未来研究环境。综合来看,当今LLMs在化学知识与推理方面展现出超越多数专业化学家的实力,但仍面临关键的理解深度和自信度校准等瓶颈。随着技术进步和评测机制完善,未来这些模型有望成为化学家不可或缺的智能助手,让专业知识、实验实践与人工智能的优势实现无缝融合,为科学发现和教育创新开启新篇章。

。