随着人工智能技术的不断进步,语音生成技术已经成为人机交互、虚拟助手、智能客服甚至娱乐领域的重要组成部分。然而,对于实际应用来说,如何在保证语音质量的前提下,实现低延迟的实时推理,仍是业内面临的主要挑战。本文将从多个维度分析推理阶段的优化策略,探讨高质量与低延迟语音生成的关键技术路径。推理时间是语音生成中影响用户体验的核心指标之一。传统的高质量语音生成模型往往依赖复杂的神经网络结构,这使得推理过程计算量庞大,导致响应速度较慢。为了解决这一瓶颈,研究人员和工程师们不断探索模型压缩、加速算法与硬件协同优化等多方位手段。

模型架构的优化是提升推理速度的重要方向。针对生成速度和质量的权衡,轻量级神经网络结构受到广泛关注。经过精心设计的深度可分离卷积、多尺度特征提取和注意力机制等技术,有助于在减少参数和计算量的同时,保持自然语音的表现能力。另外,剪枝和量化技术也是大幅提升推理效率的有效方法。剪枝通过剔除冗余参数,使得模型更加紧凑,减少计算资源的占用;量化则将模型参数从高精度浮点数转为低精度表示,在保障误差可控的情况下加快运算速度。这些方法结合硬件的支持,能够实现边缘设备上的实时推理。

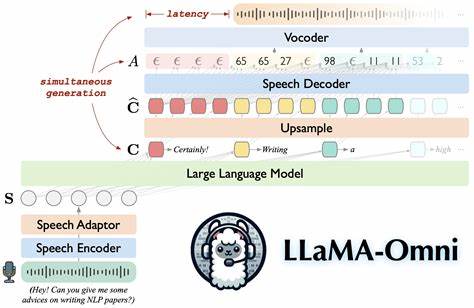

推理时序优化技术正在逐渐成熟。以流式生成为代表的逐步推理策略,减少了将整段语音生成完毕后再进行输出的等待时间,使得语音能够边产生边播放,极大地改善实时交互体验。此外,语音生成的多模态融合,例如结合文本上下文、情感标签和声音特征信息,有助于提升语音的逼真度和个性化表现,同时利用特定场景的先验知识指导推理过程,有效避免无效计算。硬件加速的应用为推理阶段提供了坚实支撑。现代GPU、TPU及专用AI芯片针对神经网络推理进行了专门设计,实现了更高的并行处理能力和能效表现。同时,针对语音生成的推理特性,硬件与软件的协同优化策略得以实现,进而降低延迟和功耗。

云端与边缘计算的结合,为不同应用场景提供了灵活的部署方案。云端拥有强大的计算资源,适合复杂模型的推理;而边缘设备则通过轻量级模型和加速技术实现低延迟响应。混合架构能够兼顾性能与及时性,满足用户多样化需求。此外,智能缓存和预测机制在推理中发挥着重要作用。通过提前预估用户的语音输入内容和模式,系统可以预先加载部分计算结果,缩短实际响应时间。结合动态语音合成和自适应编码,进一步优化整体生成效率和质量。

随着深度学习模型和生成网络框架的不断完善,未来语音生成技术将在准确度、自然度和交互性上实现突破。推理时间的缩短不仅提升了用户体验,也降低了设备能耗和运营成本,对于推动语音技术的大规模应用具有深远意义。面对日益增长的实时语音需求,开发者需持续关注最新推理优化方案,灵活应用各种技术组合,打造高性能的语音生成系统。综上所述,实现高质量、低延迟的语音生成,离不开模型结构的创新、推理流程的优化、硬件加速的支持以及智能计算策略的协同配合。随着多领域研究的深入和技术的迭代升级,未来的实时语音生成将更加高效、自然与智能,为人机交互带来更丰富多彩的体验。