随着人工智能技术的飞速发展,模型规模和计算需求也在不断提升,传统的个人计算机环境已难以满足运行超大规模模型的需求。Ollama公司近日推出的云模型服务预览版,为开发者和技术爱好者带来了全新的解决方案,使得在不具备大型计算资源的设备上,依然能够轻松访问和运行数百亿甚至数千亿参数级别的AI模型。 Ollama云模型的核心优势在于其强大的硬件支持和灵活的应用方式。依托于数据中心级别的高性能计算基础设施,用户只需通过本地工具连接云端服务,即可运行此前只能在专业级服务器上才得以实现的庞大模型。对于开发者来说,这既极大降低了创新门槛,也拓展了人工智能的应用边界。值得一提的是,Ollama在数据隐私和安全方面表现卓越,云服务过程不保留用户数据,确保信息安全无忧,符合现代用户的合规与信任需求。

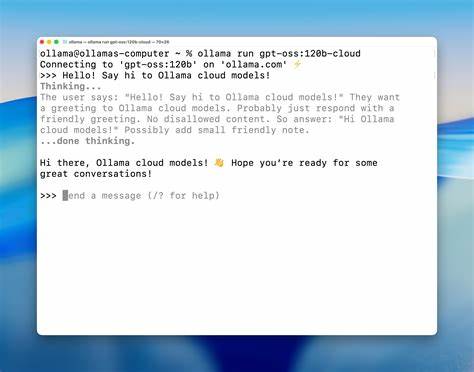

Ollama云模型不仅仅是计算资源的简单搬移,其设计理念强调了本地与云端的无缝集成体验。通过同样的命令行工具和API接口,用户能够一如既往地执行模型的查询、拉取、运行等操作,且无需学习新的工具或流程。例如,Ollama支持在终端直接运行命令启动云模型,用户能够实时感受到高速响应和高质量输出,且和本地模型的交互体验一致。这种便捷统一的操作方式极大提升了使用效率,降低了技术门槛。 从产品阵容来看,Ollama云模型涵盖了多个热门且性能卓越的AI模型,其中包括qwen3-coder:480b-cloud、gpt-oss:120b-cloud与gpt-oss:20b-cloud等不同规模的版本,满足不同计算需求和场景应用的多样化选择。此外,面向开发者的API支持JavaScript、Python及cURL等多种调用方式,适配主流编程语言和工具,方便嵌入各种应用环境。

通过简单的安装和调用流程,开发者能快速接入Ollama云模型服务,构建智能产品或实验环境。 在开放性与社区互动层面,Ollama积极链接GitHub、Discord等平台,建立起活跃的技术交流生态,帮助用户获取最新动态、解决使用难题。同时,详细且易于理解的官方文档进一步提升了用户的学习与使用体验。签入与签出机制安全可靠,确保用户访问云模型时的身份认证和权限管理,保障云计算的安全操作。 技术创新之外,Ollama云模型解决了AI开发中一个核心痛点,即本地设备性能瓶颈。随着模型规模的指数级增长,单机运行大型语言模型几乎成为不可能的任务。

通过云模型,开发者无需反复升级硬件,只需稳定网络支持即可轻松调用海量参数建模的能力,同时享受高并发与低延迟体验。这样的模式极大促进了AI技术的普及与应用深度。 未来,随着更多大型模型的推出和计算需求的提升,Ollama云模型无疑将在人工智能技术落地中扮演重要角色。其灵活、私密、高效的技术架构为企业和研究机构提供了宝贵的计算资源加速选择。特别是在自动化代码编写、自然语言理解、智能问答系统等领域,云模型有望成为推动创新的关键引擎。 综合来看,Ollama云模型是连接本地工具与云端强大算力的桥梁,是当前及未来人工智能应用场景不可或缺的基础设施。

它不仅帮助用户突破计算资源限制,也推动了AI技术的民主化进程。无论是技术研发人员还是AI爱好者,都能从中获得极大便利,实现高效智能创新。随着Ollama不断优化与扩展服务体验,更多新型智能应用将得以实现,带来改变社会生产生活方式的深远影响。 。