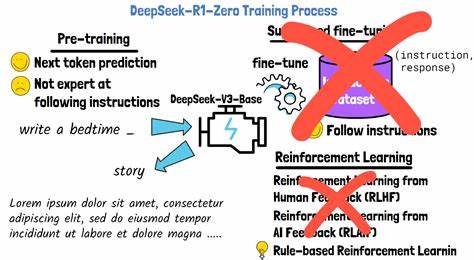

近年来,随着大语言模型(LLMs)在自然语言处理领域的广泛应用,其性能的提升问题引起了研究者和工业界的极大关注。在诸多优化策略中,强化学习(Reinforcement Learning,简称RL)后训练被认为是一种有效手段,尤其是在提升模型的推理能力和生成质量方面。伴随着DeepSeek R1等基于GRPO算法的成功应用,相关技术和方法获得了高度热议。然而,强化学习的应用前提之一是要将训练过程抽象成马尔可夫决策过程(Markov Decision Process,简称MDP),这一转化背后的结构性假设决定了RL方法的有效性和解释性。本文将深入分析这些结构假设,并探讨它们对强化学习后训练方法的影响。 强化学习在大语言模型后训练中的应用非常依赖一种结构性假设,即认为训练过程满足MDP的定义。

具体来说,MDP包含状态、动作、转移概率和奖励四个要素,其中状态代表环境的当前情境,动作是智能体选择的行为,转移概率描述状态间的变化规律,奖励则反映行为的优劣。然而,将大语言模型的训练过程建模为MDP主要依赖两大关键假设,分别是将状态视作上下文窗口中已生成的tokens序列(即动作的串联),以及将最终奖励均匀拆分到整个动作序列上的做法。 第一个假设将MDP的状态简单定义为先前输出的所有tokens的连接,动作则对应生成的新token。其表面逻辑看似合理,因为生成过程中模型根据上下文决定下一步输出。然而这种简化实际上导致训练过程缺乏真正的环境状态变化和不确定动态,整个生成序列更像纯粹的语言拼接,状态转移中隐含的随机性和环境反馈被忽视,使得问题退化为序列模型的训练。第二个假设则是对奖励分配做出了简化处理,将一个最终的正向或负向评价拆分成同等份额反馈于每一步动作。

这种均匀分配忽略了生成过程中各个token对最终结果贡献的差异,使得RL不能有效区分关键步骤和次要步骤,强化学习过程更像是受监督的整体结果拟合。 这两大结构性假设导致的直接后果是,尽管名义上采用了RL框架,训练本质上更接近于结果驱动的监督学习。事实上,实验表明,迭代的监督式微调(包括对正负样本的平衡训练)能够实现与GRPO为代表的RL方法相当的性能表现。这也暗示了所谓的“强化学习提升推理能力”的说法存在夸大空间,因为核心改进并非源于强化学习复杂的策略优化,而是得益于精心设计的监督数据及训练流程。 另外,进一步的分析还揭露了RL框架下的一种隐含激励——生成更长的中间token序列。这种长度增长被误解为模型在进行“更长的思考轨迹”,但实际上是结构假设驱动下的产物,模型试图通过延长输出序列来间接提升奖励,更多反映的是训练机制上的“技巧性”而非真正的推理能力提升。

总的来看,尽管强化学习是一个强大的方法论,理论上可以为语言模型的改进提供更动态和复杂的学习框架,但目前在大语言模型后训练中的应用仍然面临严峻的结构性挑战。本文通过揭示关键的假设缺陷,提醒研究者应警惕过度解读RL训练成果,同时鼓励探索更合理的MDP表述及奖励机制设计,从而真正利用强化学习潜力促进语言模型的综合能力提升。 未来的研究方向可以包括设计更真实、符合语言生成特性的状态表示,发展差异化的奖励分配策略以模拟复杂的人类评价体系,以及引入更加细粒度的环境反馈机制,避免将训练简化为静态的序列监督学习过程。同时,结合多模态信息和交互式训练,探索强化学习在多维度下提升语言模型泛化和自主推理能力的可能性。彻底颠覆现阶段的结构假设,将迈开强化学习助推大语言模型新纪元的步伐。 综上所述,强化学习在大语言模型后训练中的应用尚未达到理论与实践完美结合的理想境界,评估和理解其背后的结构性假设,是推动该领域深化和创新不可或缺的环节。

通过科学的结构分析与严谨的实验验证,未来或许能构建更具解释力和实用价值的强化学习语言模型训练体系,助力人工智能技术更高质量的发展。