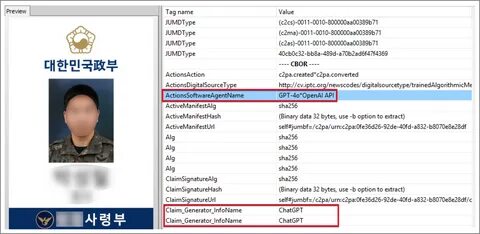

近年来,人工智能(AI)技术的迅猛发展为各行各业带来了颠覆性的变革,然而其负面影响同样引人担忧。最近,南韩安全研究机构Genians Security Center(简称GSC)披露了一起震惊网络安全界的案例:朝鲜黑客组织金硕基(Kimsuky)利用OpenAI旗下的ChatGPT生成伪造的韩国军方工作人员身份证,以便实施针对韩国防务相关机构的网络间谍攻击。这一事件不仅反映了AI技术被滥用的潜在风险,也揭示了全球网络安全防护面临的新挑战。金硕基是一个臭名昭著的朝鲜政府支持的网络犯罪团伙,长期以来致力于对韩国军方、政府和智库机构展开网络攻击。过去,该组织通常采用恶意钓鱼邮件和恶意Word文档作为攻击手段,但此次他们的战术显著升级,开始借助AI打造逼真的伪造证件,以提高攻击的隐蔽性与成功率。据GSC的研究分析,这次事件中的伪造军牌采用了深度伪造技术,利用公开获取的韩国军方员工证件照片进行合成,最终生成的图像极具真实感。

更令人震惊的是,生成过程中使用了ChatGPT的图像工具,尽管OpenAI已采取措施,阻止用户生成伪造政府身份证件,但攻击者通过巧妙的提示工程技术绕过了这些限制。他们将请求包装成"样本设计"或"模型演示"类话题,从而获得AI模型的协助生成假证件图片。这种利用AI生成伪造军牌的尝试,突破了传统身份验证方法的安全防线。生成的深度伪造图像随后通过伪装成关于军方雇员证件发放的邮件发送给目标机构,企图诱使受害者上当,从而为网络间谍活动开辟渠道。虽然GSC未公布受影响的具体机构名单,但可以推测涉事目标多为韩国防务及相关部门,这对国家安全构成了严重威胁。近年来,全球网络攻击手段不断升级, AI工具的加入极大地丰富了攻击者的武器库。

朝鲜黑客活跃在多个攻击项目中,除了利用ChatGPT进行伪造证件外,还采用Anthropic的Claude Code平台打造虚假身份,成功通过面试窃取企业内部信息,甚至参与代码开发。这些活动表明朝鲜背后的黑客组织正加速拥抱AI技术,实现攻击的智能化和复杂化。AI生成的深度伪造内容具有高度的迷惑性和说服力,传统的静态审核方式难以有效识别真假,加之攻击行为极具针对性,使得防御工作更具挑战性。OpenAI方面表示,正积极升级模型安全策略,封禁与朝鲜相关的可疑账户,致力于遏制国家背景的滥用行为,但面对诱导性提示工程,依然存在一定的监管盲点。此次事件再次提醒全球网络安全行业,AI技术的开发与应用必须关注滥用风险,建立更加完善的监测、识别以及应急响应机制。各国政府和企业需提升对AI辅助网络攻击的认识,加强对关键基础设施的安全防护,特别是在身份验证和邮件安全领域,采用多要素认证、行为分析等技术手段,最大限度地降低潜在威胁。

同时,应推动国际合作,分享威胁情报,合力对抗跨国网络犯罪,防止AI被敌对势力用于窃密和破坏。从更广泛的角度来看,AI带来的便利与风险并存。合理规范、积极防范其负面影响,是实现科技福祉最大化的关键。随着技术不断演进,网络空间的安全形势也将持续演变,社会各界应密切关注相关动态,筑牢安全防线,维护国家利益。综上所述,朝鲜黑客组织借助ChatGPT伪造韩国军方身份证的案件,展示了下一代网络攻击的技术趋势。深度伪造结合人工智能,极大提高了网络间谍活动的隐蔽性与复杂性。

强化AI模型的安全控制,加强对生成内容的审核,是未来阻止类似滥用的关键措施。各方延续合作与创新,才能在这场信息战中守护数字世界的安全与信任。 。