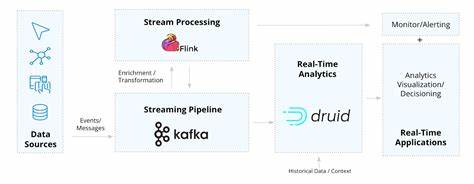

近年来,金融科技领域的快速发展推动了对实时资产管理解决方案的需求不断增长。尤其是在资产价格瞬息万变的环境下,如何快速、准确地获取数据,并基于数据构建科学的投资组合,成为投资者和机构关注的重点。传统的资产管理和组合优化多半依赖于离线数据分析,难以满足实时风险监控和动态调整的要求。基于此,利用流处理技术的平台方案成为行业新趋势。本文深入探讨了一套基于Apache Kafka和Apache Flink的实时资产管理系统,结合前沿的资产定价模型和算法实现,展现了流式数据技术在金融领域的强大应用潜力。 这套系统针对特定的股票市场资产,设计了一个全自动的实时投资组合优化流程。

通过模拟及采集目标交易所的十余种资产价格数据,将其以结构化的AVRO格式通过Kafka进行消息传递和分发,保证数据格式统一且技术兼容。Kafka的分区机制使得数据在多节点间高效且有序地传递,从而支持后续的高吞吐量流式计算。 在数据的初期赋值方面,系统采用金融界公认的Black-Litterman模型对资产权重进行初始分配。此模型能够将传统均值-方差优化和市场均衡观点结合,同时平衡主观预期和历史数据,更贴合实际市场波动。随后,系统基于Welford在线算法持续更新协方差矩阵和期望收益,以捕捉市场最新态势。通过无缝集成这一增量式统计算法,系统避免了重复全量计算,极大提升了计算效率和实时性能。

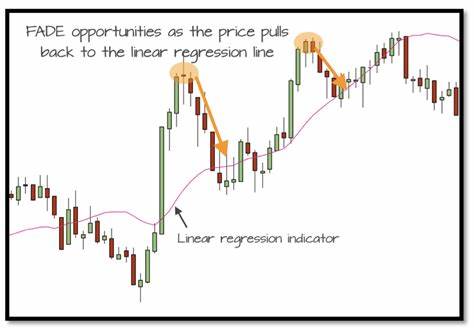

Apache Flink作为流处理核心组件,充分发挥其分布式、事件驱动的优势接入Kafka数据流。利用Flink的事件时间语义和水位线机制,该平台能够处理乱序数据,保证数据计算的准确性和一致性。来自股票价格流的窗口化处理精准计算资产的对数收益率,作为量化风险收益的关键指标并进一步为投资组合更新做准备。 数据处理完成后,通过Flink内置的状态管理,实时更新投资组合的统计指标并推送至Kafka中下游的主题。协同处理函数不仅维护最新的资产权重和组合统计状态,还动态计算Sharpe比率,度量风险调整后的收益水平。Sharpe比率的变化触发阈值判断机制,当投资组合效率下降至预定标准以下时,将启动权重的重新优化流程。

在重新优化阶段,系统采用Python编写的组件监听Kafka中的实时指标数据,整合PyPortfolioOpt库实现基于均值-方差理论的权重调整。增设正则化项有助于防止权重过度集中,提升组合的多样性和稳定性。通过多次迭代和参数调整,优化模型在提升Sharpe比率的同时降低组合波动风险。新得到的权重数据被编码成AVRO格式再写回到Kafka相应主题,完成闭环控制,确保系统在不断的反馈中保持高性能表现。 除了核心的数据采集与计算外,系统还兼顾可视化和告警需求。利用InfluxDB和Grafana对Kafka的主题数据进行实时监测和趋势分析,辅助投资决策并提供主动风险管理功能。

当系统检测到风险指标异常时,通过Grafana自定义规则触发通知,有效实现投资组合的自动化守护和响应。 从DevOps层面来看,系统组件均采用容器化方式部署,结合Kubernetes集群实现弹性扩展和高可用保障。Kafka和Flink的安全通信接入确保数据传输的保密性和完整性。尽管现阶段部署为本地化环境,架构设计已充分考虑未来向云端迁移的可能性,如AWS管理Kafka服务和Flink托管环境,为系统持续演进搭建了稳固基础。 整体而言,该基于Kafka与Flink的实时资产管理方案以创新的实时数据流技术为驱动,在金融市场波动环境下实现了资产组合的动态优化和风险控制。它不仅提高了数据处理的及时性和准确性,也通过自动化反馈循环极大地优化了投资决策效率。

此类系统的成功开发和运用,正是现代金融信息技术进步和智能投资理念融合的典范,预示着资产管理行业即将迈入更高效智能的新时代。未来,随着更多数据源接入和算法持续改进,这一框架具备广阔的扩展性和应用价值,将为投资者带来更加精准、多样化的资产配置方案。