在当前自然语言处理技术快速发展的背景下,分词器(Tokenizer)作为将文本转换为机器可识别形式的关键工具,显得尤为重要。Hugging Face的transformers库及其背后的tokenizers包为开发者提供了丰富的预训练模型和灵活的分词器实现,广泛应用于文本生成、情感分析、机器翻译等领域。然而,尽管功能强大,tokenizers包在实际的复杂分词器编辑和调试过程中却存在一定挑战,尤其是在处理tokenizer.json文件时,结构复杂且错误信息难以定位。基于此,Skeletoken应运而生,作为一个专门面向编辑tokenizer.json文件的Pydantic数据模型包,它大幅简化了分词器修改的流程,提高了开发体验。Skeletoken整体设计基于严格的数据模型定义,通过完全模拟transformers中tokenizers所使用的json结构,确保任何通过Skeletoken构造的数据模型都能被原包成功解析。这种严格的结构约束不仅保证了数据完整性,还借助Pydantic强大的校验功能在编辑过程中及时发现问题,大大降低了出错概率。

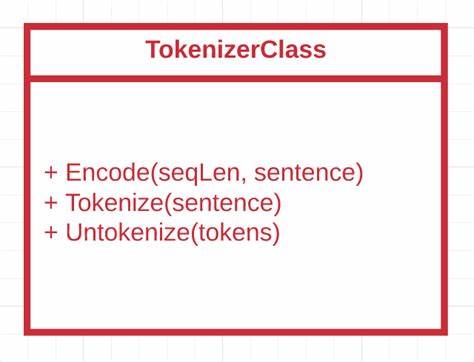

传统上修改tokenizer.json文件往往依赖手动编辑,这种方式不仅繁琐而且容易导致格式错误。一旦出现解析失败,tokenizers提供的错误信息往往只指出问题大致位置,难以定位具体错误,比如非法词表项往往只报错词表末尾位置。Skeletoken通过在加载阶段自动进行校验和修正,避免这类模糊错误,令开发者能够快速精准地定位问题并予以修复。使用上,Skeletoken极其方便。只需通过pip安装即可快速集成到现有的工作流程中。加载一个预训练分词器后,Skeletoken允许用户以结构化数据形式访问其各组件,包括词汇表、预分词器、正则表达式过滤器等,从而可以安全地新增、删除或修改任何部分。

例如,将某些特殊符号或数字分割为单独tokens,或者调整词汇的大小写处理策略,都能轻松完成。以自动修复分词器为例,一些大型模型如Qwen3-0.6B的分词器中包含许多非词汇表中的特殊tokens,导致词汇数量和分词长度出现不一致问题。Skeletoken能自动检测并修复这类问题,使得tokenizer.vocab_size和len(tokenizer)维持一致,避免下游任务出现异常。此外,Skeletoken支持丰富的模型操作,如方便地实现tokenizer的去大小写功能(Decasing),将分词器词表中的所有词汇统一转为小写,从而在多语言环境下减少token数量,提升模型泛化能力。类似地,通过"greedy"模式的转换,Skeletoken能使模型在分词时采用更积极的匹配策略,从而提高分词粒度的灵活性和准确性,大幅增强实际文本处理效果。除了基本功能之外,Skeletoken还兼顾可扩展性,提供多种辅助函数和工具,支持开发者轻松添加新的模块或组件。

同时,严格的校验机制确保添加的新元素符合整体分词器约束,如新添加的词汇必须存在于词汇表,否则立即报错,有效防止潜在错误引入。开发者也能借助Skeletoken构建自定义分词器预处理逻辑,如数字分割器、特殊字符处理器等,为多样化应用场景提供支持。Skeletoken的设计初衷还包括为Hugging Face Trainer等训练流程提供更友好的前端接口,未来计划持续完善自动模型编辑和集成能力,使分词器调整成为一键式操作,极大提高开发效率。总结来看,Skeletoken通过提供完整且严格的数据模型定义,自动错误校验与修复,以及操作简便的接口,解决了tokenizers包在复杂分词器编辑中的痛点。其支持从基础编辑到高级特性定制,为自然语言处理模型训练和应用的分词层面提供了强有力的技术保障。广大自然语言处理开发者尤其是使用Hugging Face预训练模型的工程师,都能通过Skeletoken提升分词器管理和改造的能力,减少错误和开发成本,加速项目落地。

展望未来,随着自然语言处理技术的发展和任务需求日益复杂,分词器的定制化和智能化将成为关键环节之一。Skeletoken作为桥梁,助力研究者和工程师以结构化和规范化的方式掌控分词器的脉络,有望成为行业标准工具之一。企业级应用也可借助其稳定性和可扩展性,构建高质量、高效率的分词组件,满足海量文本处理和多语言支持的要求。总之,Skeletoken不仅是一款技术工具,更是一项极具潜力的创新解决方案,推动自然语言处理生态迈向更科学、透明和可控的未来。希望更多开发者关注并参与其中,实现共建共享,打造更智能、更高效的文本理解与生成系统。 。