近年来,随着人工智能技术的迅猛发展,尤其是在自然语言处理领域,基于大型语言模型(Large Language Models,LLMs)的推理能力达到了前所未有的高度。这些模型不仅能够生成流畅自然的文本,还能够在复杂任务中表现出多步推理的能力,解决问题时往往需要长时间的链式思考。然而,长链条的推理过程也带来了严重的可解释性挑战:每一个生成的词语不仅依赖于前面的内容,而且整个推理路径复杂而难以拆分,令研究者难以明确哪些推理步骤真正起到了关键作用。针对这一难题,最新的研究提出了“思想锚点”(Thought Anchors)的概念,意指在整个推理链条中,那些对最终答案产生重大影响且对后续推理起到支撑作用的重要推理步骤。这种观点的提出,有助于我们系统化地理解和分析大型语言模型的推理方式,从而提升模型的透明度和性能。 解读大型语言模型的推理轨迹一直是AI领域的研究热点。

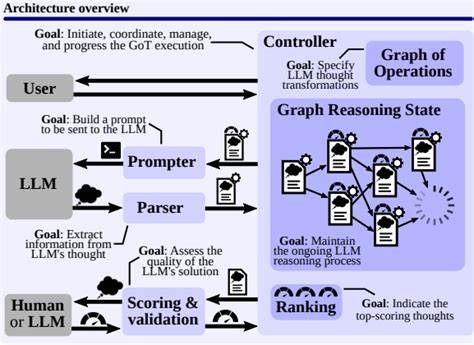

相比逐词分析,近期学者们提出从句子级别入手更为有效。句子作为相对完整的语义单元,既反映模型的思考路径,又便于进行定量评估。通过对句子的影响力进行归因分析,我们可以发现哪些关键句子在整个推理过程中起到了“导航”或“调整”作用,这些句子便是所谓的思想锚点。研究团队将这一分析框架细化为三种不同但互补的方法。 首先是黑盒方法,它基于模型生成的可观察输出,将某一句子替换成另一句意义不同的句子,然后通过多次重复推理实验(例如100次实验)观测最终答案的变化。如果更换该句子导致答案显著不同,说明该句子具有较高的重要性,这种实验证明了它是真正的思想锚点。

黑盒方法的优势在于不依赖于模型内部结构,使其具备普适性和兼容性。其次是白盒方法,则借助模型自身的注意力机制。通过聚合分析模型在推理过程中不同句子之间的注意力分布,研究人员发现存在某些“广播”句子,这些句子通过特定的“接收”型注意头获得后续句子的大量关注,成为推理的中心节点。白盒方法深入挖掘了推理结构中的信息流动,揭示了模型内部关注的动态机制。 最后一种是因果归因方法。该方法基于干预思路,通过人为抑制模型对某一句子的注意力,观察这一动作对未来句子生成的影响程度,从而量化该句子在推理链中的“因果贡献”。

此方法强调逻辑上的依赖关系,能够明确推理步骤之间的重要连接。三种方法互相验证,都指向了思想锚点的重要性。更有意思的是,研究发现思想锚点常常对应于模型推理中的关键活动,如计划步骤和回溯调整等。计划步骤通常是模型对后续推理路径的总体安排,而回溯调整则是模型重新审视并修正之前推理结果的行为。这些步骤对保持推理的连贯性和正确性至关重要,其思想锚点角色显而易见。值得一提的是,研究团队还基于上述方法开发了开源的可视化工具,方便用户直观地查看大型语言模型推理路径中的思想锚点及其影响力分布。

该工具有助于研究人员、工程师深入剖析模型行为,发现潜在改进点,促进模型设计的改进和优化。通过具体案例的展示,研究也证明了不同方法在识别同一推理过程中的思想锚点时具有高度一致性,体现了句子级分析视角的强大解读力。 认知可解释性问题在大型语言模型迅猛发展背景下日益成为瓶颈。传统方法难以应对海量参数和复杂推理轨迹,而思想锚点的提出为打破这一困境带来了新机遇。了解哪些推理步骤真正“撑起”了整条推理链,可以帮助开发者更有针对性地调优模型逻辑,避免无效步骤的冗余生成。与此同时,这种理解也提升了模型输出的可信度,使用户更愿意接受模型建议,尤其是在医疗、法律、科学研究等高风险领域。

实际上,思想锚点的概念也呼应了人类认知心理学中的“关键思维节点”理念。人类在解决复杂问题时,往往依赖于几个核心的思考环节来指导整体推理,其余推理环节则较为辅助。这一点与大型语言模型的推理行为高度相似,提示AI推理可能在一定程度上模仿了人类思维结构。未来研究可进一步探索这种类比,借鉴认知科学原理推动AI推理机制的演进。 越来越多的应用场景要求语言模型不仅能给出正确答案,更要有清晰的推理过程,使用户和监督者能够理解和检验推理逻辑。思想锚点分析正是满足这一需求的关键工具。

有了它,研究人员可以构建更加透明和可靠的推理系统,让AI模型的决策路径不再神秘,而是变得可追踪且易于解释。此外,这种分析也有助于检测和纠正推理中的逻辑漏洞或偏差,保障模型输出的质量与公正性。 综上所述,思想锚点作为大型语言模型推理链中的关键节点,肩负着引领和支撑整个推理过程的使命。通过黑盒、白盒和因果归因三种方法的综合应用,我们不仅能够识别出这些关键步骤,还能深入理解其作用机制。这一发现为深化大型语言模型的可解释性研究提供了全新视角,也为推动更加智能和可信的AI推理体系奠定了坚实基础。伴随着开源工具的推广和更多实证案例的积累,思想锚点分析有望成为未来大型语言模型设计、评估与优化的重要标准,推动人机交互迈向更高水平。

。