随着人工智能特别是大规模语言模型(LLM)的迅猛发展,人们越来越意识到与AI互动时所使用的提示(Prompts)对结果的影响程度远超预期。这种现象被称为"提示敏感性",即AI模型对输入提示的微小变化表现出显著不同的反应和输出。深入理解提示敏感性的复杂性,不仅能帮助我们更高效地利用AI,还为推动人工智能的未来发展提供了宝贵思路。提示敏感性并非简单的误差或偶然,而是一种伴随模型训练机制和概率分布特性的内在属性。它呈现出多层次、多维度的表现形式,反映了AI在处理语言理解、推理以及生成任务时的复杂行为。首先,环境与语境对提示敏感性有显著影响。

所谓"启动效应"(Priming),即在关键提示前后加入额外信息,可以引导模型进入特定思维轨道,促使它用不同的方式理解核心问题。这种背景信息的输入相当于为模型提供了不同的参照系,改变了它对下一个最可能输出的预测概率分布。例如,在解决复杂棋局的任务中,理论上无关紧要的诗歌或散文段落会"扰乱"模型传统的认知框架,使其跳脱出惯性思维,展开更宽广的探索,甚至找到创新性的解答。这说明,通过巧妙安排提示上下文,我们能够激发模型更多样化和创造性的输出结果。其次,提示中的约束条件直接影响模型的决策和推理策略。给模型设定明确的输出格式、回答限制或情感基调,有时会导致其行为产生质的转变。

例如,在涉及敏感话题或政治论述时,模型会根据提示中的用词细节,选择直接回答、延迟决断,或引用特定来源来规避风险感知。这种现象体现了模型在执行任务时的"适应性",它们根据提示中的限制自动调整信息检索、答案生成的路径和力度,类似于人类在面对复杂问答时判断发言方式的心理机制。约束的细微差异,引发模型自我调节和"安全感"变化,进而影响到回答的深度和表述的风格。第三,模型本身对同样的提示所表现出的敏感程度存在显著差异。虽然多种语言模型基于相似架构训练,但它们的版本演进、训练数据覆盖、优化目标和定制化指令带来了执行上的多样性。以自定义指令为例,不同的模型版本对相同的"请在答案末尾附上引用"这一指令响应不一,新版本可能会主动生成详细且规范的引用链接列表,而旧版本则可能仅出现基本的内联提示甚至完全忽视。

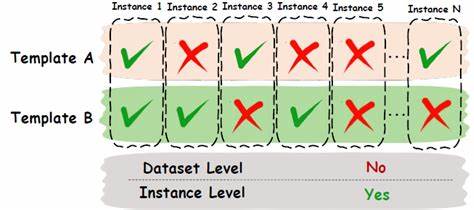

这反映出模型对提示的"增益"不同,提示效力与模型特性紧密绑定,优化提示策略必须以具体模型为参照,经过反复试验才能达到最佳效果。要充分发挥提示敏感性的优势,用户应当保持开放与实验的态度。使用简短诙谐的尾注、增加关联但非直接内容、调整提问方式的语气及约束,都可能创造意想不到的启发和结果。与此同时,理解提示敏感性也提醒我们,AI结果不是"唯一真理",同一问题多次尝试获得多样反应,有助于形成综合判断。技术层面,研究提示敏感性开启了对语言模型内在机制的更深入探讨。注意力机制(Attention Mechanism)是模型生成的核心,其对输入信息的权重分配决定了生成文本的方向和内容变化。

因此,微调提示方式实质上是在影响模型对上下文不同部分的注意分布,实现对结果精准调控。未来,提示设计可能成为AI交互领域的关键技能,用户不仅需要语言表达力,还需洞察模型特征与背景信息的交互效应,才能最大化AI潜力。总结来看,提示敏感性揭示了人机对话的非线性和多样性。它提示我们,应根据需求灵活调整提示结构,掌握"启动-约束-遵循"三重策略,从而在不同模型上实现更有针对性和创意的交互。随着人工智能工具日益普及,广大用户和开发者都应重视提升提示工程能力,把握微小变化中蕴藏的巨大潜力,推动AI助力各行各业。同时,持续探索和分享提示敏感性的实践经验,将使AI技术的应用更加成熟和高效,助力构建智能化未来。

。