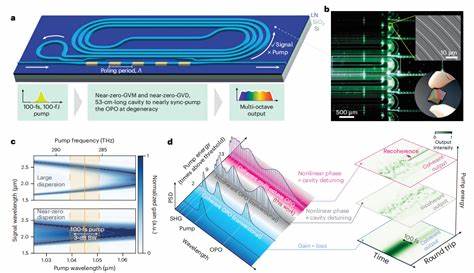

近年来,人工智能领域的迅猛发展催生了大规模语言模型(LLM)技术的广泛应用,特别是在生成式AI方面展现了巨大潜力。然而,随着模型规模的不断扩大和应用场景的日益复杂,如何在保证推理速度与质量的同时,实现资源的高效利用成为业内亟待解决的关键问题。PyTorch和vLLM的有机融合为这一挑战提供了创新的技术路径,尤其是在大规模分解推理(Disaggregated Inference)上的突破,为生成式AI的推理环节带来了前所未有的优化和提升。成熟的AI产品离不开高效的推理能力,而分解推理中"预填充-解码"(Prefill/Decode)策略尤为关键。该策略将推理过程分为预填充和解码两个阶段,分别在不同的服务器节点上独立处理。预填充阶段主要负责生成第一个词元,计算量大而集中;解码阶段则负责后续词元的逐步生成,内存使用密集且需要快速响应。

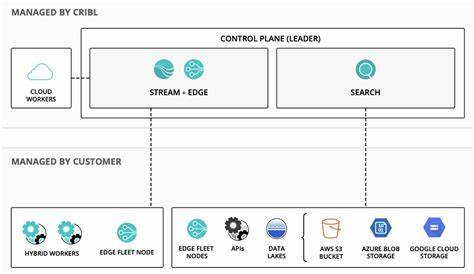

这种设计不仅让资源分配更为合理,也极大提升了整体推理的吞吐率和响应速度。Meta作为该领域的先驱者,结合其内部推理栈与vLLM实现了该策略的高效落地。在实际应用中,Meta通过对预填充和解码节点的独立扩容灵活应对不同负载,避免了传统一体机部署时预填充与解码比例固定、资源浪费严重的问题。尤其在延迟(如首次词元时间TTFT)和多次迭代词元时间(TTIT)指标上均获得显著提升,表现优于以往Meta内部的推理方案。实现这一目标,不仅依赖于PyTorch的深厚生态和灵活框架,还离不开vLLM针对分解推理的优化,包括其异步KV缓存传输机制和多线程多CUDA流的C++实现。KV缓存作为加速自回归推理的核心数据结构,其高效加载和转移直接影响推理速度。

vLLM采用异步的Python和C++ KV连接器协同工作,既保证了数据传输的最高并发,又避免了GPU计算资源的争用。此外,服务代理层的引入为请求路由和负载均衡提供了强有力的支持。预填充请求通过代理转发至相应预填充节点,KV缓存通过多个流通道异步传输,实现P2P样式的直接通信,有效降低网络开销。在高并发场景下,服务代理还能结合Meta内部成熟的路由机制,确保请求稳定均匀分配,大幅提升缓存命中率与资源利用率。为最大化传输效率,Meta团队还在底层网络通信架构上进行了深度优化,包括多网卡支持和多流并行传输技术。单一TCP流无法满载高速网络带宽,切片KV缓存并行传输成为突破瓶颈的关键。

同时,针对缓存同步过程中潜在的硬件调度与同步开销,vLLM对KV缓存块大小进行了调整,采用更大尺寸的缓存块减少频繁的小型内核任务调度,从而提升总吞吐量和稳定性。在实际应用中,预填充阶段采用计算密集的操作模式,而解码阶段则注重内存和批处理扩展性。这样的区分使得系统可以针对不同阶段进行专门优化,既保证了首词元的及时响应,又提升了后续输出的平稳连续性。尤其是在长文本生成或者对话场景中,预填充和解码的分离显著降低了整体系统延迟,提供更加流畅的用户体验。值得关注的是,Meta团队还探索了诸如仅传输缓存缺失部分(Cache-miss only KV-transfer)、预填充计算与KV缓存保存并行化等创新方向,这些研究有望进一步优化系统的延迟和吞吐表现。当前的推理堆栈仍在不断完善,包括对更高级通信协议如RDMA的支持,以减少TCP栈带来的网络开销,以及与数据并行(DP)、模型并行(EP)等多种分布式技术的深度整合。

此外,Meta也立足于硬件多样化,积极推进面向H100、GB200等下一代AI计算卡的定制优化,充分释放硬件性能潜力。更为重要的是,以上技术均同步不断贡献回vLLM开源社区,推动整个AI推理生态的良性循环和技术进步。未来,随着PyTorch生态的持续壮大与vLLM的功能完善,分解推理架构有望成为大规模推理服务的标准配置。对于广大开发者和企业用户而言,这将极大降低部署复杂度和成本,提升产品响应速度和稳定性。与此同时,围绕分解推理的调优经验、错误处理机制以及负载均衡算法也将在社区中持续沉淀,帮助更多项目实现最佳实践。总结来看,PyTorch与vLLM结合的规模化分解推理技术,通过精准的阶段划分、异步高效的KV缓存管理和先进的网络优化策略,成功解决了传统生成式AI在大规模场景下推理效率低下的瓶颈。

Meta的内部实践验证了该方案的可行性和优越性,而持续的开源协作则为行业带来更加开放和进步的未来。面对日益增长的生成式AI需求,这一技术创新无疑成为推动算力利用和用户体验双重提升的重要动力。 。