随着人工智能技术的快速发展,特别是大型语言模型(LLM)的广泛应用,在社会中引发了诸多伦理讨论。这些技术无孔不入,既带来便利,也隐藏风险,正如酒精在人类历史中的双重角色一样。酒精既能助兴,也能带来灾难,人工智能的伦理难题同样错综复杂,值得我们深入思考和辨析。大型语言模型被广泛应用于文本生成、自动代码编写、智能客服等众多场景,使我们的生活和工作发生了巨大变化。然而,正因为它的普及与影响力,关于其伦理性质的争议也日益激烈。人们一方面期待技术进步带来的红利,另一方面又担忧其可能引发的诸如隐私泄露、版权侵犯、虚假信息泛滥等社会问题。

这种矛盾的态度令人联想到酒精在人类生活中的角色。酒精作为一种化学物质,其本质具有毒性,长期和过度使用导致健康受损、家庭破裂、社会负担加重。然而,酒精同样是许多文化和社交活动的重要组成部分,合理饮用能够促进社交互动和身心放松。因此,很难简单地将酒精视为绝对的恶或善。同样,大型语言模型技术的应用也充满了一种“灰色地带”。有人会担心其带来的环境负担。

训练和运行LLM需要巨大的算力,进而耗费大量能源,而这其中很多还依赖于化石燃料,导致碳排放增加。能源消耗本身就引起了环保人士的关注,因为全球正处于减少温室气体排放的关键阶段。如何在享受技术便利的同时,降低其环境代价,成为技术研发和政策制定需要共同攻克的难题。此外,版权问题也是大型语言模型伦理争论的焦点。LLM往往通过吸收大量文本数据进行训练,这其中不乏受版权保护的作品。然而,目前法律体系对人工智能训练数据的版权界定仍不清晰,为创作者权益保护和技术创新之间制造了矛盾。

版权持有者担忧其作品未经许可被大量使用,而科技公司则希望保持数据的开放性和多样性以提高模型的表现。这一困境需要法律和监管框架的不断完善与调整,推动公平与创新的平衡。大型语言模型带来的另一隐忧是“信息污染”——即“语言模型产生的糟糕内容”或所谓的“Slop”。这些模型生成的内容有时难辨真伪,且可能带有偏见或错误信息。当人们误以为这些内容是人类创造时,实际上这可能违反了社会契约,影响社会公共认知和信任体系。人工智能促进了文本、图像乃至音视频内容的自动化生成,但也让欺骗手段更加隐蔽和高效,诸如深度伪造技术利用AI造假,不仅允许谎言传播规模空前扩大,更加剧了公众的疑虑与恐慌。

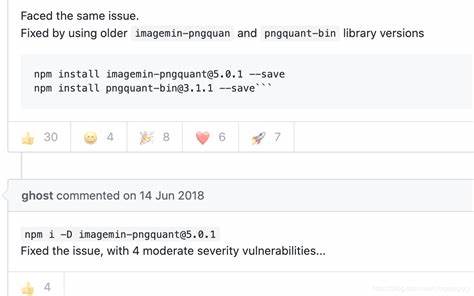

如何通过技术手段和社会制度减少这类欺骗风险,是未来治理的重要任务。尽管存在诸多伦理挑战,许多AI用户,包括专业开发者,在享受LLM带来便利的同时,普遍抱有一种复杂的心态:他们对技术可能带来的负面影响感到忧虑,却不认为自己应为由此造成的所有问题承担全部责任。比如开发者在日常工作中偶尔使用AI辅助编程,提高效率,虽然间接参与了消耗能源和版权争议,但并不会因此感到有负罪感。正如普通饮酒者享受酒精带来的放松,却未必承担所有酒后事故和家庭悲剧的责任一样。大型语言模型与酒精的对比,揭示了一个深刻的伦理问题:责任的分配与个体行动的界限。我们需要认识到,技术本身并非全然善恶,而是工具,关键在于使用方式与社会监管。

应对人工智能伦理问题,既要承认其潜在的风险,也要看到它带来的积极变化和创新可能。政策制定者、技术开发者和普通用户应携手合作,通过技术改进、法律制定和公众教育,最大化技术正面效应,最小化负面影响。与此同时,用户自身也应保持警醒与审慎,不盲目迷信AI的能力,在享受便利的同时保持批判思维。AI和酒精一样,都是人类文明发展中的产物,既需要智慧利用,也需要负责任的态度。展望未来,人工智能技术必将进一步融入社会各个层面,挑战与机遇共存。只有通过多方共同努力,推动技术规范化、透明化,并加大在环境、版权和信息安全等方面的投入,我们才能使大型语言模型成为造福人类的“良性酒精”,而非毁灭性的毒药。

正如人们依旧欣赏葡萄酒的芳香与文化内涵一样,我们也可以怀着谨慎乐观的态度,去探索和拥抱人工智能带来的变革。我们应当记住,技术伦理并非抽象远离生活的话题,而深刻影响着我们每个人的现实生活。理解和应对这些挑战,是当代社会每个成员不可推卸的责任。