随着大数据技术的快速发展,Apache Spark逐渐成为数据处理和分析领域的重要工具。然而,在互联网搜索引擎中,围绕spark serverless、spark cloud等关键词的搜索量却并不如预期般火爆。这一现象引发了业界的广泛关注和讨论,也让很多人开始思考Apache Spark究竟在市场上的需求量如何,以及它未来的发展趋势。首先,需要了解Apache Spark为何如此受欢迎。它是一种高速的集群计算框架,具备内存计算能力,能够极大提升大数据处理速度。相比传统的MapReduce,Spark可以在数据处理中节省大量时间,尤其适合批量处理、流数据分析、机器学习和图计算等场景。

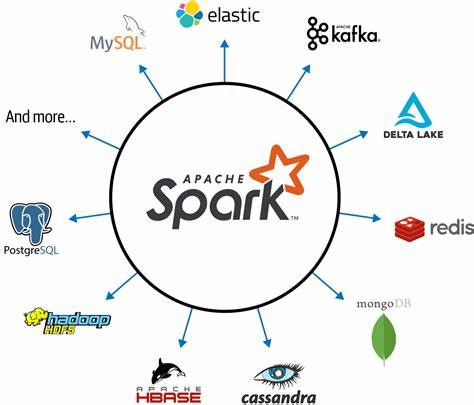

Apache Spark的生态系统丰富,拥有Spark SQL、Spark Streaming、MLlib和GraphX等模块,能够满足多样化的数据处理需求。尽管技术优势明显,Spark的搜索热度却相对平淡。通过Google关键词规划师可以看到,诸如“spark serverless”、“spark cloud”等相关词的月度搜索量仅在数百至一千之间,这与其在大数据领域的实际应用广度形成鲜明对比。为何会出现这种反差?一个重要原因是Apache Spark的部署和维护门槛较高。要搭建并稳定运行Spark集群,用户需要具备丰富的大数据集群管理经验,这限制了初学者和中小企业的使用。而且很多大型企业用户倾向于选择托管服务,比如Databricks、Google Dataproc等平台,这些服务为用户屏蔽了底层运维复杂性,直接提供可用的Spark环境,因此用户无须自己搜索并搭建“spark serverless”之类的解决方案。

另一个因素是市场相对集中。大规模数据处理需求往往来源于少数头部企业,它们是平台服务商的主要客户,因此付费用户基数较小但金额巨大。这种“少量高付费”的模式使得总体搜索量没有呈现爆发式增长。伴随着云计算的发展,无服务器架构(Serverless)成为技术趋势之一。许多开发者希望Spark能够无服务器化,降低使用门槛,实现按需弹性资源调配和按使用付费。这为构建“spark serverless”解决方案提供了巨大的市场潜力。

然而,无服务器Spark目前仍处于探索和发展阶段,缺乏成熟的开源产品和广泛认证的商业服务,导致搜索需求持续低迷。尽管如此,Apache Spark的未来依然被看好。首先,随着数据量和数据类型日益增长,数据处理性能和灵活性需求不断提升,Spark高速内存计算优势和模块化生态系统仍具有不可替代的价值。其次,云服务商积极推动Spark与自动化运维、容器化技术结合,助力实现更简便高效的部署与管理,从而吸引更多中小企业和个人用户。再者,AI和机器学习领域对大数据的挖掘需求激增,Spark集成的MLlib功能为开发者提供强大支持,促进其持续应用。总结来看,目前Apache Spark的搜索需求虽不显著,但并不能简单视为市场萎缩。

相反,这是生态成熟、用户结构稳定且大多依赖托管服务的体现。随着技术进步和无服务器创新的推进,Spark的使用门槛将进一步降低,市场需求有望出现新一轮增长。未来的机会不仅存在于大企业级用户,也将触及更广泛的中小企业和开发者社区。对于有志于数据领域发展的技术人员和创业者而言,深入了解和掌握Apache Spark无疑是把握大数据未来脉搏的重要方向。