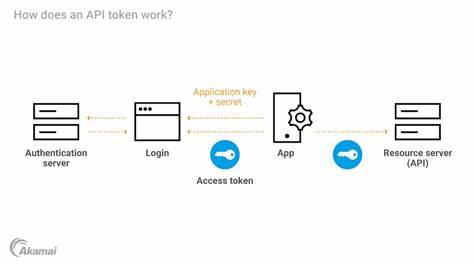

近年来,人工智能技术的飞速发展推动了大规模模型训练需求的激增。面对庞大的计算资源消耗,云端GPU租赁成为众多研究者和企业的首选。然而,租用分布式云服务中的GPU计算资源带来了存储管理上的挑战,尤其是在同步和挂载存储卷方面。为了提升训练效率和用户体验,业界逐渐兴起了一种创新的解决方案,能够实现跨多个知名云服务供应商的GPU存储卷同步和挂载。这种技术革新不仅降低了工作流的复杂度,也提升了数据的一致性与访问速度。 在云端训练AI模型时,数据存储的管理尤为关键。

传统方案往往局限于单一云环境中的存储服务,导致用户在多区域乃至多云操作时遭遇存储孤岛,数据无法实时同步影响实验进度。借助新兴的同步技术,用户可以在不同云环境甚至跨区域自由迁移与访问存储卷,保障了数据的连贯性和完整性。 这项技术的核心在于实现区域无关的存储卷,这意味着用户无需担心地理位置限制,通过智能的同步机制,数据可以在全球范围内自动更新和复制,为多地点协作和动态资源调度提供了强有力的技术支撑。从科研人员角度来看,这极大简化了实验环境搭建过程,保障了训练数据的同步性,使得模型更新和迭代变得更加高效便捷。 众多用户反馈显示,借助此类同步技术,跨云GPU资源的租赁变得更加灵活且稳定。研究人员能够以较低成本租用最佳可用GPU,并立即访问与更新其存储卷,无需担心数据丢失或延迟。

独立研究者和创业团队更青睐这一解决方案,因为它缩短了项目开发周期,提升了协作效率。与传统的手动数据拷贝和同步相比,自动化的存储挂载与同步降低了系统运维难度,减少了人为错误,保障了数据安全。 除了同步性能,存储卷的挂载能力也是关键。用户可将存储卷作为本地文件系统挂载到云GPU实例中,实现数据的快速读写,不再受限于网络带宽瓶颈。结合高速缓存机制与智能调度算法,这种挂载方式有效提升了GPU训练过程中的I/O表现,避免了瓶颈对整体性能的影响。这对于需要频繁访问大规模数据集的深度学习任务而言,尤为重要。

更进一步,跨云供应商的兼容性使得用户能够根据预算和需求灵活选择计算资源,云服务商之间的切换变得顺畅无缝。这种开放的生态环境促进了云计算市场的竞争,用户享受到了更具性价比的服务。此外,团队协作管理也得到优化,存储卷支持邀请多名成员共享访问权限,提升了研发团队的协同效率,支持分布式训练和数据共享。 云端GPU存储同步和挂载技术的兴起,不仅满足了AI训练的技术需求,也推动了云基础设施的演进。随着技术的不断成熟,未来我们可以期待更加智能化的存储管理平台,集成自动故障转移、多云负载均衡等高级功能,为AI开发者提供无忧的计算环境。同时,数据安全与隐私保护是持续关注的重点,通过加密传输和权限管控,用户的数据在同步过程中获得了多层保障。

总之,随着云计算与人工智能的深度融合,跨云GPU存储同步和挂载解决方案正在成为关键基础设施。它不仅简化了复杂的训练体系,提升了数据一致性和访问性能,还为多样化的应用场景提供了灵活支持。无论是科研机构还是创新企业,都能从中获益,推动AI技术迈入新的发展阶段。未来,围绕存储技术的创新将持续发生,助力人工智能在全球范围内更快速、更安全、更高效地发展。