随着人工智能技术的快速发展,基于大型语言模型(Large Language Models,简称LLM)的智能助手越来越多地在各行各业得到广泛应用。从客服自动化到内容生成,再到各类智能问答系统,LLM的强大能力极大地推动了数字化转型和业务创新。然而,随着这些AI助手频繁调用各种外部服务接口,如何保障API密钥等敏感信息不被泄露,成为行业亟待解决的安全难题。MCP Secrets Vault应运而生,作为一个本地的Model Context Protocol(MCP)代理服务器,它致力于将API密钥与AI模型的上下文完全隔离,从根本上防止密钥暴露风险。MCP Secrets Vault的核心理念是让AI助手能够安全地利用密钥完成特定操作,但AI助手本身永远无法获取密钥的真实值。它以TypeScript技术栈开发,具备策略驱动的访问控制机制、细粒度的速率限制及详尽的审计记录功能,确保密钥使用过程全链路安全透明。

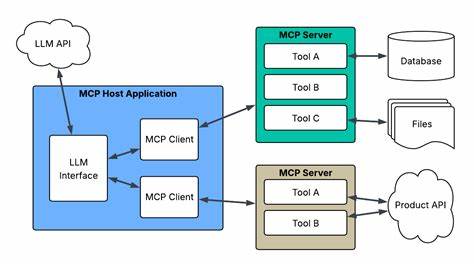

系统设计中,密钥仅存于环境变量,绝不写入响应、错误信息或审计日志,任何输出均经过严格的敏感信息过滤和脱敏处理。通过明确的允许动作和域名列表(如仅支持api.github.com的GET和POST请求),对外接口执行权限严格限制,避免滥用或未授权访问带来的安全隐患。在使用配置上,用户只需事先设置环境变量和编写JSON格式的配置文件,定义每个密钥的访问策略。例如,可以允许某GitHub API密钥仅对api.github.com域名执行HTTPGET和POST请求,并限定每小时访问次数,确保密钥在安全边界内高效使用。MCP Secrets Vault的架构清晰,主要包含策略评估引擎、速率限制模块、密钥提供模块和动作执行器。每个请求均需经过策略校验,符合允许范围后方可调用API,执行阶段密钥由执行器注入HTTP请求头或其他参数,且整个过程被审计日志详细记录。

日志格式统一为JSONL,便于合规管理和后期分析。相比传统直接将API密钥硬编码到AI模型上下文或者应用代码中,MCP Secrets Vault实现了密钥与调用环境的物理隔离,大幅降低了密钥泄露的风险。同时,策略层细化权限设计与速率限制机制,有效防止滥用和恶意请求。MCP Secrets Vault不仅支持现有的Claude Desktop客户端,还可以灵活集成到任意支持MCP协议的AI平台,充分发挥本地代理的安全优势。开放源代码的设计也便于企业根据自身需求扩展功能或调优安全策略。在安全策略方面,MCP Secrets Vault采用了输入边界校验、执行时机密注入、输出边界清理等多重防护措施,确保敏感信息无意间泄漏的可能性降至零。

所有动作无论成功与否,都被完整记录并分析,形成详尽的审计证明,适用于企业安全合规的需求。此外,快速安装部署和简明的配置文件,使得MCP Secrets Vault适合在开发和受控生产环境中快速试用和实施。对于开发者而言,项目提供了丰富的命令行工具用于发现秘密、描述策略、调用密钥执行请求及查看审计日志,极大地便利了在安全前提下的开发调试过程。未来路线图中,MCP Secrets Vault计划加入初始化向导、模拟执行模式、可视化审计查询前端等功能,力求提升用户体验和安全性能。业界日益增长的合规要求和安全防护意识,更使得类似MCP Secrets Vault这样的本地化密钥管理代理工具意义非凡。它不仅能为AI应用引入坚实的安全保障,还助力企业建立更为健壮的访问控制体系,避免因密钥泄露引发的经济和声誉损失。

总而言之,MCP Secrets Vault以其创新的本地代理架构和严密的安全模型,为AI助手和LLM调用外部API时的密钥管理提供了切实可行的解决方案。它有效实现了密钥的安全隔离与受控使用,提升了整体系统的安全韧性和合规性,是面向未来智能应用安全发展的重要基石。随着人工智能在更多敏感和关键领域的深入应用,工具和方案的安全性将成为制胜关键,MCP Secrets Vault无疑代表了这一方向的领先实践。 。