随着人工智能技术的不断普及和应用,从语音助手到大型语言模型,AI查询已经成为日常生活和各行各业的重要组成部分。然而,用户在享受便捷服务的背后,往往忽略了这些复杂算法运行所需要的巨大能源消耗。人工智能查询的能源成本不仅是技术层面的挑战,更与全球节能减排、可持续发展密切相关。深入了解AI查询的能源消耗,有助于推动技术优化和环境保护的双重实践。人工智能的核心在于海量数据的处理和模型的复杂计算。以大型深度学习模型为例,它们通常包含数十亿甚至数千亿个参数,在处理一次查询时需要通过大量矩阵运算和神经网络推理。

服务器必须提供强大的计算能力以保证响应速度和准确性,这直接导致高功耗和数据中心资源的高需求。目前主流的数据中心多采用高性能GPU或专用AI芯片进行推理运算,这些硬件单元虽提高了运算效率,但其能源消耗依然不容小觑。研究显示,一次复杂的AI查询可能消耗数十瓦甚至更高的电力,如果计算查询次数的全球总量,所需能源规模将异常庞大。除了运算阶段的耗能,训练阶段的能耗更是显著。训练一套大型的AI模型往往需要数周甚至数月的时间,各种服务器全天候工作,伴随着极高的电力消耗和碳排放。此外,随着模型规模迅速增长,维护和更新模型所涉及的迭代次数也不断增加,导致整体能源成本持续攀升。

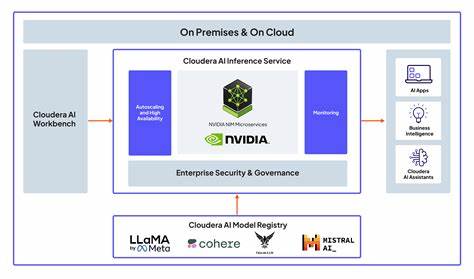

为了应对人工智能的能源挑战,业界正在积极探索多种优化路径。首先,模型结构的创新成为关键方向。通过设计更高效的算法,降低参数冗余,实现模型轻量化,使得同样复杂任务可以用更少的计算资源完成。另外,自动机学习和神经网络架构搜索技术的发展,有助于自动发现能耗更低且性能卓越的模型架构。其次,在硬件方面,定制化AI芯片的推广为降低能耗带来全新希望。这些专用芯片针对AI计算模式进行优化,能够以更高的能效比完成推理任务。

同时,利用边缘计算将部分推理任务下沉到本地设备,减少对云端巨大计算资源的依赖,也能有效降低整体能源消耗。再者,数据中心的绿色转型势在必行。采用清洁能源供电、提升数据中心冷却系统效率以及优化服务器利用率,都是减少碳足迹的重要举措。例如,利用风能、太阳能等可再生能源替代传统火电,正在成为大型科技公司的主流选择。用户自身的使用行为同样对总体能源耗费有影响。合理规划查询频率、避免无效校验、采用压缩数据和缓存技术,都能降低重复计算需求,从而节省能源。

人工智能的普及在带来便利的同时,也引发了新的环境伦理思考。社会各界逐渐认识到,只有平衡技术发展与生态保护,才能实现可持续的AI应用生态。政策层面对节能减排提出更严格要求,也促进了绿色AI的快速发展。未来,结合量子计算等前沿科技,有望进一步突破计算效率的瓶颈,显著降低能源成本。同时,跨学科合作将推动标准制定和最佳实践传播,让AI技术更环保、透明且公平地服务全社会。人工智能查询的能源成本是一个复杂且多维度的问题,它牵涉到技术、经济、环境和社会多个层面。

随着全球对气候变化的关注不断加深,如何在保持AI功能强大和响应迅速的同时,最大限度地降低能源消耗成为业界紧迫的课题。通过推动创新模型设计、改进硬件架构以及采用绿色能源,人工智能查询的能源效率将逐步提升,助力实现可持续发展的长远目标。在这个过程中,用户、企业和政策制定者需要共同努力,形成合力,打造节能环保的智能未来。 。