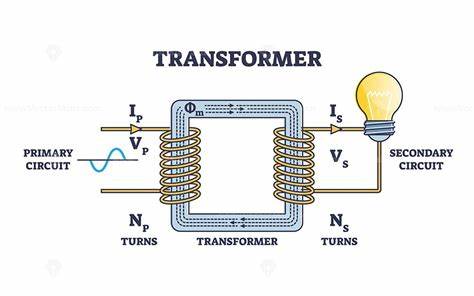

近年来,随着人工智能技术的迅猛发展,Transformer架构已成为实现自然语言处理和生成的核心技术之一。尽管Transformer模型在各种应用中表现卓越,但其内部的工作机制仍然是学术界和业界关注的焦点。Transformer电路(Transformer Circuits)作为研究大规模语言模型内部工作原理的重要工具,正在逐步帮助我们揭开深度学习黑箱的神秘面纱。Transformer电路研究源于Anthropic的解释性研究团队,该团队致力于理解大型语言模型的内部运作,以确保未来人工智能的发展更加安全可靠。Transformer模型以其灵活的自注意力机制和多层深度结构,能够捕捉文本中的复杂语义和上下文关系,但在此基础上的具体计算过程如何实现,却远非简单。目前,解释型研究领域中对Transformer内部机制的探讨主要聚焦于“电路”层级,即模型内部由神经元和边连接组成的计算通路。

通过对这些电路的追踪和分析,研究人员可以揭示模型在处理输入数据时的具体计算步骤,从而理解其行为模式。举例来说,一些近期的研究发现,Transformer并非一组黑盒子,而是由一系列可解释的子电路组成,这些子电路各司其职,例如识别语法结构、执行算数运算或实现上下文记忆。通过采用稀疏自编码器等技术,研究团队成功提取出大量具有明确含义的特征,甚至在某些层面上实现了语言模型的“内省”(introspective)能力。内省能力表现为模型能够自我观察和调整其状态,这一发现为未来构建更加安全和透明的人工智能系统提供了理论基础。除了基础的电路分析,Transformer电路研究还涵盖了关于“超位置”现象的探讨。超位置指的是模型中单个神经元承载多个语义概念的现象,这种复杂的组合策略有助于提高参数利用率,但也增加了理解难度。

为了解开这一谜团,学者们构建了多个玩具模型,从理论上说明了超位置产生的机制与发展动态,这为后续优化模型结构提供了关键指引。在解释性研究的同时,一些创新性的算法和工具也在不断涌现。例如,跨层特征一致性算法(Sparse Crosscoders)为跨不同层级和不同模型之间的特征对比提供了新思路,使得比较复杂模型时的分析更加深入和准确。除此之外,模型微调和差异化分析(Model Diffing)技术的发展,支持对模型安全性和有害输出的检测与防范,推动了AI技术的责任化发展。Transformer电路的研究不仅限于纯技术层面,对人工智能的伦理、安全和可控性也提出了新的视角。例如,研究团队提出通过自动化审计agent和解释性工具组合,实现对大型模型的自动化安全检测和对齐评估。

此外,观察不同人格化(persona)对模型回应的影响,也反映出模型生成文本时的个性塑造机制,这对设计定制化、可信赖的智能助手至关重要。Transformer电路的未来研究方向极具潜力。随着技术进步,更多高级电路分析工具将涌现,帮助我们进一步理解模型的多层次机制和复杂互动。模型的安全性、鲁棒性和公平性等关键问题也将在解释性框架内被更加深入地探讨。总的来看,Transformer电路的研究推动了我们从“黑箱”到“白盒”的转变,这对于构建透明、可控且安全的人工智能系统意义深远。在人工智能日益普及的今天,Transformer电路代表了理解和掌控深度学习技术的前沿。

通过不断深入的解释性研究,我们不仅能够优化模型性能,更能保障人工智能应用的伦理性和社会责任。未来,随着更多跨领域合作与技术创新,Transformer电路的研究将为全行业提供更好地理论支持和实践指导,助力AI走向更加可持续和可信的未来。