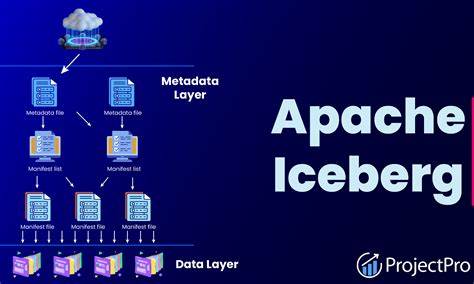

随着数据湖和数据仓库融合的不断发展,数据湖仓平台成为现代企业数据架构的核心支柱。Apache Iceberg作为领先的开源表格式项目,致力于为大规模数据湖提供可靠、高效且灵活的管理方案。2025年9月,Iceberg社区发布了备受期待的1.10.0版本,最大亮点是格式版本3(V3)的全面上线。此次更新不仅是对现有功能的完善,更是技术理念的飞跃,为复杂多变的企业数据场景提供更加高效、透明和易演化的解决方案。 Iceberg 1.10.0引入了二进制删除向量,彻底革新了传统的行级删除方式。过去,Iceberg依赖位置删除文件(position delete files)来标记已删除的行,在高变动场景中容易产生大量元数据,影响查询性能。

而新版本采用紧凑的Roaring位图,直接附加在数据文件上,轻量快速地追踪被删除的行。这样的设计不仅显著降低了元数据负载,还提升了面对变更数据捕获(CDC)和流式处理时的查询效率,极大优化了数据湖的运营成本和响应速度。 除此之外,Iceberg 1.10.0为解决企业在架构演进过程中的痛点,新增了默认列值功能。以往新增非空列时,常常需要重新写入大量历史数据,带来时间和资源的浪费。现在,表可以预设默认值,既覆盖历史数据,也适用于未来写入,保证模式演进平滑且无缝地支持生产环境。这一特性不仅提高了开发和运维效率,也降低了变更风险,使数据湖仓的扩展更加敏捷灵活。

在数据治理和审计方面,行级血缘追踪的引入尤为关键。Iceberg 1.10.0通过内置行标识和更新序列号,实现了对每条数据生命周期的精确监控。用户可以方便地追溯记录的变更历史,明确数据的生成时间点和修改来源,为合规监管、质量控制以及增量抽取提供了强有力的基础支持。此举标志着Iceberg不仅关注技术性能,更深度融合了企业对数据透明度和可信度的需求。 与此同时,版本3扩展了数据表支持的类型范围。引入的变体类型(Variant)满足了半结构化数据如JSON的原生存储需求,解决了传统关系型数据模型对灵活性不足的限制。

新增的地理空间类型包括几何和地理信息,赋能复杂的空间分析场景,服务于物流、移动出行、环境监测等多样化应用。纳秒级时间戳则满足高精度时间序列数据的存储与分析,配合未知类型支持,可无缝适应不断演变的模式,确保数据湖仓在未来具备更强的扩展性和适应性。 生态系统的兼容性同样获得质的提升。Iceberg 1.10.0默认支持Spark 4.0和Flink 2.0,保障了主流引擎与新表格式的无缝协同。开发者能轻松利用最新计算框架的性能优势,同时享受Iceberg带来的稳定一致的表管理体验。这对推动大数据分析架构的现代化升级具有里程碑意义。

Iceberg的更新不仅仅满足当前需求,更为未来发展打下坚实基础。社区计划在后续版本中支持多参数分区变换功能,实现分区策略的更复杂表达和更精准的性能调优。此外,针对云存储环境中常见的性能瓶颈,未来将引入批量删除操作,减少文件删除请求次数,提升云端数据管理效率。同时,Kafka Connect连接器即将发布至Confluent Hub,降低流数据接入门槛,拓宽Iceberg应用场景。Python生态也在同步推进,REST Catalog规范的Python封装和依赖优化提升了用户体验,使数据工程师能够更加便捷地管理和操作Iceberg表。 云环境下的性能优化同样备受关注。

集成S3 Analytics Accelerator库的规划,旨在提升对象存储读取效率和内存利用率,显著降低成本并加快分析速度。安全治理方面也在积极进展当中,结合外部身份认证与角色管理工具,实现统一权限管理和审计,保障企业数据资产安全合规。 综合来看,Apache Iceberg 1.10.0的发布,标志着开源湖仓生态迎来了成熟的关键阶段。通过技术创新,Iceberg不仅实现了更高效的数据存储与查询,更加强了数据治理、透明度和灵活演进能力,多维度满足现代企业数据湖管理的核心诉求。这使得数据湖能够像传统数据仓库一样,甚至更胜一筹地支持复杂分析、实时计算和合规运营,消除了供应商锁定,降低了总拥有成本。 展望未来,Iceberg社区持续专注于性能优化、生态整合以及企业级功能完善,不断推动湖仓平台向更智能化、更开放和更具适应性的方向演进。

无论是实时流处理、机器学习模型训练,还是海量合规数据管理,Iceberg都已具备成为理想底座的实力。 对于希望构建现代分析和AI工作负载的团队来说,深入理解和应用Apache Iceberg 1.10.0带来的变革,意味着能够更好地驾驭不断增长和变化的数据资产,实现数据价值的最大化。通过持续探索和参与生态建设,用户不仅能获得先进技术支持,还能引领开源数据湖仓发展趋势,赢得未来数据竞争的主动权。如今正是拥抱Iceberg 1.10.0、开启高效智能湖仓之路的最佳时机。 。