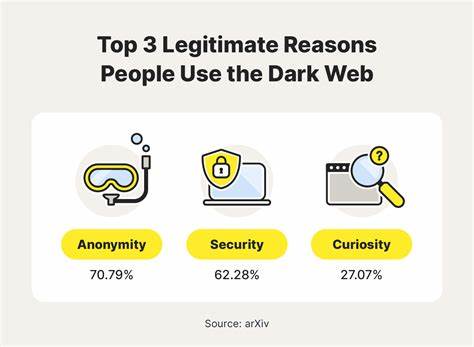

随着人工智能技术的迅猛发展,开源模型为科研和工业界带来了极大的便利和创新动力。然而,正当这些技术推动社会进步时,暗网中的某些势力也开始滥用这些合法的开源AI模型,用于隐藏身份、绕过安全机制,甚至执行非法任务。这种现象不仅威胁网络安全,也引发了社会伦理和法律的广泛关注。暗网,作为互联网的隐秘角落,其匿名性和难以监管的特点,使其成为非法活动的温床。近年来,随着开源AI模型的广泛传播,一些不法分子开始利用这些技术开发自动化的攻击工具,包括恶意软件传播、钓鱼邮件生成、自动化诈骗以及身份伪装等。利用开源模型的开放性和高效性,他们能够快速构建功能强大的AI服务,隐藏真实身份并躲避传统的安全防护监测。

开源人工智能模型通常具有极强的语言理解、图像识别和自动生成能力。尽管这些特性本应服务于正当用途,如教育、医疗和企业服务,但暗网平台通过定制化训练和二次开发,将这些模型变成了网络犯罪的帮凶。例如,利用生成式AI模型自动编写钓鱼邮件不仅大幅度提升了攻击的规模和成功率,同时使防御方难以依赖传统模式判断邮件的真实性。更加令人担忧的是,部分暗网运营者还将开源的深度学习模型转用于生成深度伪造视频和音频,制造虚假信息甚至进而影响公共舆论。这种技术滥用不仅损害个体隐私,还能在更大范围引发社会信任危机。从技术层面看,开源模型的滥用还加速了恶意算法的发展。

暗网中的AI服务提供者往往改进模型架构,使其适应非法用途。比如,通过优化生成模型使黑客工具更智能、更隐蔽,增强其攻击手段的多样性和复杂性。这一趋势对传统网络安全防护提出了更高挑战。与此同时,相关法律法规尚未完全覆盖AI技术在网络犯罪中的应用,监管力度相对滞后。暗网的匿名属性和技术壁垒使执法部门难以追踪和打击这些违法行为,造成恶意AI服务“有法难依”。为应对这一问题,多方面合作势在必行。

技术研发者应加强对开源模型的安全设计,在发布时加入滥用防范机制,提升模型的呼叫监控和访问权限管理。互联网安全厂商和执法机构则需要进一步构建AI驱动的防御体系,实时监控和识别异常行为,打击基于AI的网络犯罪。此外,全球性的法律框架协调亦不可忽视。跨国合作、信息共享以及制定针对AI滥用的专门法规将为治理开源AI模型被恶意利用提供坚实基础。值得注意的是,公众意识的提升同样关键。用户需了解AI技术所带来的潜在风险和防范知识,避免成为网络犯罪的受害者。

教育机构、媒体和相关组织应共同推动科技伦理的普及,倡导负责任的AI使用文化。未来,开源人工智能模型的发展不可逆转,其潜能巨大,既能推动社会创新,也可能被滥用成祸。关键在于技术社区、监管机构和社会公众共同协作,建立完善的技术防线和法律保障,创造一个安全、可信赖的数字环境。只有如此,我们才能最大限度地发挥开源AI的积极效应,避免其成为暗网犯罪的工具,从而维护网络空间的健康发展和社会秩序的稳定。