站点可靠性工程(SRE)作为保障大规模分布式系统稳定运行的关键角色,一直以来都是现代互联网架构的基石。在传统IT环境中,SRE主要通过一系列明确的指标,如可用性、延迟、错误率和容量利用率,来量化和维护系统的可靠性。然而,随着人工智能特别是大语言模型(LLM)的崛起,SRE领域正迎来一场从技术方法到思维模式的深刻变革。作为SRE2.0的核心动力,掌握并理解LLM的评估指标不再是可选项,而是推动未来稳定和高效服务交付的必要条件。 当前,大语言模型在搜索引擎、智能客服、内容生成、自动翻译以及代码辅助等多领域的广泛应用,正在彻底重塑用户与服务交互的方式。LLM的输出质量直接影响用户体验和业务价值,但其生成结果的复杂性和多样性使得传统的SRE指标体系难以直接套用。

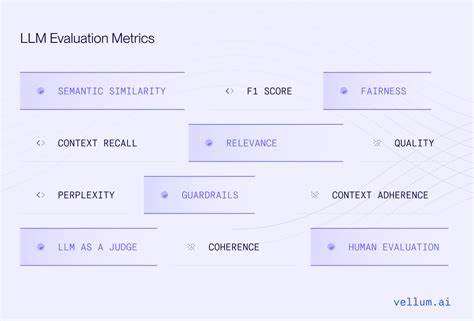

面对这种情况,SRE团队必须学会评估模型的准确性、相关性、一致性和公平性,甚至包括道德伦理和安全风险等维度。只有这样,才能确保系统不仅稳定运行,而且能够持续提供高质量的智能服务。 从技术视角来看,LLM评估指标涵盖了多样化的性能标准。准确率和反馈一致性是衡量模型回答正确性的关键,而鲁棒性指标则评估模型对异常输入的适应能力。此外,响应速度和资源消耗同样是SRE关心的重点,因为模型的运行效率直接关联到系统可扩展性和成本管理。通过综合分析这些指标,SRE可以更精细地调优系统架构,优化负载分配和故障恢复策略,进而提升整体服务的可靠性和稳定性。

此外,LLM的不断迭代更新对SRE提出了更高的动态管理要求。模型的版本升级、数据更新及调优参数的变化都可能导致系统行为产生不可预见的偏差。SRE团队需要部署一套实时监控和反馈机制,及时捕捉模型输出的异常和偏差,确保能够快速响应和定位问题,避免潜在的服务中断或用户投诉。这种能力的建立,既是对传统SRE工作的延伸,也是对智能化系统管理思维的创新。 在企业层面,系统可靠性已经不再仅限于技术稳定,更涵盖了智能服务的信任与合规。随着法规和社会责任意识的提升,LLM生成内容的可控性和合规性也成为SRE关心的重要因素。

合规监控功能的引入,帮助企业规避法律风险,保障用户数据和隐私安全,同时促进模型行为的透明化和可审计性。这些工作需要技术团队和管理层密切合作,形成合力,从而确保智能系统在快速发展中始终保持良性循环。 结合行业趋势与实践经验,SRE2.0的核心竞争力正在逐渐转向对大语言模型全生命周期的深入理解和精准掌控。无论是模型的设计部署,还是运行维护和长期优化,都离不开对LLM评估框架的有效运用。通过引入先进的指标体系,SRE可以不仅提升系统的鲁棒性,还能够推动业务创新和用户体验的提升,实现技术可靠性与智能服务的完美融合。 展望未来,随着更多智能技术和自动化工具的出现,SRE面临的复杂度势必增强。

只有拥抱变化,主动学习并掌握大语言模型的评估方法,SRE团队才能在激烈的市场竞争中保持领先地位。同时,这也为整个行业注入了新的活力和发展空间,推动信息技术与人工智能融合迈向更高水平。 总而言之,SRE2.0时代到了,拒绝对大语言模型评估的忽视是不明智的。深入理解并应用LLM指标体系,是保障系统持续健康发展的基石,也是未来智能服务能否真正落地的重要保障。SRE专业人员应当积极拥抱这场变革,提升自身能力,携手打造更加智能、可靠和高效的数字世界。