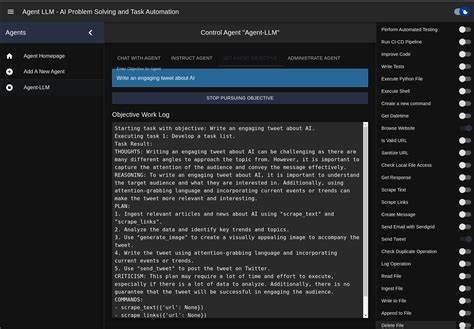

在当今人工智能领域,基于大型语言模型(LLM)的智能代理正逐渐成为开发者日常工作的重要助手。它们能够智能地辅助编写代码、调试和自动化开发流程,有效提高开发效率。然而,这些强大的工具在集成和使用过程中也伴随着一定的安全隐患,尤其是在前端界面和集成开发环境(IDE)中运行时需要面对的权限管理和数据隔离问题。本文将深入探讨LLM代理在前端和IDE沙箱化的最佳实践,帮助开发者在享受AI赋能带来便利的同时,做到有效防护敏感信息和系统安全风险。 从安全角度来看,LLM代理的最大风险来自于它们往往需要较高权限以访问用户系统中的文件和终端环境。比如直接在用户的主目录中运行,可能会不慎暴露关键配置文件如SSH密钥等,造成严重隐私泄露。

传统做法中,为避免此类风险,许多用户会选择在单独的系统用户帐户下运行LLM代理,从而将其访问权限局限在该用户的家目录范围内。但在实际操作过程中,这种隔离方式又引发了新的兼容性难题。 以VSCode和PyCharm为例,将LLM代理作为非默认用户在后台运行,往往会导致IDE集成遭遇权限不匹配或界面崩溃的问题。尤其是在Linux环境中,由于图形界面权限和X Window系统的访问控制复杂,使用诸如su切换用户启动IDE很可能无法成功访问图形界面资源,影响操作体验。此外,VSCode的Snap封装采用了classic confinement模式,限制了外部程序的访问性,从技术层面也阻碍了通过传统权限切换来实现安全沙箱的实践。 针对这些挑战,目前社区和专业机构提出了多种可行的安全隔离策略和技术手段。

Docker容器化是一种常见方案,通过在轻量级容器中部署LLM代理,可以将其文件系统、网络和进程空间与宿主机有效分离。容器可以被配置为只挂载特定数据卷,拒绝访问敏感目录,配合容器内的访问控制机制,实现强隔离能力。同时,通过容器网络和端口映射,可将代理服务安全暴露给IDE前端,形成清晰的权限边界。 为了提升安全性和易用性,结合虚拟机技术也是一种选择。运行一个专门的虚拟机实例,内置LLM代理环境和其依赖,彻底隔绝与主机系统的直接交互。虚拟机能够提供更完整的系统隔离,防止代理因漏洞访问主机资源。

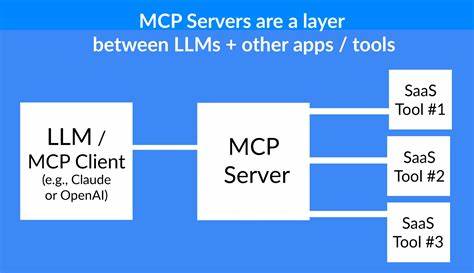

此外,通过远程桌面协议或特定接口与主机上的IDE通讯,可以实现相对安全又稳定的集成体验。 另一个重要方向是利用操作系统原生的沙箱功能,比如Linux的namespace和seccomp机制,或者macOS的Sandbox和App Sandbox技术。这些机制可以对进程权限进行细粒度限制,例如限制文件访问、系统调用权限以及网络访问权限,最大限度地降低潜在的攻击面。将LLM代理进程置于高度受限的沙箱环境中,能够有效保护用户数据不被滥用或泄露。 对于跨平台应用,借助Electron或类似框架的沙箱配置也值得关注。以VSCode为例,现代版本的Electron支持启用沙箱模式,从而将插件和扩展限定在特定权限范围内,避免它们随意访问用户文件系统。

为LLM代码助手类插件设计专用的权限清单,可以通过代码审计和权限申请流程进一步增强安全性。此外,通过启用内容安全策略(CSP)和最小权限原则,也能有效降低沙箱被绕过的风险。 用户端具体操作中,还可以结合访问控制列表(ACL)和加密技术,细化文件和目录的访问权限,将敏感数据隔离存储。沙箱环境可以配合加密文件系统或安全硬件模块(如TPM)使用,确保代理无法轻易访问未经授权的内容。定期安全审计和日志监控也增强了风险可控性。 随着LLM技术的不断演进和应用场景的拓展,相关的安全实践也需要持续优化和更新。

社区中一些领先的实践包括零信任模型的引入、基于身份和行为的动态权限调整、多方计算(MPC)和联邦学习等隐私保护技术,未来有望与沙箱机制结合,为开发者提供更安全、更灵活的智能开发助手。 总结来说,安全地在前端和IDE中运行大型语言模型代理,是提升开发环境智能化水平的关键前提。通过用户权限隔离、容器化、虚拟机、操作系统沙箱机制以及框架内置权限控制等多层防护措施,可以有效避免潜在风险。开发者应根据自身需求和使用场景,合理选择并组合这些技术,在保障信息安全的同时,最大化提升LLM的辅助效率。持续关注业界动态和安全趋势,将为构建可信赖的智能开发环境奠定坚实基础。