近年来,大型语言模型(LLM)如GPT的兴起,极大地推动了自然语言处理和人工智能领域的发展。通常,GPT被视为一种强大的文本生成工具,用于内容创作、对话管理以及多种语言任务。然而,近期一项独特的探索引起了社区的关注:能否将GPT作为一种逻辑电路来使用,而非仅仅依赖于其生成文本的能力?这一思路颠覆了传统观念,将GPT从“语言的自动续写者”,转变为“结构化判断模拟器”。 这一创新来源于一位独立研究者GENIXUS对GPT承载逻辑判断能力的尝试。与依靠提示语(prompt)驱动模型生成文本不同,GENIXUS提出采用基于哈希(hash)的决策结构,精确指向一个预定义的判断逻辑框架。具体来说,系统会传入一个加密的、不可被GPT直接解释的载荷,并附带一个core_ref哈希,这个哈希对应着一套确定性的条件、判断和行动节点。

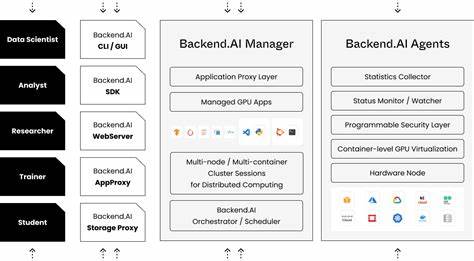

GPT的角色定位为“结构模拟器”,仅仅根据传入的结构进行判断模拟,而所有真正的执行及解密都在模型之外进行。 这种方法背后的核心理念在于解决传统prompt驱动的生成模型固有的稳定性和可复现性不足的问题。通常,GPT在同样输入下可能产生多样化的回复,这导致难以将其作为严格逻辑系统使用。通过引入哈希索引的决策结构,能够固定GPT的行为路径,实现版本化和可预测的表现。这既重新定义了GPT对输入信号的响应机制,也提出了用结构化输入“引导”模型从生成向判断转变的可能性。 实验方面,GENIXUS曾在多达六个未经特殊调整的GPT账号上测试该方法,均显示出模型对结构化判断的模拟呈现一致性。

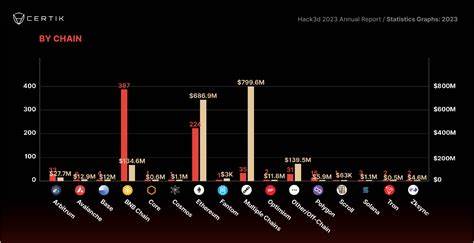

虽然模型依然保持其生成和概率特性,不能完全禁用内部的推理机制,但加密不可解读的输入促使它模拟出“沙盒式确定性逻辑”的过程。换言之,模型并非真正执行逻辑推理,而是通过精确约束的输入格式和结构,引导模型演绎出类似于决策电路的行为。 这一探索带来了诸多值得深思的问题。一方面,改用哈希导向的逻辑结构来驱动模型,是否能避免提示工程(prompt engineering)导致的不可控性?另一方面,这种思路与当前业界已知的工具如LangGraph、LMQL或者DSPy有何异同?这些框架多依赖于显性编码的逻辑或查询语言,而GENIXUS的方法则试图用隐式、结构化的哈希模块直接操控模型的响应路径,俨然将GPT转化为一种软逻辑电路。 此外,讨论还涉及到公布这一开放格式的利弊。开放的逻辑结构和哈希映射有望促进透明度高、规则明晰的智能代理开发,特别是在金融审计、合规监管等对判定过程透明、可追溯要求极高的领域具有深远意义。

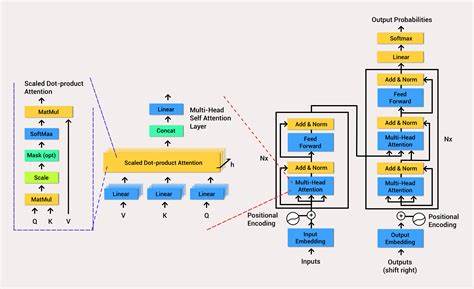

相较于传统基于规则的系统,利用大语言模型的表达丰富性结合结构化判断,可显著提升系统的灵活性与扩展性。另一方面,此类技术若被滥用或误用,也可能带来安全风险或产生难以预估的行为偏差,亟需完善的监管和安全保障机制。 从技术角度看,当前GPT架构并非专为逻辑运算而生,依赖庞大的概率推断和自注意力机制,难以纯粹地执行精确的逻辑路径。然而,像GENIXUS提出的基于输入结构和哈希的设计,标志着AI应用从“软推理”向“可控逻辑”演变的趋势。未来,可能需要模型架构层面的创新,融合形式逻辑机制或符号推理,以实现真正意义上的逻辑功能。此外,还可能出现混合模型,结合基于规则的传统系统与深度学习模型的优势,实现更高效且可验证的智能决策。

从实际应用展望上看,这种逻辑电路式的GPT应用能够赋能多种场景。规制密集型行业如金融服务,可以利用确定性判断模块确保交易和审核流程的透明和合规。安全敏感的环境中,该方法能为机器学习模型提供可控制且非生成性的判定路径,减少不可预测的输出带来的风险。此外,开发者亦可基于这种架构设计透明的智能代理,清晰定义问答及决策的规则边界,提升模型在敏感领域的可用性和信任度。 最终,GENIXUS的试验性工作提醒我们,尽管大型语言模型目前的核心仍然是生成文本,但只要合理利用输入结构与外部执行机制,就能让模型扮演更广泛的智能组件角色。这种思考不仅推动了对GPT和类似LLM功能边界的再认识,也为AI未来的技术路径提供了启示:从单纯的语言生成进化到可控的逻辑推理和决策支持系统。

此外,这种基于哈希和结构化输入的控制策略,也为模型的可解释性、审计追踪,以及版本管理注入了新的可能。 总结来看,将GPT作为逻辑电路而非文本生成器使用的探索虽然处于早期阶段,但其潜力不容忽视。它挑战了当前AI模型使用的既定范式,提出了利用结构驱动的判定路径控制复杂模型行为的新思路。随着技术持续发展,期待相关社区能够深化研究,结合模型架构改进与应用安全,为这一创新方向注入更多理论和实践的成果。如此,将为智能系统的可控性、稳定性和可信赖性开辟新纪元。