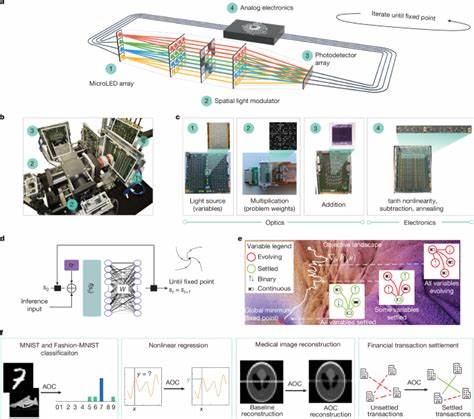

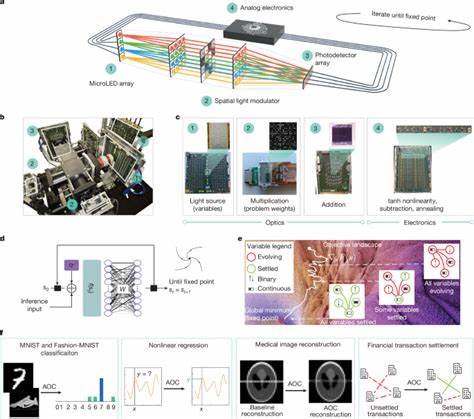

随着人工智能技术和复杂组合优化问题的快速发展,计算需求也持续攀升,传统的数字计算架构已面临能效和性能的双重挑战。为满足未来大规模智能计算的需求,科学家们开始探索新型计算范式,其中模拟光学计算机作为一类结合光学与模拟电子技术的创新平台,展现出巨大潜力。这种计算机通过快速而高效的固定点迭代方法,无需耗能高的数字转换,即可实现复杂神经网络推理和多变量组合优化的高速度与低能耗处理。模拟光学计算机的出现,为人工智能推理和优化问题的技术突破打开了新的大门。传统数字计算机以二进制逻辑处理信息,虽然成熟且广泛应用,但在AI推理和大规模优化任务中经常受到内存瓶颈和数字-模拟转换带来的额外能耗限制。模拟光学计算机通过将计算操作直接映射到物理光场和模拟电压信号,实现了并行且低延迟的计算过程。

其中,光学部分负责大规模矩阵乘法运算,这是深度学习和优化计算的核心;而模拟电子部分负责非线性激活、加减法及annealing等控制,保证计算的动态收敛和噪声抑制。该架构利用三维光学系统进行微型LED阵列发光,结合空间光调制器实现权重编码,进而通过光探测器阵列读取结果。这种光电子交替的反馈机制使得系统能够快速逼近目标问题的固定点,从而实现神经网络推断或组合优化的高效解算。模拟光学计算机的核心优势在于其固有的噪声耐受性和无须数字转换带来的能效提升。固定点迭代方法能够像吸引子一样稳定驱动状态逼近最优解,即使在模拟硬件中的信号不完美情况下,亦能实现高质量的计算结果。此外,光学矩阵乘法的物理并行性大大超过传统电子计算,令其在处理大规模神经网络时表现出卓越的效率和速度。

该技术尤其适合计算密集且迭代深度可变的平衡模型与能量基模型,这类模型因其动态推理能力和良好的泛化性逐渐成为AI领域的重要研究方向。模拟光学计算机不仅加速了这些模型的推断过程,同时因其独特的硬件设计,支持混合离散连续变量的广义组合优化问题。传统组合优化受限于二值化问题建模,表达力有限且转换开销大。模拟光学计算机能够直接处理混合型变量,通过灵活的目标函数映射,解决医疗图像重建、金融交易结算等复杂实际场景中的约束优化难题。具体来说,通过分块坐标下降策略,较大规模的优化问题被分解成适合当前硬件处理的小规模子问题,函数目标则由光学矩阵乘法和模拟非线性模块共同执行。如此,模拟光学计算机在医疗成像领域能够实现稀疏恢复与加速磁共振成像,提升图像重建质量和速度。

金融领域则借助该技术优化交易结算流程,最大化结算数量并满足各种法律与信用限制。为确保实验硬件的操作精度与算法的可靠性,研究团队开发了数字孪生系统。该系统模拟硬件设备中的各种非理想因素,包括光学路径误差、电路增益变异及噪声等,通过数字训练回传完成神经网络权重的学习,再将结果映射至硬件推断。数字孪生技术的精度达到99%之上,为硬件演示的成功提供了理论和实践保障。实验结果表明,当前实验平台支持上千个权重的平衡模型推理,处理手写数字和非线性回归任务,准确率与传统数字算法媲美。时间复用技术进一步扩展了可支持的参数规模,实现4096权重的神经网络推断。

优化任务方面,硬件成功解决数十变量的混合二进制/连续变量问题,满足医疗与金融两个工业场景的实际需求。在效率层面,模拟光学计算机预计可达到每瓦500万亿次操作的能效,比目前最先进的GPU快百倍以上,这在应对未来千亿甚至百亿参数神经网络时尤为关键。未来架构设计将采用模块化3D光电子集成,通过多个微光源与空间调制模组分片完成超大规模矩阵乘法计算,配合高速模拟电子控流保持系统收敛性与噪声抑制能力。该设计极大突破二维芯片面积限制,实现了在有限尺寸下的海量权重存储和运算。微发光二极管无需相干光源,降低制造难度并增强系统稳定性,进一步推动技术产业化进程。模拟光学计算机是计算硬件与机器学习模型共设计的典范。

与数字加速器与深度学习模型的共演化类似,硬件迭代为算法提供新的计算基元和表达形式,促使更先进更复杂的AI与优化模型诞生。固定点迭代的抽象同时兼容平衡模型与混合变量优化,打破传统数字与模拟计算间的壁垒,推进计算范式多元化发展。总的来说,模拟光学计算机已展现了改变AI推理和组合优化计算形态的巨大潜力。它通过光与模拟电子混合技术的巧妙融合,在能效、速度与噪声容忍度等关键指标上实现革命性突破。随着硬件的持续完善和规模化扩展,模拟光学计算机有望成为未来智能系统和工业应用的关键计算引擎,推动人工智能和复杂优化领域迈向高效、可持续的新纪元。 。