随着人工智能技术的迅猛发展,尤其是大型语言模型(LLM)的广泛应用,企业内部支持体系的数字化转型成为提升效率和客户满意度的关键。尽管LLM能够展现出强大的自然语言处理能力,但它们本身无法直接访问企业敏感的内部信息,这就限制了其在具体业务场景中的应用价值。为了解决这一瓶颈,检索增强生成(Retrieval-Augmented Generation,简称RAG)技术应运而生。RAG通过将LLM与向量数据库结合,能够实时检索存储在数据库中的企业专属知识库,从而为用户提供更加精准、上下文相关的答案。 YugabyteDB作为一款兼容PostgreSQL的分布式数据库,最新版本引入了强大的向量存储和检索功能。这使其不仅可以作为传统的事务型数据库使用,还能充当企业内部支持知识的向量数据库平台。

利用YugabyteDB的分布式架构,企业能够实现海量支持数据的快速索引和检索,保障系统的高可用性和低延迟,这对于支持团队的实时响应尤为关键。 构建一个基于RAG的支持系统,首先需要将企业历史遗留的各种支持文档进行向量化处理。这些数据可能包括邮件、Slack工作区的聊天记录、Jira问题单、Zendesk客服工单以及GitHub PR和Issue等。通过将文本转换成高维向量,能捕捉信息的语义特征,为后续的相似度检索提供基础。YugabyteDB的向量扩展支持1536维的向量存储,满足现有主流的开源和商用嵌入模型生成的向量维度要求。 部署过程中,用户需要先在本地或云端搭建YugabyteDB数据库实例,并启用向量扩展功能。

之后,通过自定义的Python脚本完成数据的读取与向量化,并将结果存入向量表中。该过程自动化程度较高,便于定期同步最新的支持文档,确保知识库的实时更新。 在应用层,基于GPT-4等先进LLM的问答系统能够结合从向量数据库检索到的相关上下文片段,生成针对性回答。即使用户的问题涉及复杂的企业内部流程或具体工单细节,系统也能提供有理有据的回复,极大提升支持工作的准确性和效率。对比没有上下文支持的基础模型回答,RAG增强后的答案更贴合实际需求,减少了信息的模糊性和误导风险。 对于不同职能部门,RAG技术带来的支持体验提升尤为显著。

研发工程师可以迅速获取关于特定功能延迟原因的详细信息,运维人员可以查询最近的部署故障记录,客服团队能够即时获得客户历史问题处理情况。此外,新员工的入职培训和团队知识传承也能借助智能问答系统变得更加顺畅,无需人工反复查阅分散的文档。 从技术架构角度看,YugabyteDB的分布式SQL特性保障了系统的可扩展性和弹性扩容能力。无论企业支持数据量如何增长,系统都能平滑应对,避免查询瓶颈和单点故障。此外,向量索引采用了高效的近邻搜索算法,支持低延时的语义搜索,进一步提升了用户体验。企业还可以按照自身需求,为向量数据添加丰富的元数据标签,加强检索的精准度和分类管理。

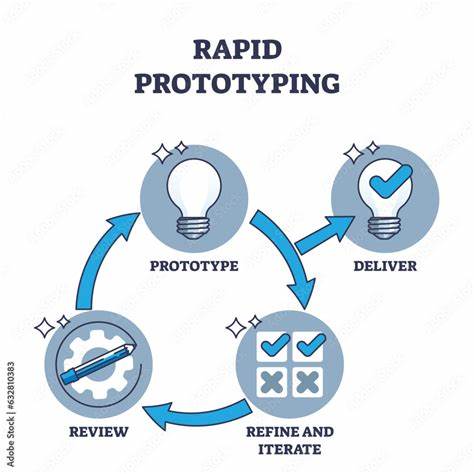

安全性方面,YugabyteDB支持端到端加密和访问控制,确保内部知识数据免受未授权访问。结合本地部署或私有云环境,可以满足严格的合规要求,保护企业核心机密信息。此外,结合本地LLM推理服务,如Ollama,可实现关键数据不离开企业防火墙的自主智能服务,进一步增强数据隐私保护。 实践中,要打造一个高效且实用的RAG支持系统,需要持续进行多阶段迭代。首先,建立完善的数据采集管道,确保从各类支持工具流水线中提取最新内容,进行向量化处理。其次,设置定时任务周期性刷新向量库,使知识库始终保持最新状态。

然后,深化上下文挖掘能力,通过更细粒度的文档分块和丰富的标签体系,提升语义匹配的精度。最后,将系统集成至现有的支持流程或即时通讯工具中,实现智能提醒和交互式查询,推动自动化和协同办公的最佳实践。 随着企业对智能支持系统需求不断增长,RAG技术与YugabyteDB的结合展现出极大的潜力。由此,企业不仅能够节省人工检索和沟通的时间成本,还能借助AI赋能深化洞察,发现隐藏的业务风险及改进空间。在信息爆炸的时代背景下,拥有一个“知道你支持体系”的AI助手成为提升竞争力的关键利器。 总的来说,从基础架构建设到数据处理,再到智能交互,采用YugabyteDB构建的RAG支持系统架构完整,性能优越,安全可靠,能够为不同规模和行业的企业提供强有力的知识支持解决方案。

未来,随着向量搜索和自然语言理解技术的不断演进,RAG系统将更深入融入企业数字化生态,带来工作方式的革命性变革。值得所有重视内部知识管理与支持服务的组织加速着手搭建并不断完善自己的RAG智能体系,让企业宝贵的历史经验和隐性知识变成看得见、用得上的生产力。