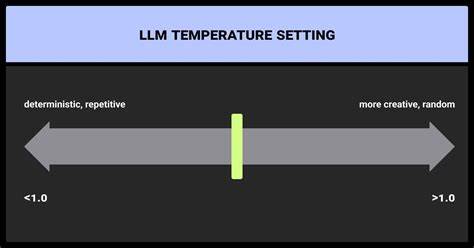

随着人工智能技术的快速发展,大型语言模型(LLM)正成为众多应用场景中的核心驱动力。这些模型通过理解和生成自然语言,实现了翻译、问答、写作辅助等多种功能。然而,模型生成内容的随机性与多样性常常受到温度参数的影响,而如何有效设定这一参数成为优化模型表现的关键。传统上,用户只能通过外部设定固定的温度值来调整输出的随机程度,但这一方法往往难以满足不同任务的多样需求。近期,一个名为“ThermoAsk”的创新思路提出,让模型自身具备根据任务需求调整温度的能力,不仅突破了固定参数的限制,也为智能文本生成开辟了全新路径。大型语言模型中的温度参数本质上控制着模型输出的概率分布形态。

温度数值越低,模型越趋向于进行确定性选择,输出结果更集中且重复性高;反之,温度越高,模型倾向于更多样化且随机性的生成。如何在不同任务场景下找到适宜的温度,决定了生成内容的质量与实用性。例如,在需要精准数学计算或代码生成的场景中,较低温度更有利于确保结果的准确性;而在创意写作或生成随机数时,较高甚至趋近于正无穷的温度能营造更均匀且多样的输出。微软的Phi-2模型作为一个案例,展示了在温度设为1.0时,其产生的随机整数分布并非均匀,部分整数被过度偏好,而将温度推向正无穷后,输出分布趋于均匀,从而实现了理想的随机数生成效果。尽管如此,大多数用户并不熟知温度调节的深层原理,更不用说进行动态调整。为解决这一难题,ThermoAsk方法提出通过一个辅助语言模型来分析任务和提示内容,自动推荐最合适的温度值,甚至让模型在生成过程中自主调用该工具,依据内容需求灵活调整温度。

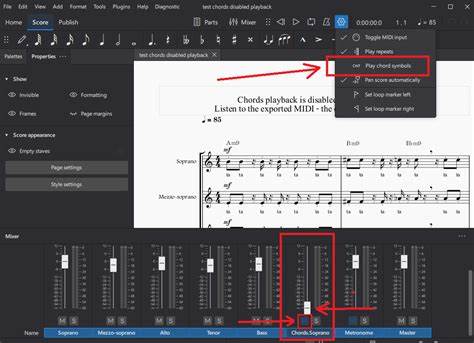

这种动态调节不仅提升了生成文本的匹配度,还避免了人为参数设置的繁琐与盲目。当模型面对复杂、多步骤的任务时,例如先计算数学表达式再创作包含答案的抽象诗歌,ThermoAsk的作用尤为突出。模型可以先使用低温度准确完成计算过程,随后切换至高温度发挥创造力,产出丰富多彩的诗歌内容。通过这种温度分阶段调节,模型兼顾了准确性与创新性,极大提升了用户体验和文本生成的多样化水平。在实际应用中,ThermoAsk的实现依赖于工具调用机制及模型API的支持,诸如Ollama的Python SDK和支持工具调用的Qwen2.5-7B模型为这一新技术提供了可靠平台。用户可通过预定义提示指导模型自动判断和调整温度,无需人工干预即可获得最优化输出。

这种突破性技术还拥有广泛应用前景。它不仅能提升智能客服、自动文案生成、程序代码辅助等多领域的表现,还能助力学术研究中对复杂任务的自动化处理。随着更多高性能黑盒模型的加入,如何采样和近似温度分布将成为新挑战,而ThermoAsk为应对这种挑战提供了宝贵思路。此外,ThermoAsk作为一种自适应参数选择机制,引发了对更广泛模型调节手段的思考。未来,有望涌现更多模型可自主管理自身生成控制参数的创新,为用户提供更智能、更灵活的交互体验。结合当前的技术趋势,开发出可动态调节多维度参数的语言模型,将极大促进人工智能的实用性和多样性发展。

在这一背景下,对于研究人员和开发者而言,深入理解温度的数学原理及其对模型软最大化(softmax)函数的影响尤为重要。温度提升时,模型 logits 之间的差异被压缩,导致输出概率趋于均匀分布;相反,温度降低则放大了 logits 差异,使得模型生成更为确定性的结果。通过调节温度,模型能够在确定性和随机性间灵活切换,这恰恰满足了多样场景的需求。总结而言,温度参数作为控制大型语言模型输出随机性和多样性的重要杠杆,其动态调节能力必将成为提升模型生成品质的关键。ThermoAsk这一创新思路展示了模型自主调整温度的巨大潜力,打破了传统固定参数的束缚,使人工智能文本生成更为智能化和人性化。随着技术不断成熟与普及,这种自主调节机制将推动更多高质量、个性化的智能应用登场,为用户带来全新的交互与内容体验。

拥抱自主温度调节的大型语言模型时代,正是人工智能迈向更高水平的又一重要里程碑。