在人工智能尤其是自然语言处理领域,Transformer架构因其强大的序列建模能力而成为主流。尽管其在语言理解、生成等任务中表现出色,但由于计算和内存资源的平方级增长,处理长序列时面临严重的性能瓶颈。为此,研究者们不断寻求改良方案,期望在长上下文环境中依然保持高效精准的理解和记忆能力。ATLAS作为近期提出的一种创新记忆模块,正是在这一背景下诞生,旨在通过全新的记忆机制,实现对上下文信息的最佳记忆和利用,从而在语言模型及其他复杂任务中取得突破性进展。传统Transformer的瓶颈主要体现在其内存与计算需求与输入序列长度的平方成正比。这种设计虽能捕获序列内大量细节,但极大限制了模型处理超长文本的能力。

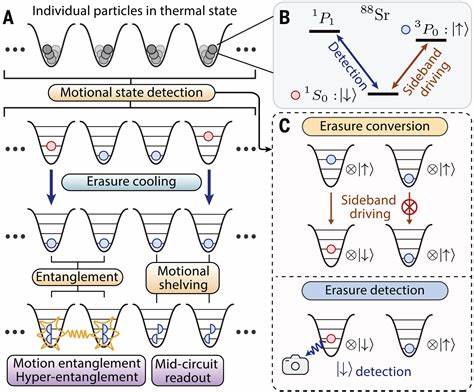

为应对这一问题,长期以来研究者尝试引入循环神经网络和其他结构以便更好地编码长距离依赖。然而,尽管现代循环网络引入了长时记忆模块,这些模型依旧难以在长上下文任务中展现理想性能,其核心原因在于记忆容量受限、在线更新机制单一以及固定大小记忆管理缺乏灵活性。正是基于对这三方面缺陷的深入分析,ATLAS提出了一种高容量、可优化的长时记忆模块,突破传统在线更新的限制,不仅考虑当前输入,还综合利用过去输入信息,实现更为精准的记忆更新。同时,ATLAS基于这一记忆模块发展出DeepTransformers架构体系,实现了对原始Transformer的严格泛化。ATLAS的记忆机制核心在于其对上下文的整体优化能力,它不仅保存更多的上下文信息,还能通过复杂的优化策略调整记忆内容,使得记忆更具表现力和适应性。这一创新使得模型能够更有效地捕获长距离依赖,并在需要细致理解和推理的任务中表现卓越。

在实际应用层面,ATLAS在语言建模、常识推理、回忆密集和长上下文理解等多项任务中均展现了显著优势。其在BABILong基准测试中处理长达千万级上下文长度时准确率提升超过80%,这一成绩极大地推动了长文本处理能力的边界。ATLAS不仅限于学术研究,其技术潜力和应用价值吸引了自然语言处理、知识图谱以及复杂推理领域的广泛关注。随着信息爆炸时代文本长度和复杂性的不断增加,传统模型难以胜任,而ATLAS为解决此类问题提供了切实可行的路径。DeepTransformers架构作为ATLAS的衍生,将Transformer的灵活性与ATLAS记忆模块的优化能力融合,为未来基于Transformer的模型设计开辟了新方向。有望推动更多具备高效长时记忆管理的架构诞生,进而促进人工智能在文本理解、语义挖掘及对话系统中的突破。

总的来看,ATLAS通过对长期记忆模块的重新设计和优化,突破了传统模型处理长序列的瓶颈,展现出卓越的上下文理解与记忆能力。这不仅为语言模型领域带来新的思路,也为广泛依赖长上下文信息的AI系统提供了强有力的支持。未来,随着算法的不断完善和计算能力的提升,ATLAS和其继承架构将在多种实际应用场景中发挥更大作用,推动自然语言处理及人工智能技术向前迈进。