随着人工智能和深度学习技术的快速发展,训练大型神经网络模型对硬件资源的需求也日益增长。尤其是在内存消耗方面,传统神经网络训练由于要保存大量中间激活值和权重参数,导致显存占用急剧膨胀,成为限制模型规模和复杂度的重要瓶颈。基于此,研究者提出了基于可逆架构的O(1)内存神经网络训练方法,以解决内存使用的巨大挑战。这一技术不仅在理论上极具创新性,也为实际应用带来了广阔的前景。O(1)内存训练的核心目标是在神经网络的前向和反向传播过程中,实现固定常数级别的内存使用,无论模型如何扩大,这种方法都能保持内存资源的恒定消耗。传统的神经网络训练方法需要存储前向传播过程中产生的所有激活值,以便反向传播时使用,这就导致内存需求随模型深度和宽度线性增长。

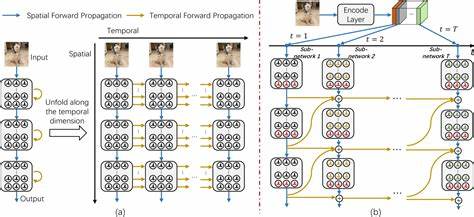

而可逆架构则利用网络结构的特殊设计,通过反向计算前向激活,避免了在前向传播中保存所有中间激活,从而显著减少内存占用。可逆神经网络的设计理念源于经典的可逆计算理论,其关键在于网络中的每一层不仅能够完成特征的前向转换,还能通过已知的输出逆向推导输入。这一过程依赖于数学上的可逆函数设计和分层结构,使得在反向传播阶段无需保存大量中间数据,就能通过少量信息恢复所需状态。通过这种机制,训练过程中激活值的存储需求从传统方法的O(n)降低至O(1)级别,大大缓解了内存压力。采用可逆架构进行神经网络训练,不仅提升了显存使用效率,还为更大规模模型的训练铺平道路。尤其在处理超深度或巨型神经网络时,这种方法可以使单块GPU或TPU能够加载和训练更复杂的模型,节约硬件成本并缩短训练周期。

此外,可逆架构训练还有助于提高能效比,对应的数据中心和云端计算资源利用率得到优化。探讨具体应用方面,可逆架构已经在多个领域显示出强大潜力。自然语言处理中的Transformer模型,通过引入可逆层,有助于训练超长文本模型而不显著增加内存负担。计算机视觉领域,利用可逆残差网络设计,有效提升图像识别和生成任务训练效率。科学计算和物理仿真等对精度和大规模计算需求高的领域,也受益于此类内存优优化技术。更进一步,O(1)内存训练方法结合梯度检查点技术和浮点数精度优化,能够在保持模型性能的同时,最大化资源使用效率。

这些技术的协同作用,推动了深度学习模型训练向着更节能、更绿色的方向发展,符合当前可持续发展的科技潮流。此外,从研发和工业角度看,推广可逆架构训练方案对软件框架和硬件设计提出新需求。深度学习框架需要支持灵活定义和调度可逆网络结构,实现高效的自动微分和内存回收;硬件设计则需优化对逆向计算的算力调度,降低数据搬运和延迟成本。长远来看,这些创新将激发整个AI生态系统的升级换代。面向未来,O(1)内存神经网络训练和可逆架构的结合预示着人工智能训练范式的变革。随着算法的不断完善和工程技术的成熟,未来有望实现更大规模、更复杂神经网络的高效训练,这将极大推动智能应用的商业化和普及化。

诸如自动驾驶、智能医疗、个性化推荐等领域将从中获得更强的模型支持和实时响应能力。同时,随着量子计算等新兴技术逐步融入,O(1)内存训练方法或许能够与这些前沿技术形成融合,开启智能计算的新纪元。总结而言,O(1)内存神经网络训练通过可逆架构的创新设计打破了传统训练过程中内存消耗的限制,为深度学习模型的可拓展性提供了强有力的技术支撑。尽管目前还存在计算复杂度和架构设计的挑战,持续的研究投入和技术迭代必将推动该领域走向成熟。对于希望在有限硬件资源上训练大规模深度模型的研究者和工程师而言,深入理解和应用可逆架构训练技术无疑是未来提升竞争力和创新能力的关键所在。