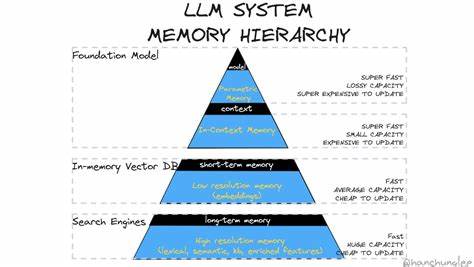

随着人工智能技术的飞速发展,大型语言模型(LLM)在自然语言处理领域的应用日益广泛。然而,随着模型能力的提升,记忆系统作为支撑这些智能体长时间、连贯思考的核心组件,其设计和实现的复杂性逐渐显现。记忆不再仅仅是简单的信息存储,而涉及如何系统地管理和检索知识,使模型能像人类一样“回忆”起过去的事件,保持上下文的一致性,并在多变的情形中灵活应用知识。文章围绕LLM记忆技术,逐步剖析不同方法的优劣及其内在逻辑,为理解智能时代的知识存储革命提供了独特视角。 记忆的核心挑战之一在于对时间和空间参考框架的管理。每条知识都存在其有效的参考范围,例如“柏林是德国的首都”这句看似简单的事实,放在历史语境中却存在多重版本。

冷战期间西德的首都是波恩,德国分裂前的不同区域首都则各异,甚至不同的虚构故事中该事实也会被改写。这种时间与空间的多维参考框架要求记忆系统不仅存储事实本身,还需附带相应的时空标签,从而避免产生冲突且能根据语境正确调取信息。空间参考框架也不止局限于地理意义,可以是层级结构、抽象分类或其他维度,将知识定位于特定的“坐标系”中。 向量嵌入技术,是近些年助力记忆查询和管理的热门工具。它通过将文本信息转换成高维向量,在向量空间中表示语义相似度,使得语义相关的内容能够被高效检索。简单来说,输入一句“我吃了个三明治”,系统能快速定位与之语义相近的记忆节点。

这种技术在信息检索中具有天然优势,但对于复杂的事件链和因果关系则显得捉襟见肘。尤其是涉及时间序列或连贯故事的“情节化”记忆,单纯依赖嵌入向量难以体现事件顺序和逻辑关联,这使得嵌入技术无法独立承担完整的记忆功能。 知识图谱的兴起给LLM记忆赋予了更具结构化的表达方式。通过将关键实体作为节点,实体间关系作为边,形成庞大的语义网络,使模型能够通过图的遍历理解事物之间的联系。例如,“柏林”节点与“德国”节点由“首都”关系相连,而“杰瑞·斯泰勒”与“本·斯泰勒”间存在“父子”关系。知识图谱不仅支持明确的语义边,而且能够通过连结上下文展示丰富的关联信息,有助于模型更精准的推理和查询。

然而,维护高质量、语义明确的边缘关系面临技术挑战,错误或模糊的连接可能带来混淆,再加上图谱规模的爆炸性增长,如何有效管理边的创建、遗忘与优化成为关键课题。 产生层级的元文档概念则捕捉了知识存储的动态演进。日常查询的结果不仅是即时返回答案,更可以生成包含推理和逻辑过程的“汇总文档”,这些文档本身组成了新的记忆节点,串联起原始资料。比如回答“我最喜欢的欧洲城市”后产生的列表文档,未来针对类似问题时能直接调用,极大提升响应速度和准确性。此类动态知识融合反映了人类记忆中对回忆本身的再回忆现象,使得记忆既是信息的积累,也是认知的再加工。 记忆存储并非完全自动的单向过程,在连接建立方面是否采取自动化或显式管理同样影响系统表现。

自动连接机制虽然效率高,但易产生无用甚至错误联结,加剧图谱复杂度;而显式管理需借助模型判断潜在连接的价值和应用场景,通过人工或人工智能辅助筛选优化,进而提高记忆检索的相关性和整洁度。此外,记忆系统设计还面对遗忘机制的挑战。无限制的连接增长导致知识图谱臃肿难以导航,智能地淡忘无用或低频访问的记忆成为必须。仿照人类大脑的记忆衰退机制,结合基于使用频率的权重衰减,甚至利用模型自身判断连接价值并执行删减,成为当前探索的有效策略。 情节化的记忆构造往往借助“事件”或“片段”作为基本单位,将每天的经历记录为一系列连续的文档,保证叙述的连贯性。通过连接前后的事件,可以构造完整的时间线,辅助模型在回答问题或进行推理时调用具体的背景资料。

同时,汇总每天、每周、每月甚至年度的总结,生成多层级的元文档,帮助智能体从宏观层面理解信息演变和主题发展。这不仅提升了记忆的深度,也使模型在长时段任务中保持稳定和连贯的表现。 知识检索的遍历策略同样决定了记忆的使用效率。简单地将大量相关文档放入上下文会造成功耗和效率低下,因此优先加入最相关的片段和摘要,通过优先队列策略优化节点的扩展顺序,是提高查询效果的关键。模型可以根据任务目标灵活调整检索范围和细节深度,实现对复杂问题的深度探索。此外,设计专门的遍历代理,赋予其上下文分析、加载及释放资源的能力,使其能够自主判断信息价值并合理规划查询路径,进一步增强系统的智能性和自适应能力。

外部数据库如SQLite的引入提供了另一层次的记忆支持。某些规范化、结构化数据,如世界首都名单、历史人物关系等,适合以表格形式存储,作为独立工具调用。这种做法模拟人类对工具使用的依赖,模型记忆到一定程度会选择停止盲目查询而转向可靠的数据库检索,既提升效率也增强信息准确性。将外部数据库视为辅助工具,而非核心记忆,促进了人机协同及分层管理的设计思想。 最简单且直接的记忆技术是基于“草稿本”的文本存储,将所有关键信息按时间顺序线性附加。尽管在容量受限时容易导致信息杂乱和重复,但其简易性和直观性使其成为低阶系统的首选。

通过模型主动筛选和压缩过期或无用信息,可优化草稿本的利用率,但此过程亦存在风险,如模型可能错误删除关键记忆,导致行为循环或认知失败。 记忆的多层结构设计体现了对不同信息类型的区分。核心人格特质、动机和价值观等深层知识,比起单纯的事件记忆需要更稳定和安全的存储方式,以防止通过记忆擦除改变个体本质。如此分层策略不仅提高了记忆的稳定性和安全性,也为未来个性化智能体的打造奠定了基础。 智能体对于记忆的掌控分为显式与隐式两种模式。显式控制允许模型主动决定保存、遗忘或修改记忆,增强灵活性,但受制于当前模型在自我认知和管理能力上的局限,易产生过度自信或误判。

隐式控制更贴近人类无意识的记忆形成过程,模型通过经历自动形成记忆,不主动干预,减少错误删除风险,两者的权衡和融合是未来研究热点。 从更长远角度看,神经网络方法可能彻底重塑记忆的实现。通过端到端训练的全局参数化网络,有望实现知识的无缝整合与动态更新。可能出现的技术形态包括极度稀疏专家模型或循环记忆单元,实现每日训练周期动态扩展和调整。然而,该方向尚处于探索阶段,具体形态和实现仍充满不确定性。 整体而言,当前LLM记忆系统更多依赖多种记忆机制组合,包括向量检索、知识图谱、元文档生成及分层管理。

各类机制在不同场景下相辅相成,共同支撑了智能体在复杂环境下的连续认知与推理。记忆系统的设计不仅关乎技术实现,更反映了人类认知的本质规律,推动人工智能向更加智能化、自主化方向发展。在未来,记忆技术将成为智能体认知能力提升的核心驱动力,助力机器真正实现类人思维模式及情境理解。 随着计算能力的提升和算法的进步,记忆系统正经历从简单文本存储到复杂动态知识管理的跨越。对时间空间参考框架的敏锐把握和合理利用,是保证长时语境连贯和知识准确性的前提。结合向量嵌入与结构化图谱技术,配合智能代理和外部工具,记忆系统逐渐具备自主管理、主动学习和高效检索功能。

未来,探索全神经方法并实现记忆的端到端优化无疑将掀起新一轮变革。而在这个过程中,保持记忆系统的可控性、稳定性和理解性,是应对复杂现实环境不可忽视的挑战。智能记忆的探索之路,正激发着人工智能领域的持续创新和深刻思考。